Flink有没有办法把changelog变成append模式?现在changelog模式window和sum() over()都用不了。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

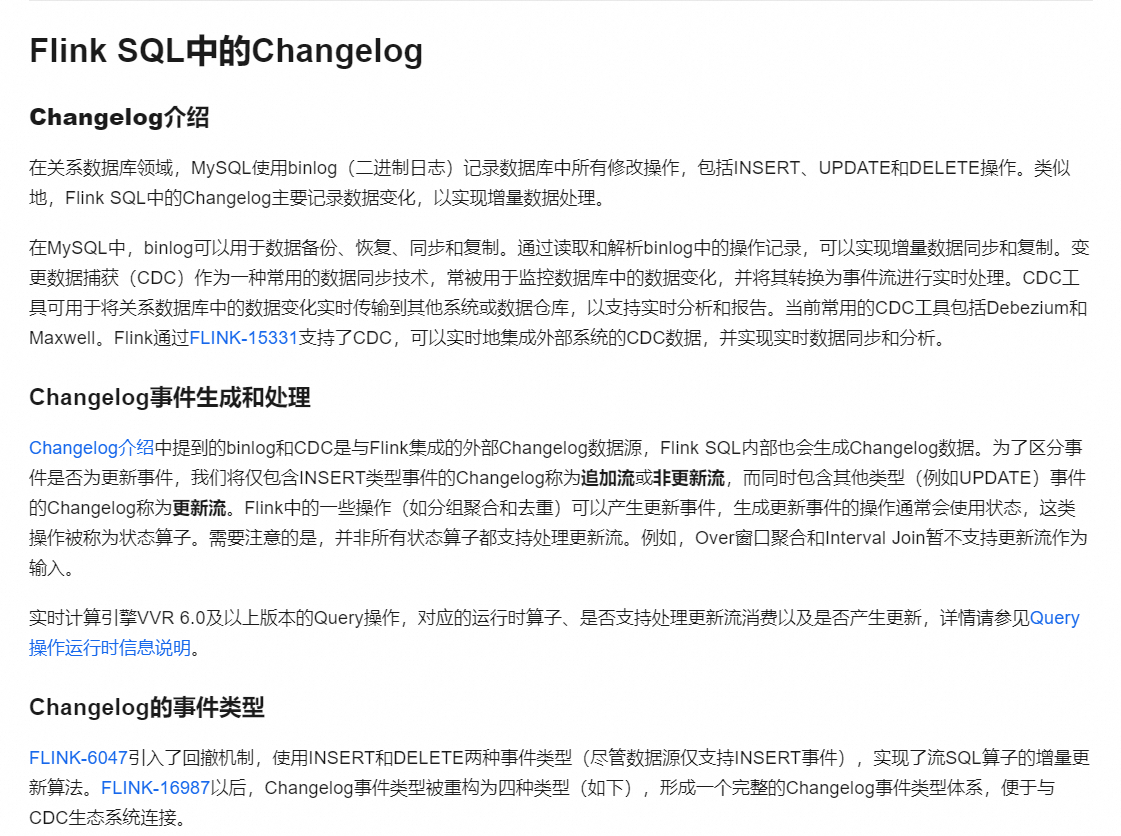

changelog可以表示为不同的模式,包括append-only、retract和upsert。要将changelog转换为append模式,可以通过Flink SQL的fromChangelogStream函数实现。

使用fromChangelogStream函数:这个函数允许你根据不同的场景解释changelog stream。例如,如果你想将changelog解释为upsert stream,而无需UPDATE_BEFORE,可以创建一个包含RowKind.INSERT和RowKind.UPDATE_AFTER的changelog DataStream,然后使用fromChangelogStream函数将其解释为表 。

利用Hudi的配置:在使用Apache Hudi时,可以通过设置changelog.enabled为true来启用changelog模式,这样能够保留所有的changelog记录,包括中间的变更。如果希望在Hudi表中使用append模式,可以通过调整compaction策略,比如设置compaction.delta_commits和compaction.delta_seconds参数来优化文件布局

你可以参考一下这个链接

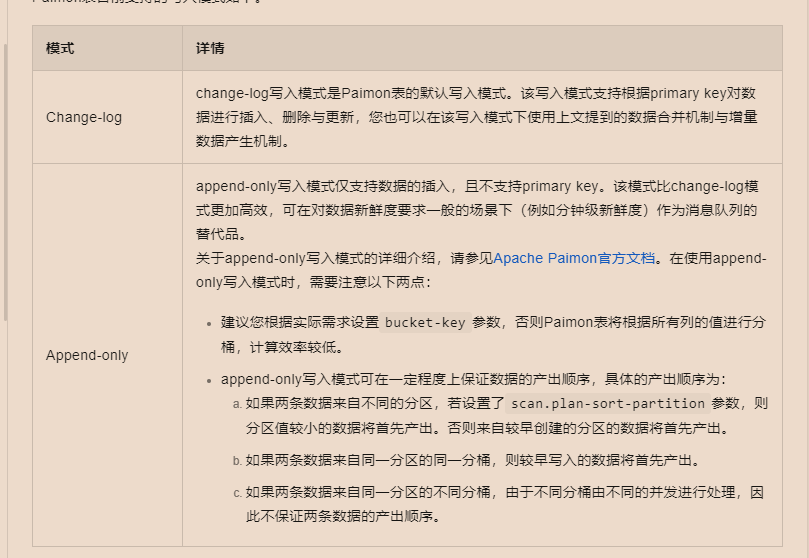

在Apache Flink中,直接将Changelog模式转换为Append模式并不直接支持,因为这两种模式服务于不同的数据处理需求。Changelog模式(Change-log Write Mode)设计用于支持根据主键的插入、删除与更新操作,并且可以结合诸如窗口聚合(window)和窗口函数(如sum() over())进行复杂的数据处理。而Append模式(Append-only Write Mode)仅支持数据插入,不支持主键更新或删除,并且通常在对数据新鲜度要求不那么严格且不需要复杂聚合操作的场景下使用。

不过,针对您希望在Changelog模式下使用窗口函数和sum() over()的需求,可以通过调整Flink作业的配置和逻辑来间接实现类似效果:

增量数据产生机制:Paimon作为Flink的存储层,提供了几种增量数据产生机制,如changelog-producer配置为input、lookup或full-compaction。虽然这些机制主要针对Paimon表的维护和优化,但确保数据以适合处理的格式进入Flink作业是基础。特别是lookup机制,它能在每次快照前生成完整增量数据,适合对数据新鲜度要求较高的场景,尽管资源消耗相对较大。

窗口策略调整:对于窗口操作,如果是因为Changelog数据流导致的问题,可以考虑在数据源处或数据流入Flink之前,通过外部系统(如Kafka的Log Compaction功能)预处理数据,使其更适合窗口聚合。或者,在Flink作业中合理设置时间窗口大小和滑动窗口策略,以适应Changelog数据的特性。

使用Table API或SQL:Flink的Table API和SQL支持丰富的窗口函数和聚合操作,包括sum() over()。确保你的作业正确使用了这些API,并且理解它们在Changelog数据上的行为。有时,通过调整Table Schema定义,比如明确指定主键和时间属性,可以帮助Flink更有效地处理Changelog数据。

综上所述,虽然直接将Changelog模式转变为Append模式不可行,但通过优化数据处理策略、选择合适的增量数据产生机制及调整作业配置,可以在Changelog模式下有效利用窗口函数和sum() over()等聚合操作。

您可以考虑将Paimon表的写入模式改为Append-only模式<

Append-only模式特点:

为了切换到Append-only模式,您需要在创建或修改Paimon表时指定写入模式为Append-only。这样,您的Flink作业就可以在该表上顺利执行窗口操作和窗口函数,因为Append-only模式避免了Change-log模式下因数据更新和删除带来的复杂性。

通过将Paimon表的写入模式从Change-log改为Append-only,您可以解除在使用window和sum() over()等操作上的限制,从而在Flink中实现所需的功能。

Flink SQL中的Changelog模式分为追加流(非更新流)和更新流。如果您的数据源产生了UPDATE事件,那么就会是更新流模式。某些操作如窗口和OVER子句可能不支持处理更新流。您可以通过以下两种方式尝试解决:

数据转换:在窗口或SUM() OVER()等操作前,先将UPDATE事件转换为INSERT事件,例如通过自定义函数处理,将UPDATE_BEFORE和UPDATE_AFTER合并为新的INSERT事件。

使用支持更新流的操作:选择支持更新流的状态算子,但请注意,并非所有Flink算子都支持,例如Over窗口和Interval Join就不支持。

参考Query操作运行时信息说明

Flink可以通过配置Paimon表的写入模式来实现将Changelog模式转变为Append模式。在Paimon表的配置中,您可以将write-mode参数设置为append-only,这样Paimon表将只接受数据的插入操作,不再支持基于主键的更新和删除,从而达到将Changelog模式转变为Append模式的目的。这将使得窗口函数(如window)和聚合函数(如sum() over())能够正常使用,因为这些操作通常要求数据是附加型的,而非变更日志形式

这样就可以啦

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。