【AI大模型知识干货系列】从基础原理到实战应用,从技术迭代到行业落地,拆解大模型核心逻辑,破除认知壁垒。后续将持续输出单篇深度内容,涵盖入门科普、技术解析、场景案例、避坑指南等干货,助力你系统掌握AI大模型相关知识,跟上技术浪潮~ 每一篇都经过精心打磨,聚焦一个核心知识点,通俗易懂且兼具深度,欢迎持续关注!

您的认可将会鼓励我更高频、更高质量的完成图文输出,您的批评也将会让我的博文更精准。

所以,不要吝啬您的评价、点赞

📍 位置编码详解

🎯 概述

位置编码为Transformer提供序列位置信息,因为注意力机制本身不包含位置概念。

🏗️ 位置编码类型

1️⃣ 绝对位置编码

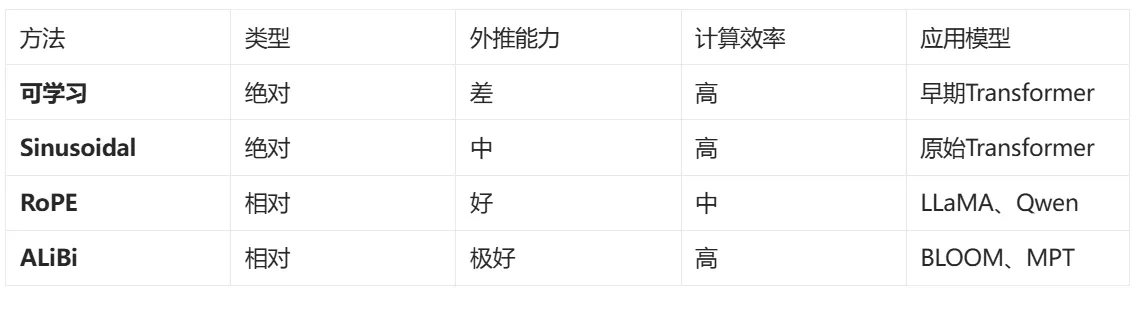

可学习位置编码

原理:将位置作为可训练参数

优点:简单直接,可适应任务

缺点:固定长度,泛化性差

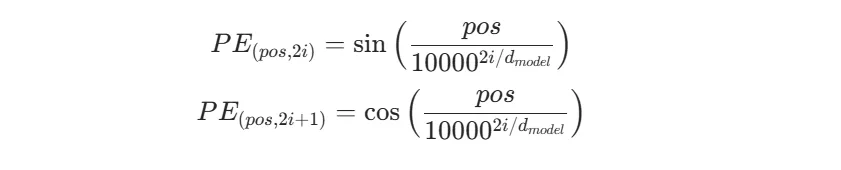

Sinusoidal位置编码

原理:使用正弦和余弦函数

公式:

2️⃣ 相对位置编码

RoPE (旋转位置编码)

原理:通过旋转矩阵编码相对位置

优点:支持任意长度,相对位置感知

应用:LLaMA、ChatGLM等

ALiBi (Attention with Linear Biases)

原理:在注意力分数中添加线性偏置

优点:外推能力强,计算高效

应用:BLOOM、MPT等

📊 编码方法对比

🎯 面试重点

为什么需要位置编码?

RoPE相比绝对位置编码的优势?

如何处理超出训练长度的序列?