开发者学堂课程【DataWorks一站式大数据开发治理平台精品课程:MaxCompute+DataWorks 最佳实践】学习笔记,与课程紧密联系,让用户快速学习知识。

课程地址:https://developer.aliyun.com/learning/course/81/detail/1249

MaxCompute+DataWorks 最佳实践(二)

22、配置好之后,这是在配置的过程中,把它提交到开发环境和生产环境里面去,点击提交,把所有的节点都提交,收入输出不一致。

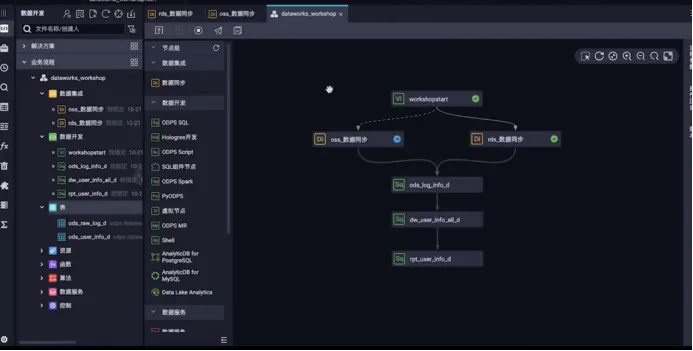

23、可以看到这三个节点会依次显示提交成功,提交成功之后,它们现在就到了发布的环境里面,到了发布环境,可以点击运行,先看一下是不是能够正常的跑成功。如果跑成功之后,就说明已经完成了数据的采集,那接下来就要对采集上来的数据做加工,加工的目的主要是为网站的用户访问的用户进行一个用户画像的分析。数据的加工会在三个层面上进行,第一个是 ods 层的一个加工,第二层是 dw 层的加工,第三层还有一个 rpt 层的加工,可以先看整个的流程,同样的还是去配置三个数据开发的节点,配置好节点之后,还要为数据开发节点去建立三张表格,用来存储的建表语句。先创建数据开发的内容。首先要去开发三个节点,节点叫做ods_log_info_d。

24、还有一个是 dw 层,dw_user_info_all_d。

25、再创建一个 rpt 层,rpt_user_info_d。

26、按顺序把它们的依赖关系配置一下,数据同步之后 ods 依赖数据同步,dw 依赖odps 层,rpt 是依赖于 dw 层,那把基本的数据加工的流程也构建好了。

27、配置数据加工的节点,加工节点之前,要去建立三张表格,用来存储数据加工的内容。再去新建表,新建表 ods_log_info_d。

28、依然采用 ddl 的建表语句。这张表可以看到表结构,它都自动上传上来,点击提交。

29、再建立 dw 层的表格,dw_user_ Info_all_d。

30、现在利用 dll 模式新建一张表格,提交以后,这张表写好了,再建立一张表格是给 rpt 层,rpt_user_info_d。

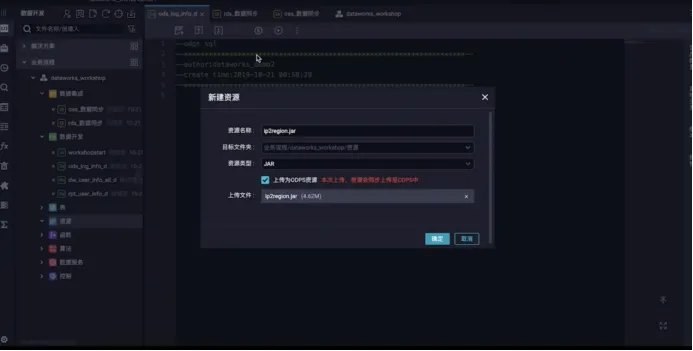

31、复制建表语句,那么这张表也解析出来了,可以看到字段都已经收过来了,提交之后,这三张表格都建立好了,接下来去配置数据加工的机制,双击,写入 SQL 语句。首先是要配置 ods 层的数据加工的节点,在创建之前,因为 ods 层会用到一个自定义的一个函数,那这里面函数怎么调用?线下写好的怎么调用?写好的是在一个jar 包里面,那要把就是 jar 包上传上来。右键新建资源,选择 jar 包的形式,目标包都是直接设定好的,直接搜索 ip2region.jar。

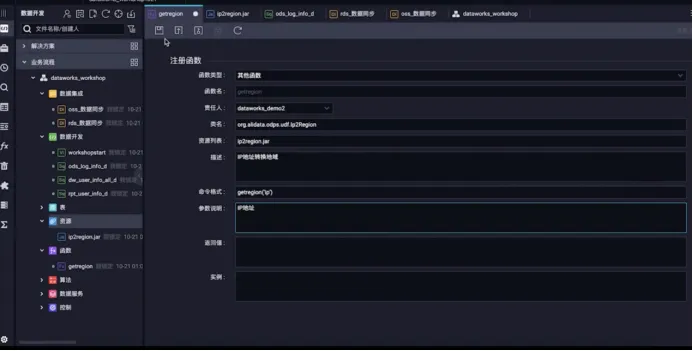

32、上传之后要提交,随便写备注。资源提交成功了之后,要去新建一个函数,因为资源已经传到开发平台上来了,那要把它解析出来成一个函数,新建一个函数,新建一个函数,给它取名叫 getregion。

33、可以看到注册函数的类型,它的使用说明,直接点击把这些填好的放进来,它说明写好了,责任人是当前账号,描述就是指函数用来做什么的,它主要是用来将数据表里面的 IP 地址转化成地域。这些都配置好之后,要把它点击保存,保存之后再把它提交到开发生产的环境,提交成功。

34、那 oss 层,对 ods 层用到的资源已经上传好了,进行 ods 层的节点的加工,那么首先配置它的 sql 节点,主要是写的内容也在这,直接复制过来。保存,这个加工节点就配置好了,配置好之后,再去配置 dw 层,第 dw 层依然是采用建表语句,把它复制,双击把 SQL 语句切进来。保存成功之后,再接下来配置 rpt 层的数据加工的内容,应该是 SQL 语句,写加工的逻辑。保存之后,数据加工的内容也已经被它设置好了,可以看到数据采集过程它都已经通过了,说明逻辑整个是通的,右键节点选择运行节点下游,看数据加工层的逻辑是否是正常通顺的。接下来要做的是把整个任务的工作流程将它提配置好之后,将它提交到开发和生产环境。那点击左上角提交框,把整个流程提交,刚刚数据采集的三个节点已经配好了,那这回提交开发的三个节点,已经把它提交了。

35、提交之后要把它发布到流程里面,提交了之后它只是进入了的开发环境,那开发环境的任务它是不会自动调度的,需要把它所有配置的任务提交到生产环境去,生产环境才会去执行的任务的调度。点击页面上的发布的按钮,刚刚提交上来的所有的节点,包括的资源它都提交上来了,将所有的资源都添加到待发步的内容中,代发步列表里面就会显示有8项待发布,把所有的项全部打包发布,一次性交给任务节点都打包发布。

36、前两步已经跑通了,接下来看第三步。可以看到待发布的列表里面没有了,说明已经都提交好了,看发布包的列表,可以看到刚刚发布的内容,里面是有8项,现在点击的状态是已经成功了,那说明这些节点都已经成功的上传到了生产环境里面,也就是接下来可以去做任务调度的活动了。

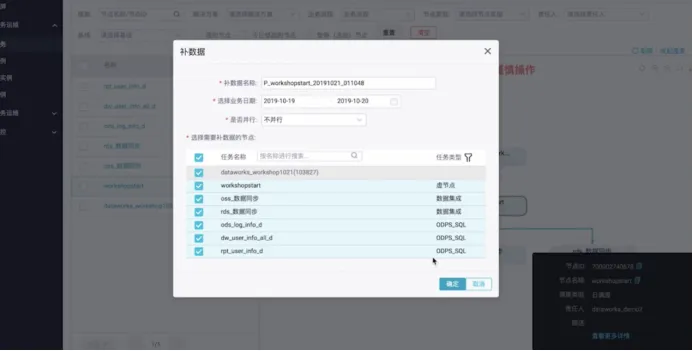

37、可以看到业务流程的逻辑顺序也已经都跑通过了,说明创建的内容是没有问题,数据开发的加工的内容就已经完成了,完成之后要去生产环境去运行任务,定期的调度它。那今天可以到运维中心去,因为正常任务调是至少要在明天才会正常跑通,为了快速实现效果,去到运维中心给它做一个补数据的操作。运维中心也是在左侧栏全部产品里面的运维中心,点击,进入运维中心,在周期任务里面找到刚刚提交的任务,选择的虚节点,那从虚节点开始去运行,给它做一个补数据的操作,运行当前补数据到当前节点及下游节点,那就是对所有的节点都去补数据,业务日期就选择前一天就可以,等它运行成功之后,就可以看到一个运行的结果,数据加工以及任务调度的功能已经做好了。

38、运行成功之后,接下来是做一个数据监控规则的一个配置,数据表里面的数据内容有没有异常情况,dataworks 里面,点击全部产品有一个数据质量的功能,在数据治理里面点击数据质量,那数据质量就可以去配置对某一张表的某一个分区下面的一个数据质量监控规则这么一个配置,进入到数据质量的界面选择规则配置。这里面可以为表配置一个监控规则,可以有两种监控的数据源,一个是离线的 odps 的数据,还可以监控 datahub 实时的数据,本次是一个离线的数据。

39、给生产环境的表进行数据监控的配置,本次配置是为 odswell 这张 p 表来进行配置,点击配置监控规则,首先可以看到它是没有任何配置规则内容的,首先给它添加一个分区,具体的制造规格配置都是在分区下面进行的,可以看到有很多这种分区的说明,本次选择 t-1的形式,如果调度的时间是21号,那计算的结果是到前一天20号。

40、添加分区之后,它就会在分区下提醒创建规则。点击创建规则,规则是有两种,一种是给内置了三十几种的模板,如果觉得模板还不够用,可以去选择自定义规则,本次选择的是模板规则,添加模板,因为表格的内容给它设置的规则是以表行数和固定值的内容,规则演示,本次给它配置的是表级规则,规则模板是表行数固定值,比较方式是大于0。还有一个规则可以判断强弱,如果是强规则,如果条规则发现有异常,会立马进行阻断,停止的操作,这样是为了防止避免让数据流到下游,可以阻塞当前节点下面的工作的运行,立即停止,如果是配置成弱规则,它只是做到一个报警提醒的工作,但是不会阻塞下游的节点的运行,本次配置一个强规则,配置好之后把它保存。

41、保存之后就可以看到在分区下面有模板的规则了,可以试跑,提供试保的功能,试跑成功。

42、数据质量监控规则它怎么样正常的运行?运行是要去关联调度到某一个任务节点上面去,这样当节点启动时,这条规则就会同步被执行。有一个关联调度的按钮,可以分期选择搜索需要的,将它关联的基本内容添加。需要关联这条规则的节点已经添加进来了,那当节点运行时,这条规则就会被自动运行,可以看到这已经变成正常的颜色。