引言:AI的“基础教育”革命

你是否好奇过,为什么现在的AI模型,比如ChatGPT,既能和你聊哲学,又能帮你写代码,甚至还能分析财务报表?它难道是在某个“AI大学”里,把所有专业都学了一遍吗?

某种意义上,是的。这个“大学”阶段,在AI领域被称为 “预训练” 。它是当今所有强大AI模型(无论是处理文字的GPT、DeepSeek,还是处理图像的Stable Diffusion)的“筑基”环节,是让模型从一张白纸变成“通才”的关键一步。

想象一下,你要培养一位顶级律师。你不会直接扔给他一摞复杂的案件卷宗,而是会先让他接受十几年的通识教育——学习语言、逻辑、历史和社会知识。预训练做的就是这件事:它使用互联网级别的海量文本、图像数据,让模型学会人类世界的“基本规则”——语言的语法、词汇的关联、图像的构成、世界的常识。

掌握了这些“通识”的模型,就像一个具备了强大学习能力的大学生。当我们需要它从事特定工作(比如成为你的法律助理、营销文案写手或代码助手)时,我们只需要对它进行短期的“专业培训”,这个过程就是 “微调” 。预训练+微调,这套组合拳彻底改变了AI开发的范式,让尖端技术得以快速落地到千百个具体场景中。

本文将带你轻松理解预训练的核心原理,并重点探讨如何通过“微调”这一步,将通用的“通才”模型,变成解决你独特问题的“专属专家”。

技术原理:模型如何“博览群书”?

预训练听起来很高大上,但其核心思想非常直观:让模型通过完成一些“填空”或“接龙”游戏,来自我学习数据中的规律。

关键在于,这些游戏是“自监督”的。我们不需要人工给海量数据打标签(那将是天文数字的成本),而是直接从数据本身构造出学习任务。主要有两大流派:

1. 文本世界的预训练:语言模型的“左右互搏”

对于文本大模型(LLM),最主流的预训练方式有两种:

- “下一个词预测”(自回归模型,如GPT系列): 这就像玩一个无限长的词语接龙。给模型一句话的前几个词,比如“今天天气很好,我决定去...”,让它不断预测下一个最可能的词是“公园”、“跑步”还是“购物”。通过在整个互联网文本上反复玩这个游戏,模型逐渐学会了语法、逻辑、事实知识甚至写作风格。它理解了在“我决定去”后面,接“公园”的概率远大于接“冰箱”。

- “完形填空”(掩码语言模型,如BERT早期): 随机把一句话中的某些词盖住(例如:“今天[MASK]很好,我决定去公园”),然后让模型根据上下文来猜被盖住的是什么词。这个过程迫使模型不仅仅看前面的词,还要同时看后面和前面的所有词,来理解完整的语境,从而学会更深入的语义关联。

2. 图像世界的预训练:让模型学会“看图说话”与“拼图”

对于视觉模型,思路也类似:

- 对比学习(如SimCLR): 给模型一张猫的图片,然后对这张图片做一些不影响本质的变化(旋转、裁剪、调色),生成两张“看起来不同但本质一样”的图片。同时,再混入一张狗的图片。模型的任务是学习分辨:哪两张图本质是相似的(都是猫),哪张是不同的(狗)。通过海量练习,模型就学会了抓住图像最核心的特征(比如猫的胡须、眼睛的形状),而不被无关细节干扰。

- 图像重建(如MAE): 这更像是高级拼图。随机把一张图片的75%甚至更多的部分都遮盖掉,只给模型看剩下的零碎 patches,然后让它凭借想象力和学到的规律,把整张图片还原出来。这个过程极大地锻炼了模型对图像整体结构和语义的理解能力。

总结一下预训练的本质: 它是一个通用知识注入的过程。模型在“预训练大学”里学到的不是某个具体技能,而是关于这个世界(文本或视觉)的基础表示和通用规律。这为下一步——成为某个领域的专家——打下了无比坚实的基础。

实践步骤:如何打造你的“专属专家”?

理解了预训练是打造“通才”之后,最关键的一步来了:如何让这个“通才”为你所用,变成精通你业务的“专才”?这就是 “微调” 的舞台。

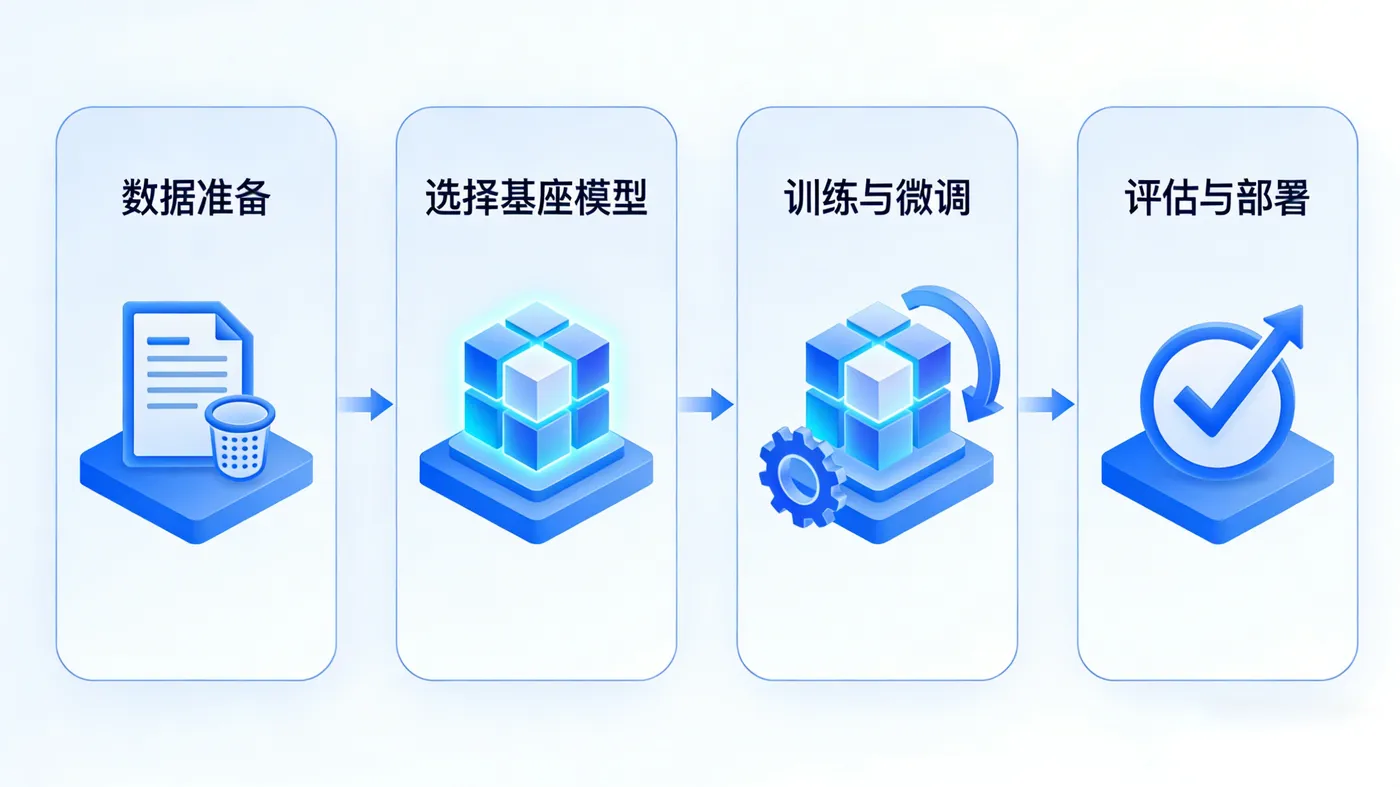

微调,就是在预训练好的大模型基础上,用你特定的、规模较小的专业数据集,对它进行额外的训练。这就像让那位博览群书的大学生,再去攻读一个法律硕士学位。整个过程可以清晰地分为以下几步:

第一步:明确目标与准备数据

这是最重要的一步。你需要想清楚:我希望模型帮我做什么?

任务类型: 是智能客服问答?是法律文书摘要?还是根据描述生成产品图片?

数据准备: 根据任务,整理你的“教材”。例如:

- 对于客服模型: 整理历史客服对话记录(用户问题 - 标准回答)。

- 对于文案生成模型: 整理你公司的优秀产品介绍、宣传文案。

- 数据质量至关重要,需要经过清洗、去噪、格式化。

第二步:选择与加载基座模型

选择一个合适的、经过预训练的“通才”模型作为起点。例如,对于中文任务,可以选择ChatGLM、Qwen、LLaMA等系列的开源模型。这一步决定了你专家的“先天智力水平”。

第三步:配置微调方法与参数

这是技术核心,但原理不难理解。你需要决定:

- 微调哪部分? 是调整模型全部参数(效果可能最好,但成本高),还是只调整部分关键参数(如LoRA方法,高效且省资源)?对于大多数入门者,推荐使用LoRA等高效微调方法,它能在保持原模型知识不丢失的前提下,以极低的成本注入新知识。

- 学习率等“教学参数”: 就像老师教学的速度,太快容易学歪,太慢效率低下。通常需要设置一个较小的学习率,进行“精细化”教学。

第四步:开始训练与监控

启动训练,平台或你的代码会开始用你的数据“教”模型。这个过程需要监控损失值(loss)的下降曲线,它直观反映了模型“学习”的效果。就像看学生的成绩是否在提升。

第五步:模型评估与部署

训练完成后,用一组模型没见过的测试数据来“期末考试”,验证其在实际场景中的表现。如果效果达标,就可以将这个焕然一新的“专属模型”部署到你的应用或系统中,开始为你服务。

效果评估:如何判断微调是否成功?

训练完了,怎么知道我的“专属专家”是不是真的变聪明了?可以从以下几个维度评估:

任务指标量化: 根据你的任务类型,选择客观指标。例如:

- 问答/分类任务: 使用准确率、F1分数。

- 文本生成任务: 可以使用BLEU、ROUGE分数(衡量生成文本与参考文本的相似度),但更重要的是人工评估其流畅性、相关性和有用性。

对比实验:

- 与微调前对比: 将同一个问题,分别扔给原版“通才”模型和你的“专才”模型,看谁的回答更专业、更符合你的需求。这是最直接的检验。

- 与基线模型对比: 如果有其他解决方案,可以对比效果。

实用性测试(最重要): 设计一批贴近真实使用场景的测试用例,进行端到端的评估。比如,让微调后的客服模型处理20个真实的用户咨询历史记录,看其回复是否令人满意。

总结与展望

回顾一下:预训练赋予了AI模型通用的“知识底座”和“学习能力”,是它成为“通才”的基石;而微调则是基于这个底座,进行高效的、定向的“技能培训”,是打造解决你具体问题“专才”的钥匙。

这套“预训练-微调”范式,极大地 democratize(民主化)了AI能力的应用。企业和个人不再需要从零开始训练一个耗资巨大的模型,而是可以站在巨人的肩膀上,以相对低廉的成本,创造出巨大的业务价值。

未来,预训练技术本身会向着更高效(用更少的算力、数据)、更通用(融合文本、图像、音频的多模态大模型)、更专业(针对垂直领域预训练)的方向发展。而微调,作为连接通用大模型与具体需求的桥梁,其工具和平台必将变得更加智能和易用。

展望未来,AI的应用门槛会越来越低。就像今天普通人也能用图形化工具做网站一样,未来每个人都有可能拥有自己定制的AI助手。在这个过程中,像 LLaMA-Factory Online 这样的平台扮演着关键角色。它让没有代码基础的业务专家、创业者、学生也能轻松跑完微调全流程,在实践中真切地理解如何“调教”模型,让模型真正“更像你想要的样子”。如果你对打造属于自己的AI助手感兴趣,从这样一个可视化的实践平台开始,无疑是最快、最平滑的路径。

技术的终极意义在于赋能。希望这篇文章和这些工具,能帮助你更好地理解并驾驭AI微调这项强大技术,创造出属于你自己的智能解决方案。