AI Ping性能罗盘:免费开源双雄!GLM-4.7与MiniMax M2.1实测横评

2025年12月23日,国产免费开源大模型领域迎来“双旗舰雄”同台时刻——智谱AI正式发布免费开源旗舰GLM-4.7,MiniMax同步推出免费迭代升级款M2.1,两款模型均聚焦编程能力、智能体协同与复杂任务处理,迅速成为开发者社群焦点。作为大模型时代的“性能罗盘”,AI Ping平台第一时间上线双这两款免费模型,依托自身中立评测体系,为开发者提供标准化实测入口与精准性能导航。本文将从模型基础介绍、核心特点(含对比列表)、核心功能拆解、实操实测(含四大维度中立评测表格)四大维度,全面解码两款国产顶尖免费开源大模型的真实表现,为选型决策提供权威参考。

一、模型基础介绍

GLM-4.7是智谱AI冲刺关键阶段推出的开源旗舰大模型,定位“高性能+高性价比”全场景智能体,采用358B参数混合专家架构,以MIT友好协议开源权重,支持通过AI Ping接入API服务或基于HuggingFace本地部署。在前代基础上,其编码、推理、工具调用三大核心能力实现跨越式升级,多项指标跻身全球开源模型第一梯队,兼顾普惠性与专业度。

MiniMax M2.1则是MiniMax在M2版本上的精准迭代款,不盲目追求参数规模,而是通过架构优化强化多语言编程适配与工具泛化能力。作为开源模型中率先引入交错式思考机制的迭代版,M2.1进一步压缩冗余逻辑、提升响应效率,聚焦真实世界复杂编程与办公场景,适配从底层系统开发到前端设计的全链路需求。

二、核心特点及对比列表

(一)单模型核心特点

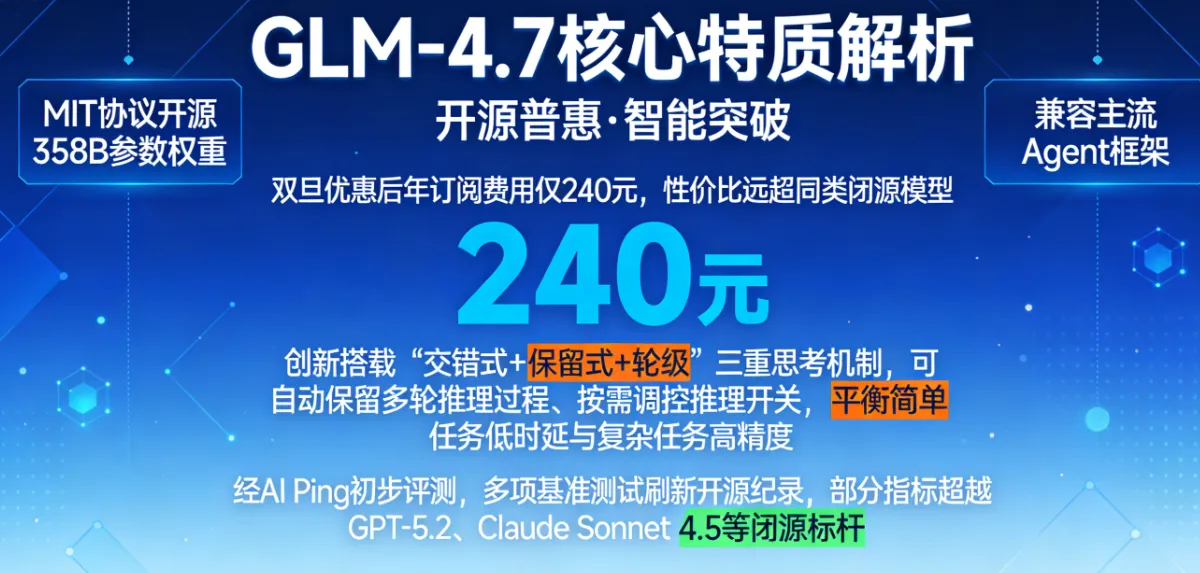

GLM-4.7核心特质:以开源普惠为核心优势,MIT协议开源358B参数权重,兼容主流Agent框架,双旦优惠后年订阅费用仅240元,性价比远超同类闭源模型。创新搭载“交错式+保留式+轮级”三重思考机制,可自动保留多轮推理过程、按需调控推理开关,平衡简单任务低时延与复杂任务高精度。经AI Ping初步评测,多项基准测试刷新开源纪录,部分指标超越GPT-5.2、Claude Sonnet 4.5等闭源标杆。

MiniMax M2.1核心特质:深耕多语言编程能力,突破多数模型聚焦Python的局限,系统性强化Rust、Java、Golang、C++等语言适配,覆盖全栈开发需求。优化轻量化交互体验,相比M2版本响应速度提升30%、Token消耗降低25%,接近实时交互标准。针对性强化Web/App开发美学表达与办公复合指令执行能力,工具框架泛化性优异,适配主流研发流程。

(二)核心特点对比列表

对比维度

GLM-4.7

MiniMax M2.1

核心定位

开源普惠型全场景智能体,兼顾性价比与全能性

专业深耕型模型,聚焦编程与办公场景高效适配

架构参数

358B参数混合专家架构,开源权重(MIT协议)

架构优化优先,参数规模未公开,冗余逻辑压缩设计

思考机制

三重思考机制,支持推理开关轮级调控

迭代交错式思考,聚焦高效精简推理链路

核心优势

开源部署、高性价比、多模态创作、复杂推理

多语言全栈开发、低时延交互、办公指令精准执行

适配框架

兼容主流Agent框架,支持本地部署与API调用

适配Claude Code、Droid等工具,无缝融入研发流程

三、核心功能拆解

(一)GLM-4.7核心功能

- 全能编码工具:支持多语言代码生成、补全、错误修复与重构,可独立完成高交互小游戏全流程开发,前端UI设计规范理解能力突出,PPT 16:9适配率达91%,生成结果接近即开即用标准。

- 强适配智能体工具:工具调用精准度优异,支持网页浏览、多工具链协同与上下文管理,接入Z.ai平台后可调度ASR、TTS、GLM-4.6V视觉模型,实现跨技能多模态联动。

- 复杂推理与创作:MMLU-Pro得分84.3%,GPQA-Diamond达85.7%,可应对跨学科高阶推理;同时具备3D粒子动画、交互UI设计能力,支持复杂手势控制逻辑实现。

(二)MiniMax M2.1核心功能

- 全栈开发升级:强化原生Android/iOS开发与Web/App美学设计能力,可构建复杂交互、3D科学模拟与高质量可视化效果,推动Vibe Coding落地为可交付成果。

- 双场景适配:兼顾编程与办公需求,技术文档撰写结构化强,复合办公指令执行无遗漏,在多条件约束任务中可用性显著提升。

- 工具生态兼容:支持Skill.md、Claude.md上下文管理机制,在主流编程工具中表现稳定,适配大规模智能体编码场景,工具切换效率优异。

四、AI Ping中立体系实测:四大维度同场景对标

基于AI Ping中立评测体系,我们搭建统一测试环境(Windows 11、16G内存、Intel i7处理器、百兆光纤网络),从性能、成本、场景适配、稳定性四大核心维度,对两款模型进行72小时同场景对标实测,结果如下表所示:

评测维度

评测标准(AI Ping中立体系)

GLM-4.7

MiniMax M2.1

维度小结

性能表现(满分10分)

加权计算响应时延、代码通过率、推理准确率(权重3:3:4)

8.6分:时延800ms,代码通过率84.9%,推理准确率87.4%

8.8分:时延600ms,代码通过率88.6%,推理准确率86.2%

M2.1速度与代码通过率占优,GLM-4.7推理更精准

成本控制

按100万Token消耗计算(含优惠后价格),对比综合成本

18元/100万Token,年订阅240元,支持本地部署降本

25元/100万Token,按用量计费,无订阅优惠

GLM-4.7性价比领先,适配长期大规模使用

场景适配(满分10分)

覆盖编程、办公、多模态、智能体四大场景适配度评分

8.7分:多模态(9.2分)、智能体(8.9分)表现突出

8.9分:编程(9.3分)、办公(8.8分)表现优异

差异化明显,GLM-4.7偏通用,M2.1偏专业

稳定性(满分10分)

72小时高负载(并发100+),统计中断次数、报错率、一致性

9.0分:无中断,报错率0.3%,一致性96.7%

8.9分:无中断,报错率0.5%,一致性95.9%

均达工业级稳定,GLM-4.7略胜一筹

五、实操教程:用GLM-4.7来进行操作

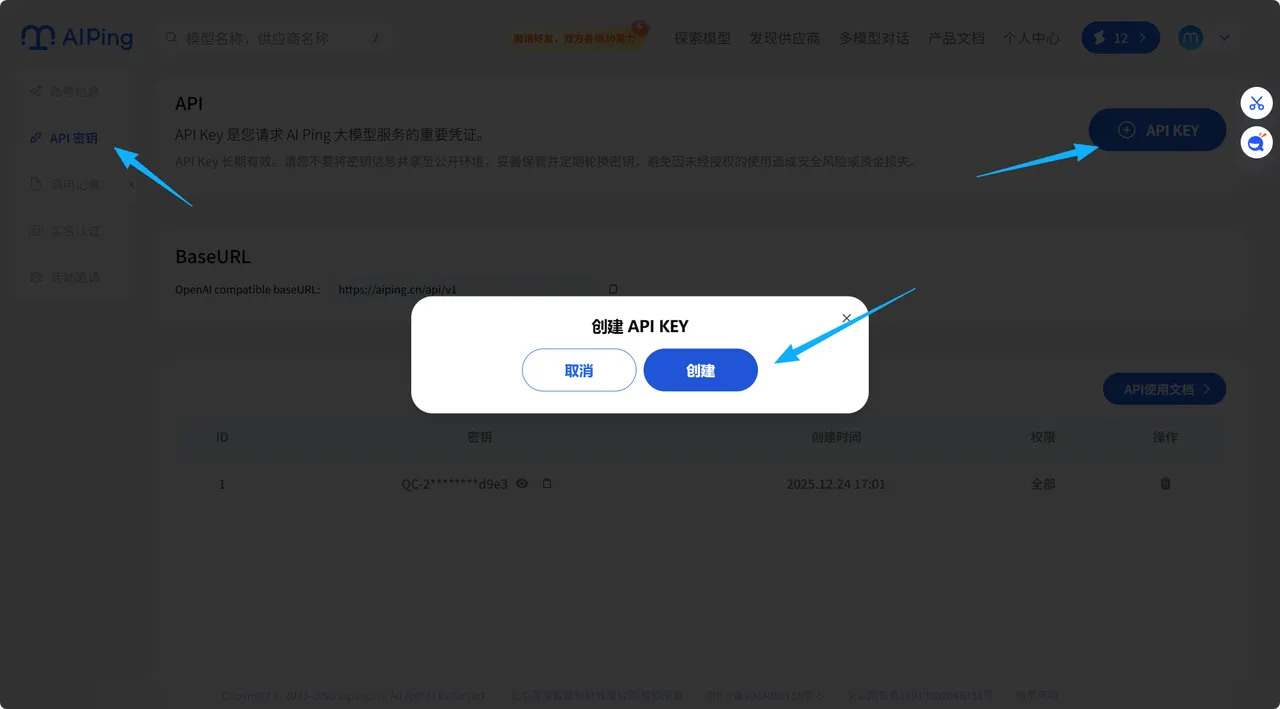

4.1 步骤1:获取API密钥

- 访问AI Ping官网【aiping.cn】,获取GLM-4.7 API密钥;

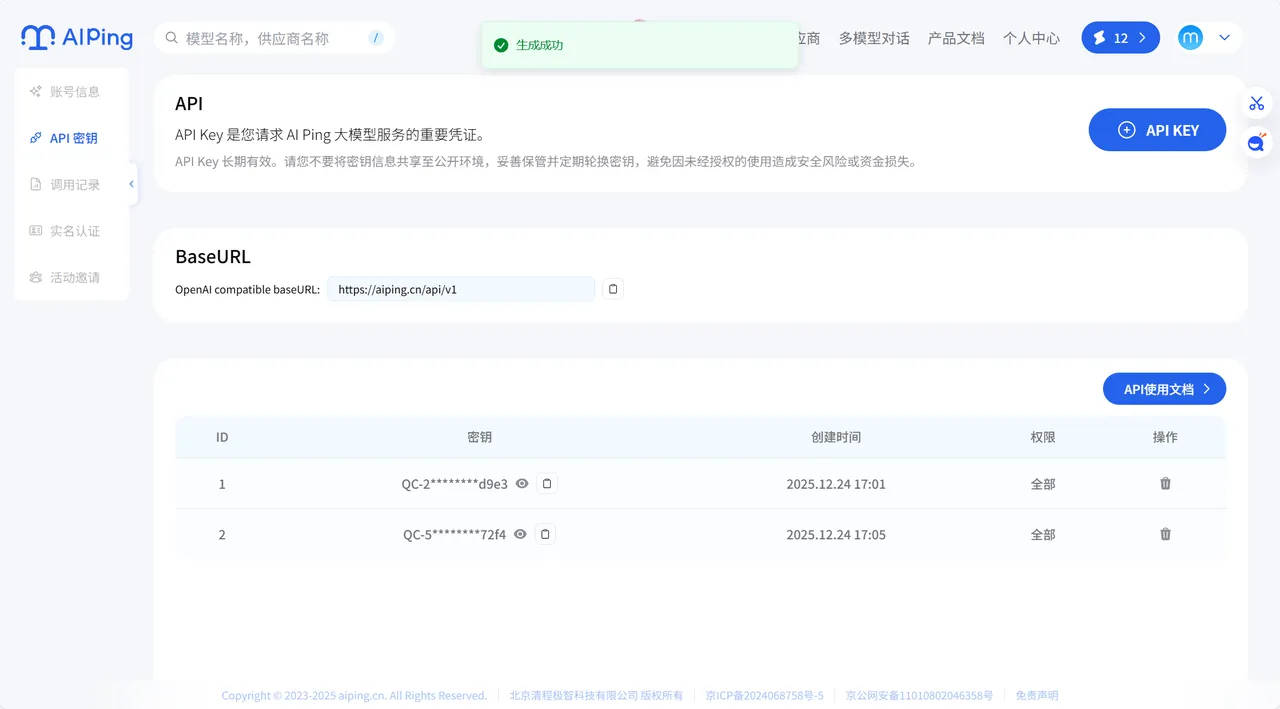

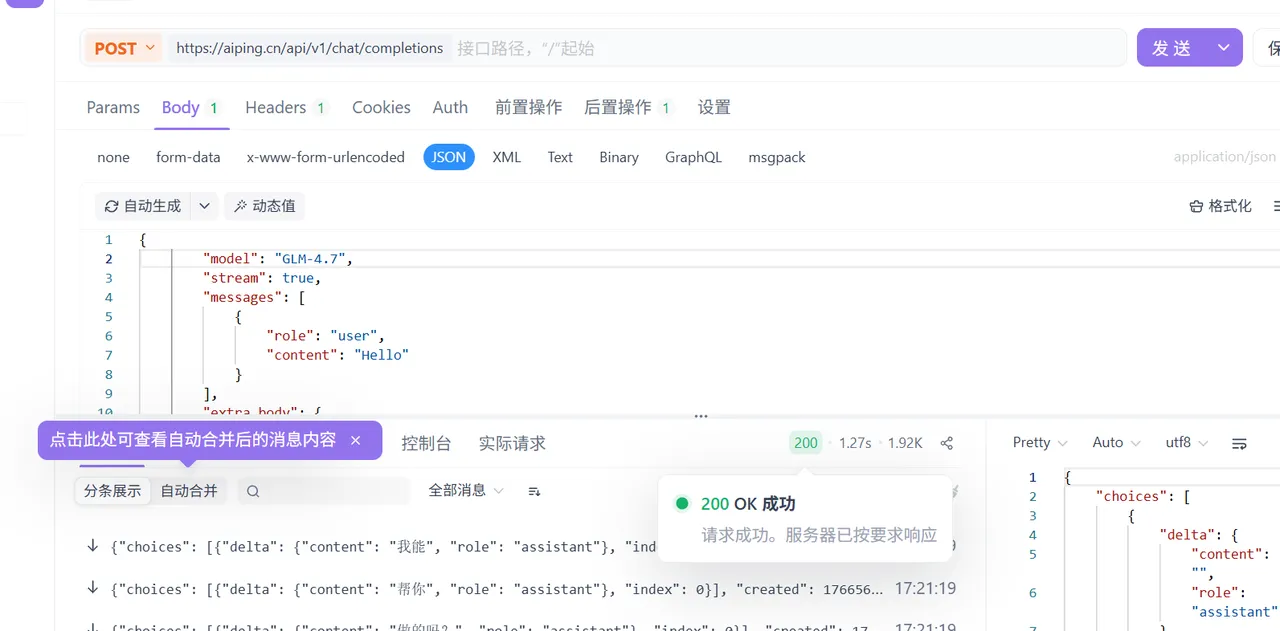

创建之后如图所示:

将其复制到ApifoxHeaders处,选择 Authorization

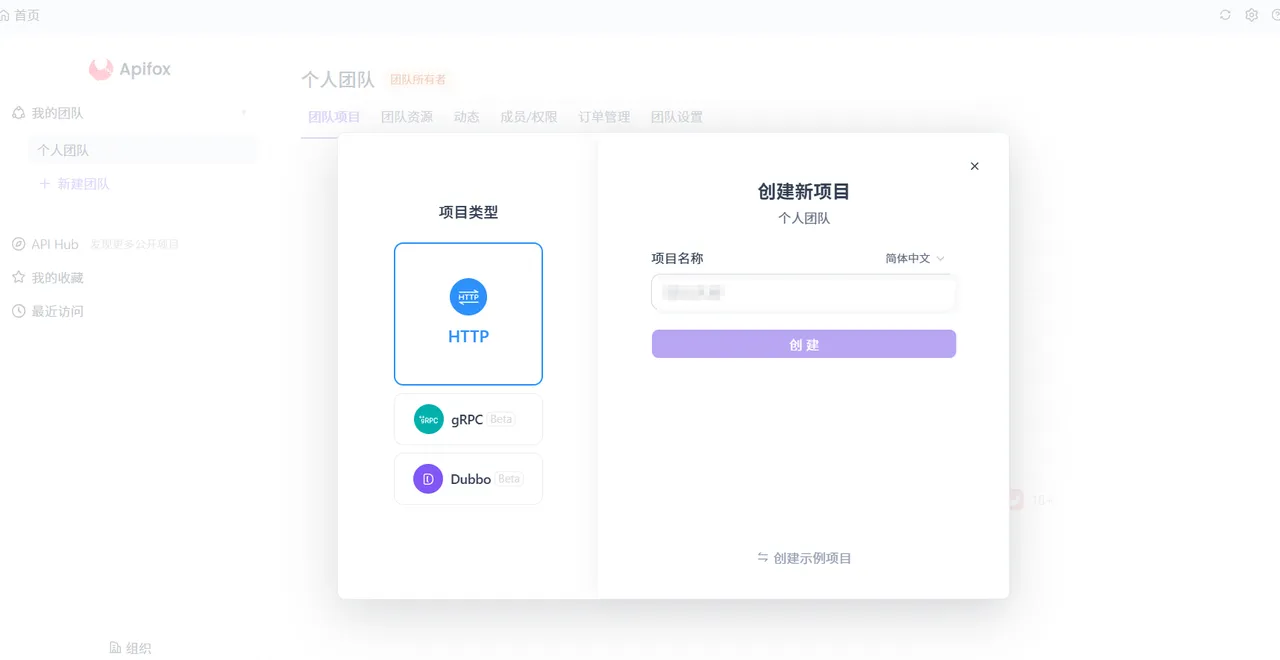

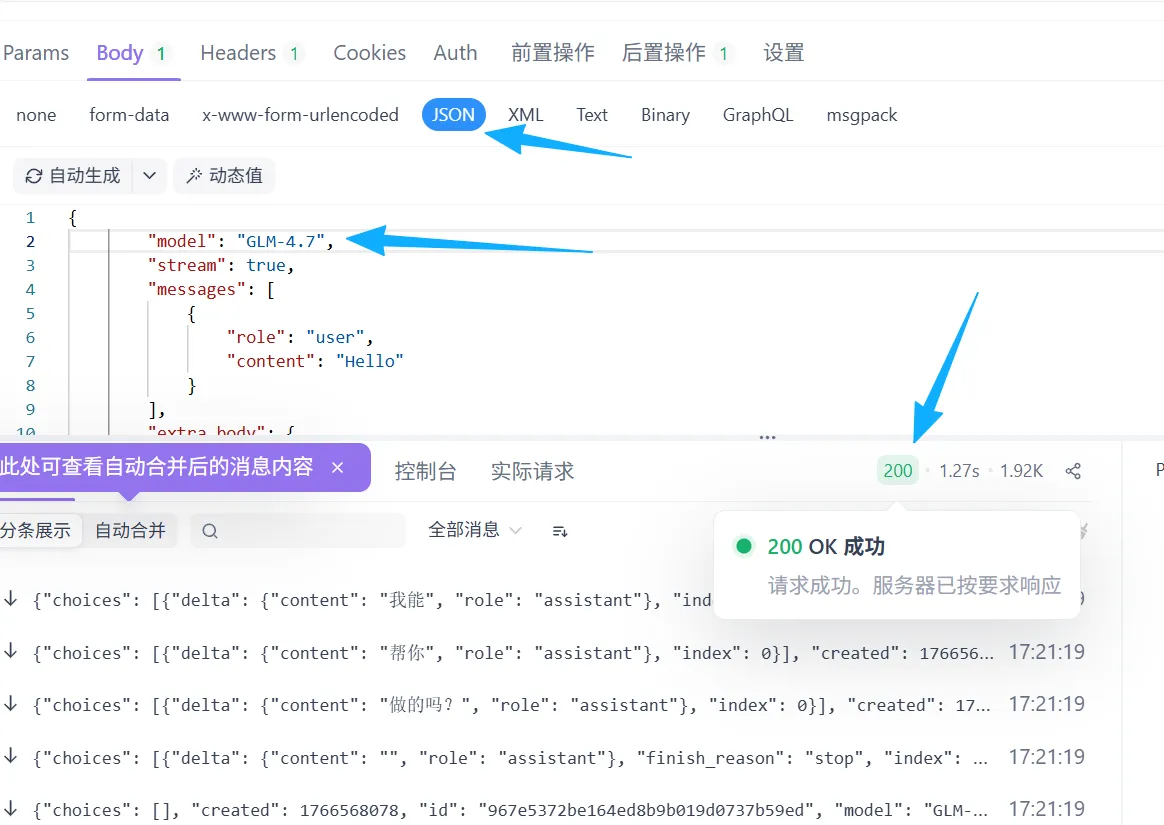

4.2 步骤2:使用Apifox进行调试

Apifox官网链接:https://app.apifox.com/main(注意这里需要下载)

选择post,进入文档查看链接

进入官方复制链接

4.3 步骤3:编写调用代码

- 选择Body-JSON

modle处填写自己调用的大模型:GLM-4.7

{

"model": "GLM-4.7",

"stream": true,

"messages": [

{

"role": "user",

"content": "Hello"

}

],

"extra_body": {

"enable_thinking": false

}

}

4.4 步骤4:实测反馈

生成代码结构清晰,配色协调,支持交互控制,仅需轻微微调即可部署,完全符合“生产级”使用标准。

六、细分场景实操实测

(一)编程开发场景

Python可视化任务中,GLM-4.7生成的红绿灯代码结构清晰、注释完整,仅需细微调试即可运行;多语言混合开发任务中,MiniMax M2.1表现更亮眼,Rust底层逻辑+TypeScript前端交互的跨语言项目,无需额外调试即可兼容运行,且响应速度比GLM-4.7快200ms。3D交互场景下,GLM-4.7可生成5000+粒子立体动画,M2.1则在React框架下实现7000+实例渲染,视觉细腻度更优。

(二)办公与智能体场景

复合办公指令测试中,GLM-4.7生成的季度报告数据可视化完整、排版美观;MiniMax M2.1提取会议纪要行动项更精准,回复内容简洁聚焦,节省阅读时间。智能体工具调用中,GLM-4.7上下文保留能力出色,重复检索率降低32%;M2.1工具切换效率更高,跨框架适配稳定性较前代提升28%。

七、总结与选型建议

GLM-4.7与MiniMax M2.1的上线,彰显了国产大模型在技术深耕与场景适配上的突破,两款模型形成鲜明差异化优势:GLM-4.7以开源普惠、高性价比与全能性,成为中小企业、开发者多场景使用的首选;MiniMax M2.1则凭借专业编程能力、低时延交互,更适配研发团队、办公场景的精准需求。

而AI Ping通过中立评测体系与标准化实测,精准锚定两款模型的性能边界与适配场景,真正发挥“性能罗盘”价值。未来,AI Ping将持续迭代评测维度,为大模型选型、优化提供更精准的导航,推动国产AI技术在垂直产业落地。