提高LLM决策的可解释性和可解释性

概述

大语言模型(LLM)作为一种强大的自然语言处理模型,在实际应用中往往需要具有一定的可解释性和可解释性,以便用户和开发者能够理解模型的决策过程和生成结果的原因。本文将讨论如何提高LLM决策的可解释性和可解释性,以满足实际应用的需求。

模型解释技术

模型解释技术是提高LLM可解释性的关键手段之一。这些技术旨在分析模型的内部结构和参数,揭示模型的决策过程和生成结果的原因。常见的模型解释技术包括:

特征重要性分析:通过分析模型中各个特征对结果的贡献程度,来评估特征的重要性,从而解释模型的决策过程。

局部解释方法:通过在特定输入样本附近构造局部模型,来解释模型在该样本上的决策过程,从而提高解释性的精度和可信度。

全局解释方法:通过分析整个数据集或模型的整体结构和行为,来揭示模型的全局性质和决策规律,从而提高解释性的全面性和一致性。

生成过程可解释性

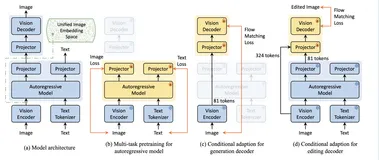

LLM在生成文本时,其生成过程本身也应该具有一定的可解释性。这意味着模型应该能够清晰地展示生成文本的来源和生成过程,以便用户和开发者能够理解文本的生成逻辑和语言结构。为了提高生成过程的可解释性,可以采取以下措施:

逐词解释:模型在生成每个词语时,应该能够清晰地展示该词语的生成过程和生成原因,例如基于哪些上下文信息和语言模式进行生成。

可视化生成过程:通过可视化技术,将模型的生成过程以图形化的方式展示出来,使用户能够直观地理解文本的生成逻辑和语言结构。

生成路径分析:分析生成文本的生成路径和关键节点,揭示模型在生成过程中的决策轨迹和关键因素,以提高生成过程的可解释性。

用户交互与反馈机制

为了进一步提高LLM的可解释性和可解释性,可以引入用户交互和反馈机制,让用户参与到模型的决策和生成过程中。通过与用户进行交互,可以更好地理解用户的需求和偏好,从而更好地调整模型的决策和生成结果。同时,用户的反馈也可以用于评估模型的性能和改进模型的质量,从而提高模型的可解释性和可解释性。

知识图谱与语义解释

知识图谱是一种用于表示和组织知识的图形化结构,可以帮助解释模型的决策过程和生成结果。通过将LLM生成的文本与知识图谱进行关联,可以为文本提供丰富的语义信息和背景知识,从而提高文本的可解释性和可解释性。同时,知识图谱还可以用于解释模型的内部结构和参数,揭示模型的决策规则和生成逻辑,从而提高模型的可解释性和可解释性。

总结

提高LLM决策的可解释性和可解释性是一个复杂而重要的问题,涉及到模型解释技术、生成过程可解释性、用户交互与反馈机制、知识图谱与语义解释等方面。通过综合利用这些技术和方法,可以有效地提高LLM的可解释性和可解释性,使其更加适用于实际应用场景,并为用户和开发者提供更好的用户体验和服务质量。