这个类我在flink-table-runtime里找不到呢?我这里pysql用一个java的udf就会调用这个类

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

遇到org.codehaus.janino.CompilerFactory类找不到的问题,通常是由于类路径冲突或缺失相应的依赖所致。这个问题可能是由于您的UDF JAR或连接器JAR中不慎包含了与Flink自带版本冲突的janino库版本。解决步骤如下:

检查JAR包依赖:

首先,确认您的UDF或相关依赖JAR是否包含了org.codehaus.janino相关的类。这可能是导致类冲突的根源。

调整类加载策略:

如果确实存在冲突,您可以通过调整Flink的类加载策略来规避问题。在Flink作业的配置中,添加以下参数以确保org.codehaus.janino相关的类由父类加载器加载,避免子类加载器中的冲突版本被优先加载:

classloader.parent-first-patterns.additional: org.codehaus.janino

这样配置后,Flink会优先使用其内置或指定版本的janino库,避免因类路径冲突导致的异常。

清理和重建依赖:

确保在构建您的UDF或相关项目时,正确管理依赖,避免不必要的或冲突的库被引入。如果使用Maven或Gradle,可以考虑排除掉不需要的janino依赖,或锁定一个与Flink兼容的版本。

通过以上步骤,您应该能够解决在使用Java UDF时因org.codehaus.janino.CompilerFactory类找不到而导致的问题。如果问题依旧,建议检查项目的构建配置和依赖管理,确保所有依赖干净且与Flink环境相匹配。

相关链接

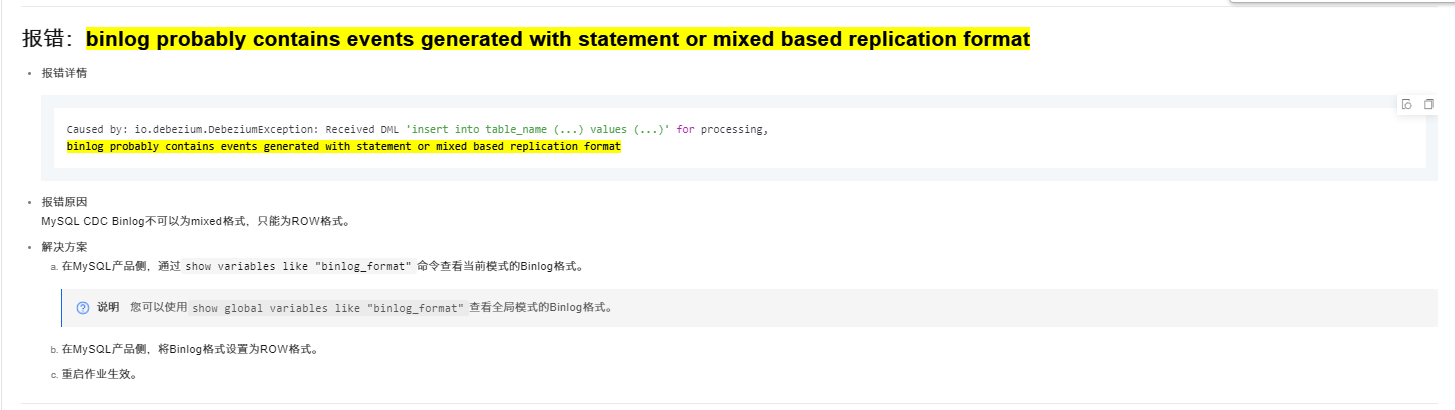

SQL常见问题 报错: https://help.aliyun.com/zh/flink/support/common-sql-errors

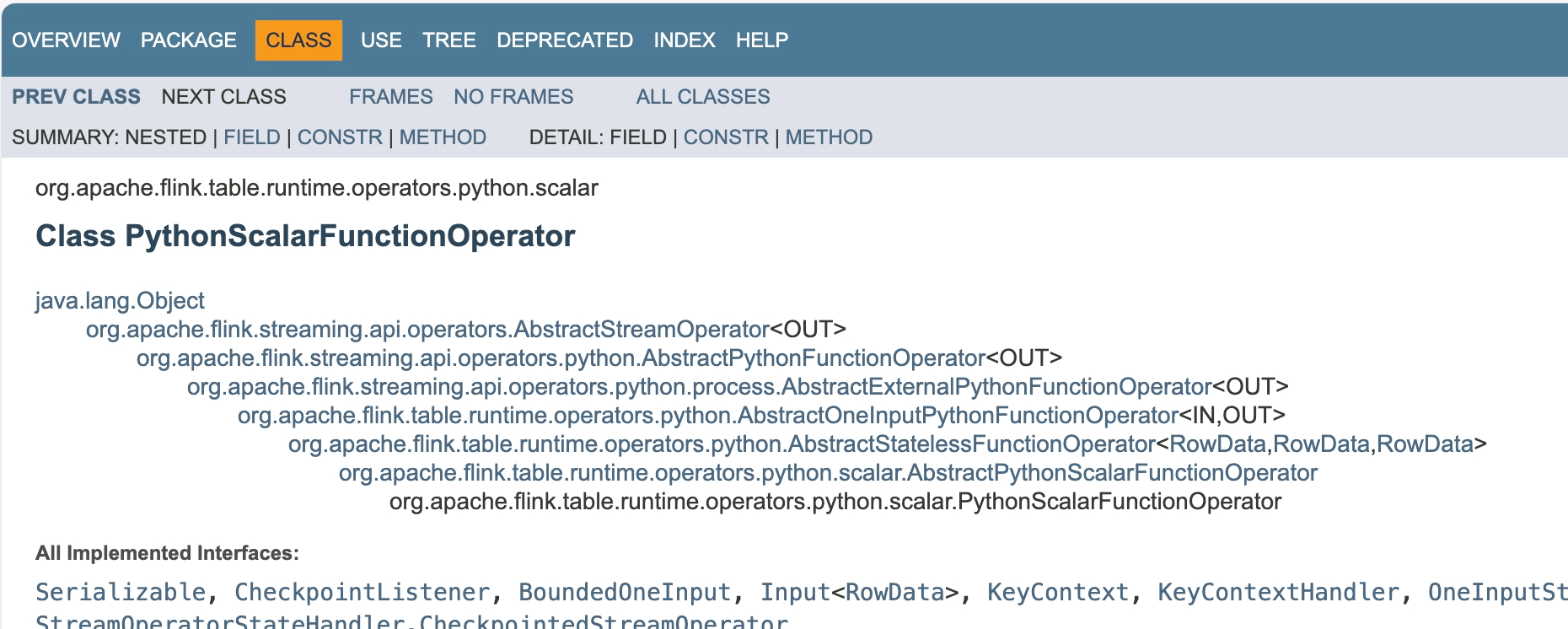

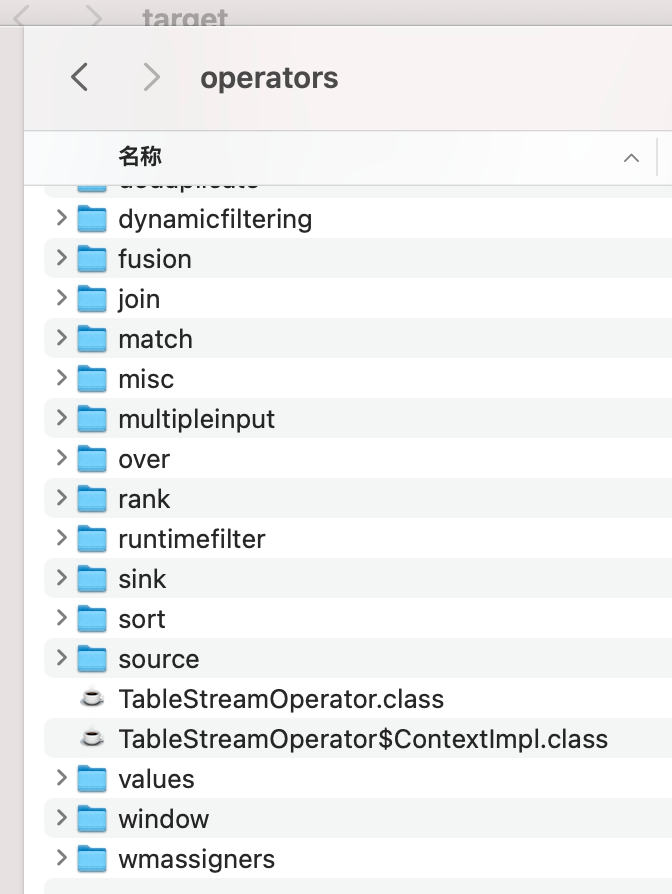

PythonScalarFunctionOperator是Apache Flink项目的一部分,用于执行使用Python编写的标量函数。它在Flink的Java或Scala API中使用,但可能不会直接显示在Python API文档中。当你在Flink表格API中使用Python UDF时,内部会使用此类来管理和执行用户定义的函数.

如果您的问题是在使用 Flink Table API 时遇到了找不到某个类的问题,我们可以一步步来解决这个问题。您提到的 pysql 和 Java UDF 的使用,让我猜测您可能是在寻找一个与 SQL 或 UDF 相关的类。

首先,我们需要确定您提到的类是什么,以及您在哪个场景下需要用到这个类。由于您没有明确指出是哪个类,我将提供一个通用的例子,说明如何在 Flink 中使用 Java UDF,并确保相关依赖已正确配置。

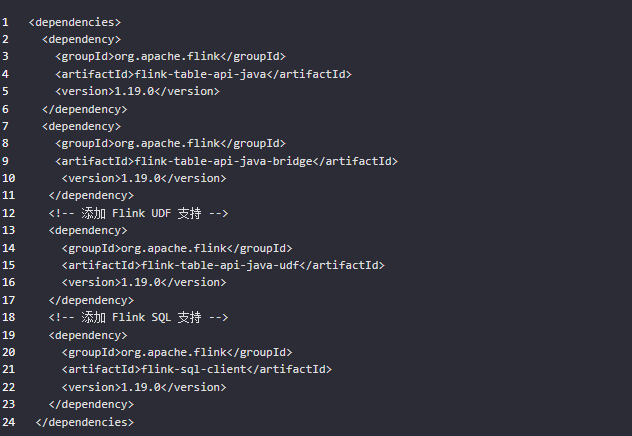

步骤 1: 确认依赖

确保您的项目中包含了 Flink Table API 和 UDF 支持的依赖。如果您使用的是 Maven,您的 pom.xml 文件应该包含以下依赖项:

看看你的 Flink 版本是否支持 Python UDFs 再看看项目依赖,最好看看 PythonScalarFunctionOperator 是否存在于其他模块中。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。