Flink CDC的增量同步,有没有要求一定要有HDFS?也就是一定要有这样一个分布式的文件系统,对吧?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

不是必须要有 HDFS 才能使用 Flink CDC 的增量同步功能。

Flink CDC 提供了两种增量同步方式:基于文件的增量同步和基于数据库的增量同步。

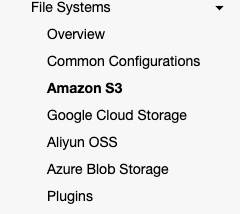

基于文件的增量同步将增量数据写入 HDFS 或其他分布式文件系统,以便于持久化和分布式存储。这种方式需要一个可用的分布式文件系统,例如 HDFS 或 S3。

基于数据库的增量同步将增量数据写入另一个数据库系统,例如 PostgreSQL 或 MySQL。这种方式不需要分布式文件系统,但是需要安装和配置数据库系统。

总的来说,选择哪种增量同步方式取决于您的应用场景和需求。如果您需要长期保留增量数据,并希望跨多个节点分布存储,那么基于文件的增量同步是一个好选择;如果只需要短期存储增量数据,并且不需要跨多个节点分布存储,那么基于数据库的增量同步可能是更好的选择。

这就取决于你flink集群的状态后端怎么配置,也可以是oss,s3之类的,也可以放在内存里,只要你内存吃的住,目前只支持这些

不过你可以魔改实现,此回答整理自钉群“Flink CDC 社区”

Flink CDC的增量同步并不强制要求一定要有HDFS分布式文件系统。它可以监控MySQL数据库的binlog,并将binlog中的增量数据实时同步到Flink的数据源中。Flink CDC支持全量和增量数据一体化同步,首先读取数据库中表的历史全量数据,再无缝衔接到读取表的增量数据,为用户提供实时的、一致性的快照。整个过程中,全量同步与增量读取无缝衔接,不需要用户进行手动干预或切换。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。