Flink CDC的 K8s operato这个文档哪里有?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

你可以在Flink CDC GitHub仓库中的kubernetes目录下找到Kubernetes operator实现的源码。Flink CDC的Kubernetes operator文档可以在https://ververica.github.io/flink-cdc-connectors/master/

这个网址找到。

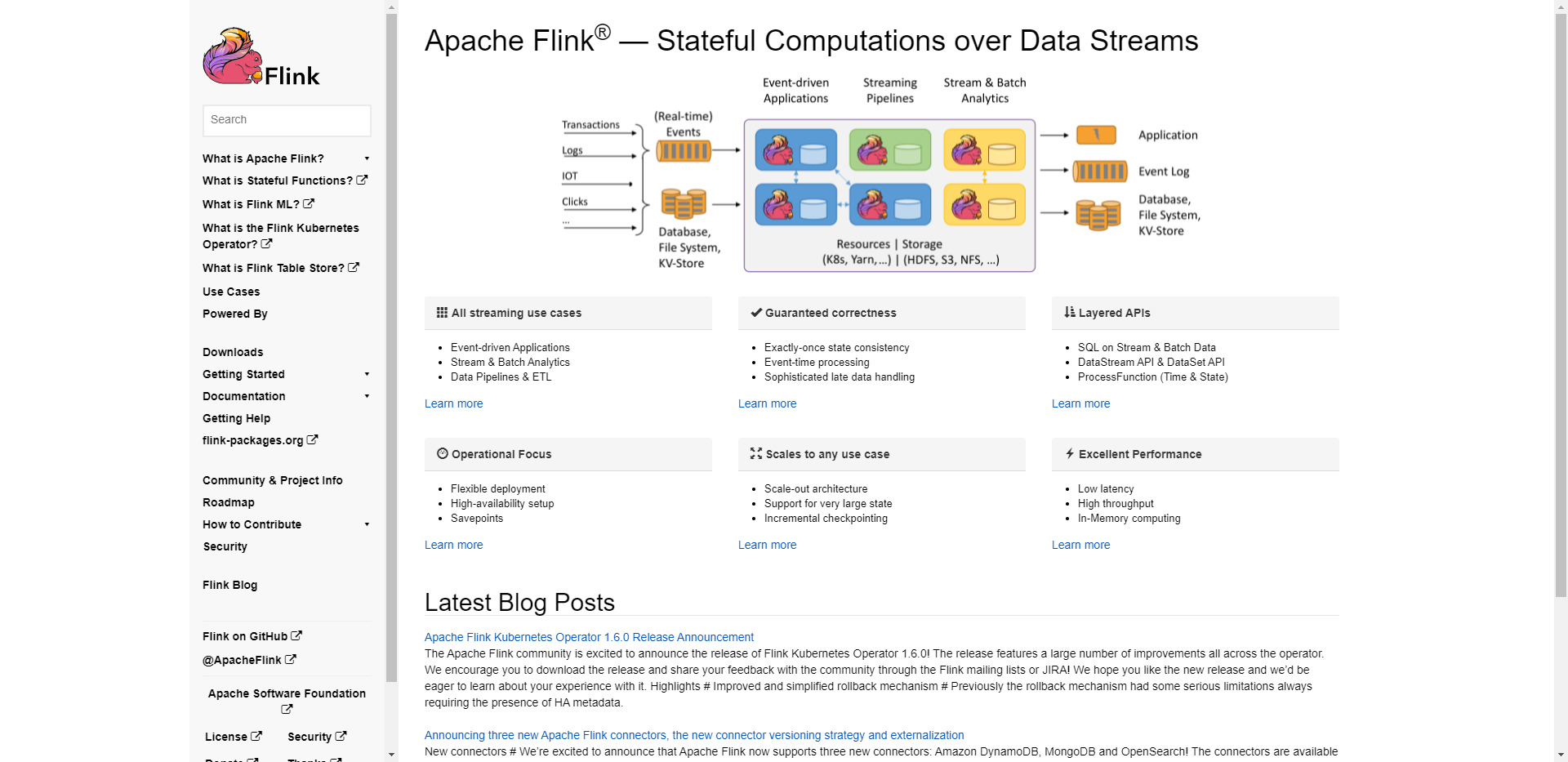

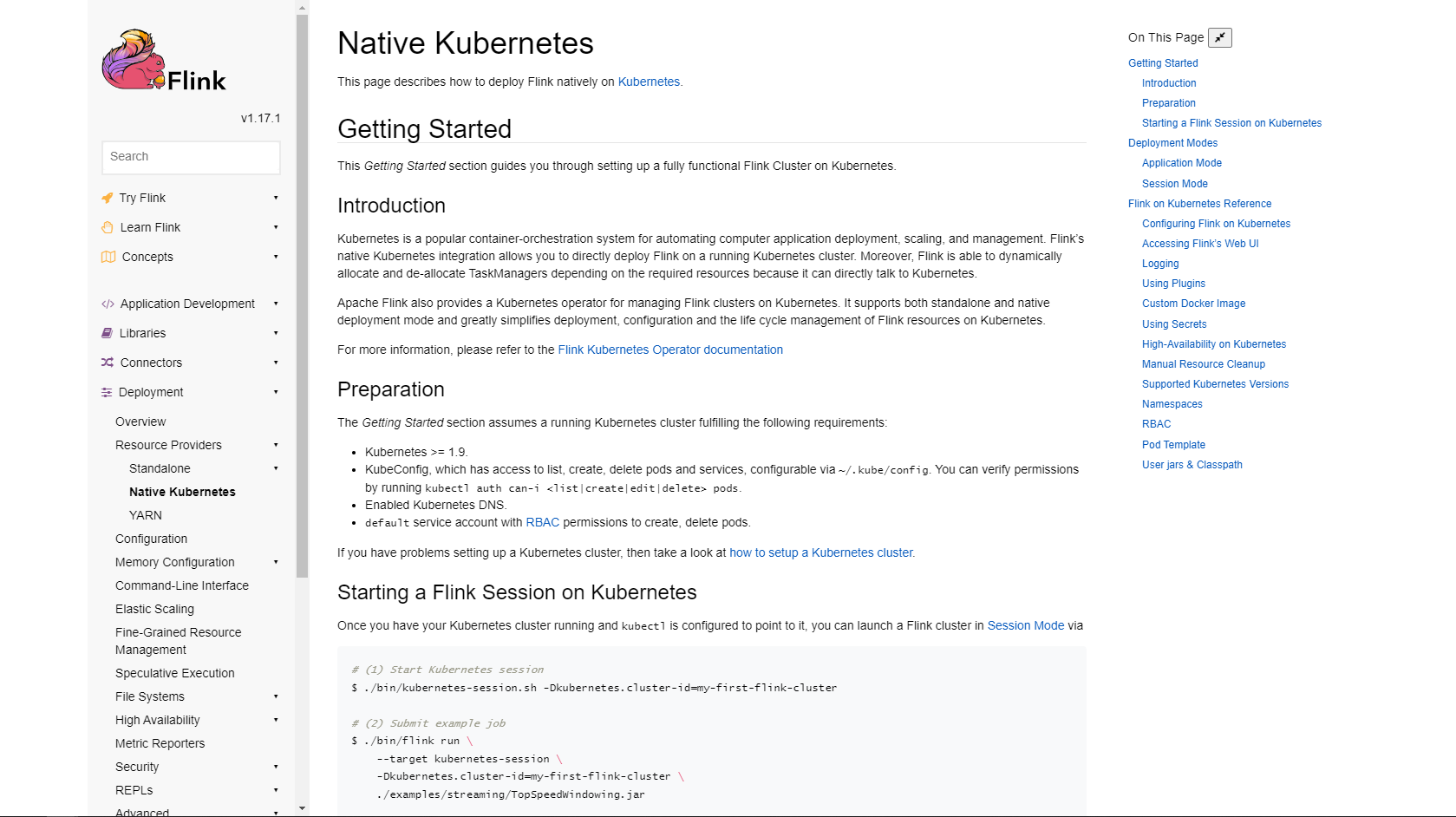

Flink CDC 的 K8s Operator 文档可以在 Flink 官方文档中找到。您可以访问 Apache Flink 的官方网站https://flink.apache.org/

,然后在文档部分搜索 "Flink CDC K8s Operator" 或者 "Flink CDC Kubernetes Operator"。这将带您到相关的文档页面,其中包含有关如何在 Kubernetes 上部署和管理 Flink CDC 的详细说明和示例。请注意,K8s Operator 文档可能会根据 Flink 版本的不同而有所变化,因此请确保查看与您使用的 Flink 版本相对应的文档。

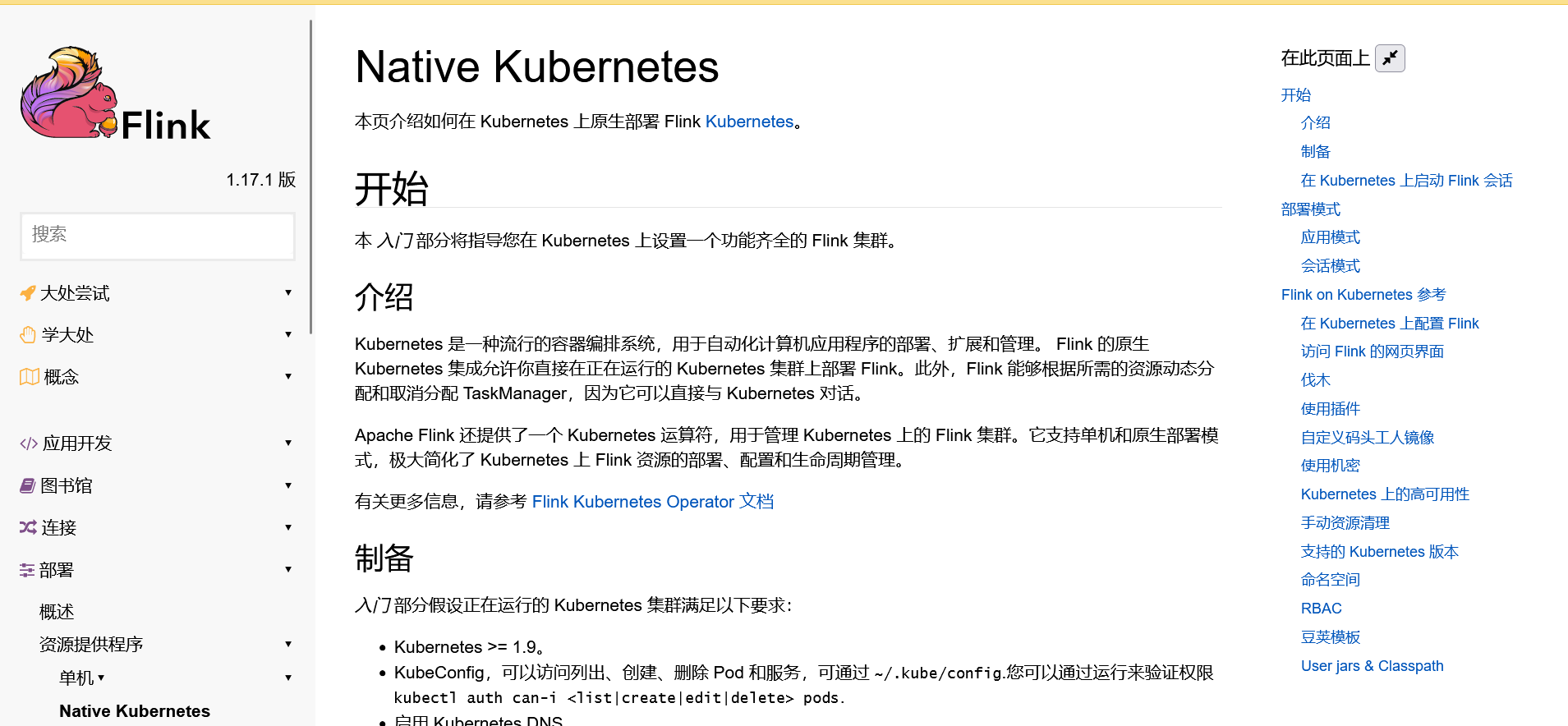

Flink CDC的Kubernetes operator文档可以在Apache Flink官方文档中找到。您可以访问以下链接获取相关文档:

https://nightlies.apache.org/flink/flink-docs-stable/docs/deployment/resource-providers/native_kubernetes/?spm=a2c6h.13066369.question.15.7cdc7ccecxMaSF#kubernetes-operator

也可以通过CSDN学习相关的知识:https://blog.csdn.net/qq_20042935/article/details/129005302!

Flink-kubernetes-operator 官方文档中给出的 application 模式 demo

apiVersion: flink.apache.org/v1beta1

kind: FlinkDeployment

metadata:

namespace: default

name: basic-example

spec:

image: flink:1.16

flinkVersion: v1_16

flinkConfiguration:

taskmanager.numberOfTaskSlots: "2"

serviceAccount: flink

jobManager:

resource:

memory: "2048m"

cpu: 1

taskManager:

resource:

memory: "2048m"

cpu: 1

job:

jarURI: local:///opt/flink/examples/streaming/StateMachineExample.jar

parallelism: 2

upgradeMode: stateless

state: running

Flink on-k8s operator 模式运行flink 使用dockerfile 方式进行构建

在编写dockerfile 之前使用 docker images 看下是否拉取了flink 基础镜像 如果没有执行

docker pull flink:1.15.3-scala_2.12-java8

第一步: 编写dockerfile

FROM flink:1.15.3-scala_2.12-java8

USER root

ENV FLINK_HOME=/opt/flink

ENV PATH=$FLINK_HOME/bin:$PATH

#flink添加到根目录

RUN mkdir $FLINK_HOME/userlib

ADD flink-cdc-demo-1.0-jar-with-dependencies.jar $FLINK_HOME/userlib

#设置code文件夹的工作目录

EXPOSE 6123 8081

第二步:构建镜像到远程镜像仓库 (your_docker_repository_url 为镜像仓库地址 flink 为该仓库中的目录,flink_application 表示镜像名称)

docker build -t your_docker_repository_url/flink/flink_application .

第三步: 上传构建好的镜像到远程仓库

docker push your_docker_repository_url/flink/flink_application

编写application job。通过image 标签来指定 自定义的flink 镜像

apiVersion: flink.apache.org/v1beta1

kind: FlinkDeployment

metadata:

name: flink-application-1

namespace: your_namespace

spec:

mode: native

image: www.abc.cn/flink/flink_application:1.15.3-scala_2.12-java8

flinkVersion: v1_15

flinkConfiguration:

taskmanager.numberOfTaskSlots: "6"

state.checkpoints.dir: file:///tmp/checkpoint

serviceAccount: flink

jobManager:

resource:

memory: "1024m"

cpu: 1

taskManager:

resource:

memory: "4096m"

cpu: 1

job:

jarURI: local:///opt/flink/userlib/flink-cdc-demo-1.0-jar-with-dependencies.jar

parallelism: 1

upgradeMode: stateless

最后运行application flink

kubectl apply -f your_FlinkDeployment.yaml

楼主你好,阿里云Flink CDC的K8s operator文档可以在阿里云官方文档中心中找到。

具体步骤如下:

打开阿里云官网:https://www.aliyun.com/

点击“产品”按钮,选择“计算”选项。

找到“流计算”选项,点击进入。

在“流计算”页面上方的菜单栏中,选择“文档”选项。

在文档页面上方,可以看到“Kubernetes Operator”选项,点击进入。

在“Kubernetes Operator”页面中,可以看到阿里云Flink CDC的K8s operator的文档,包括介绍、使用步骤、架构设计等内容。

注意,为了更好的查找文档,需要在页面上方的搜索框中输入关键词“阿里云Flink CDC”的K8s operato”,即可快速找到对应文档。

另外这是官方:

使用Flink K8s Operator 部署 Flink 应用程序到 Kubernetes 的步骤如下:

1.准备 Kubernetes 群集:可以使用 minikube 或者 kubeadm 等工具在本地搭建一个 Kubernetes 群集以用于本地开发和测试.

2.安装 Flink K8s Operator:可以通过 Helm Charts 或者 YAML 文件安装 Flink K8s Operator。如果使用 Helm Charts,可以使用以下命令:

# 添加 flink-charts 仓库

helm repo add flink https://flink-charts.s3.amazonaws.com/

# 在 Kubernetes 中安装 Flink K8s Operator

helm install flink flink/flink-operator

3.创建 Flink 应用程序:可以使用 Flink 的 Java API 或者使用流处理脚本编写 Flink 应用程序,然后将其编译成 Jar 包。

4.配置 Flink 应用程序资源:需要在 Flink 应用程序的 Jar 包中制定应用程序资源(例如 JobManager,TaskManager等)的数量和大小,也可以通过 flink-configuration.yaml 文件修改 Flink 的配置。

5.定义 Flink 应用程序:使用 YAML 文件定义 Flink 应用程序,其中包括应用程序名称、资源需求、deployment、service 和 env 等信息。例如:

apiVersion: flink.k8s.io/v1alpha1

kind: FlinkApplication

metadata:

# 应用程序名称

name: wordcount

spec:

# 应用程序 JAR 包名称及位置

jarName: wordcount.jar

jarPath: /opt/flink/examples/wordcount.jar

savepointPath: gs://my-bucket/savepoint

# 应用程序运行所需的资源

taskManagerSlots: 8

parallelism: 16

# 部署相关配置

deployment:

# deployment 名称和标签

name: wordcount

labels:

app: wordcount

# 环境变量配置

env:

- name: ENVIRONMENT_VARIABLE_KEY

value: ENVIRONMENT_VARIABLE_VALUE

# service 相关配置

service:

name: "{{ .Release.Name }}-ui"

6.提交 Flink 应用程序:使用 kubectl 命令提交 Flink 应用程序,并检查应用程序日志查看是否成功。

kubectl apply -f wordcount.yaml

kubectl logs -f wordcount-jobmanager-0

Flink 提供了 Kubernetes Operator 来简化 Flink on Kubernetes 的部署和管理。

Flink 的官方文档中有专门的章节介绍 Flink Kubernetes Operator:

https://nightlies.apache.org/flink/flink-docs-stable/docs/deployment/resource-providers/native_kubernetes/#kubernetes-operator

主要包含以下内容:

这个仓库中包含 Operator 的 Chart 模板和示例。

如果你使用的是 Flink CDC,可以参考下面的文档来使用 Operator 部署 Flink CDC 应用:

https://nightlies.apache.org/flink/flink-docs-stable/docs/deployment/resource-providers/native_kubernetes/#deploy-a-flink-cdc-cluster-with-the-kubernetes-operator

主要是在 customResource 模板中指定 Flink CDC 相关的配置

用于实时捕获数据源的变化,并将这些变化转换为可操作的数据流。Kubernetes 是一个流行的容器编排系统,可以用于部署和管理 Flink CDC 应用程序。

在 Kubernetes 中部署 Flink 基础架构,包括 Flink 集群和 StatefulSet。

配置 Flink CDC,以便它可以连接到数据源并将变化转换为可操作的数据流。

Flink CDC的K8s Operator相关文档主要有以下几个地方:

Flink CDC GitHub仓库:

https://github.com/ververica/flink-cdc-connectors

这个仓库下有一个kubernetes目录,包含了K8s Operator实现的源码。

Flink CDC文档:

https://nightlies.ververica.com/cdc/user-defined-function/deployment-kubernetes-operator.html

文档中对K8s Operator的使用方式有一定解释。

Ververica官网:

https://www.ververica.com/products/streaming/flink-cdc

Ververica官网的产品页面中也有简单介绍K8s部署Operator的方式。

Flink操作手册:

https://ci.apache.org/projects/flink/flink-docs-release-1.14/ops/deployment/kubernetes.html

Flink正式版本手册中也包含了使用Operator进行K8s集群部署的相关内容,可参考。

Ververica的相关博客:

https://ververica.com/blog

Ververica在博客中不时也会有关于K8s CDC Operator使用和新特性的介绍。

如果您想要了解Flink CDC在Kubernetes上的操作,可以参考以下文档:

Apache Flink官方文档中的Kubernetes部分:https://ci.apache.org/projects/flink/flink-docs-release-1.12/zh/dev/connectors/jdbc.html#kubernetes

Apache Flink官方文档中的Kubernetes部分:https://ci.apache.org/projects/flink/flink-docs-release-1.12/zh/dev/connectors/jdbc.html#kubernetes-operators

Apache Flink官方文档中的Kubernetes部分:https://ci.apache.org/projects/flink/flink-docs-release-1.12/zh/dev/connectors/jdbc.html#kubernetes-operators

需要注意的是,如果您在生产环境中使用Flink CDC,那么您需要考虑Flink CDC的资源使用情况。例如,您需要确保Flink CDC有足够的内存和CPU资源,以保证数据处理和同步的效率和稳定性。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

Flink CDC 的 K8s operator 文档可以在 Apache Flink 官方网站找到。具体可以访问 Apache Flink 官方网站([https://flink.apache.org/)的文档页面,然后搜索 "Kubernetes operator" 或者 "K8s operator"。在搜索结果中,您可以找到关于 Flink CDC 的 K8s operator 的相关文档。]https://nightlies.apache.org/flink/flink-kubernetes-operator-docs-stable/

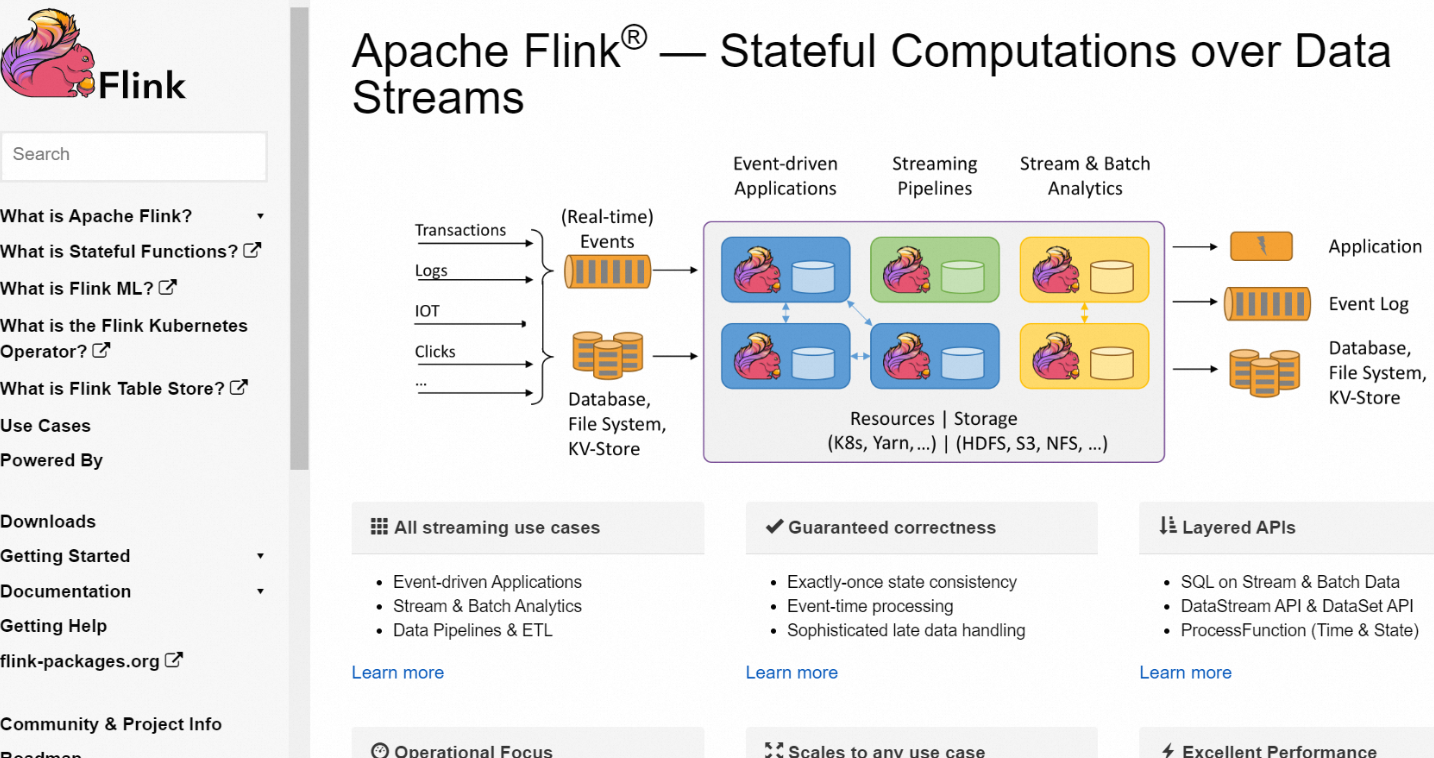

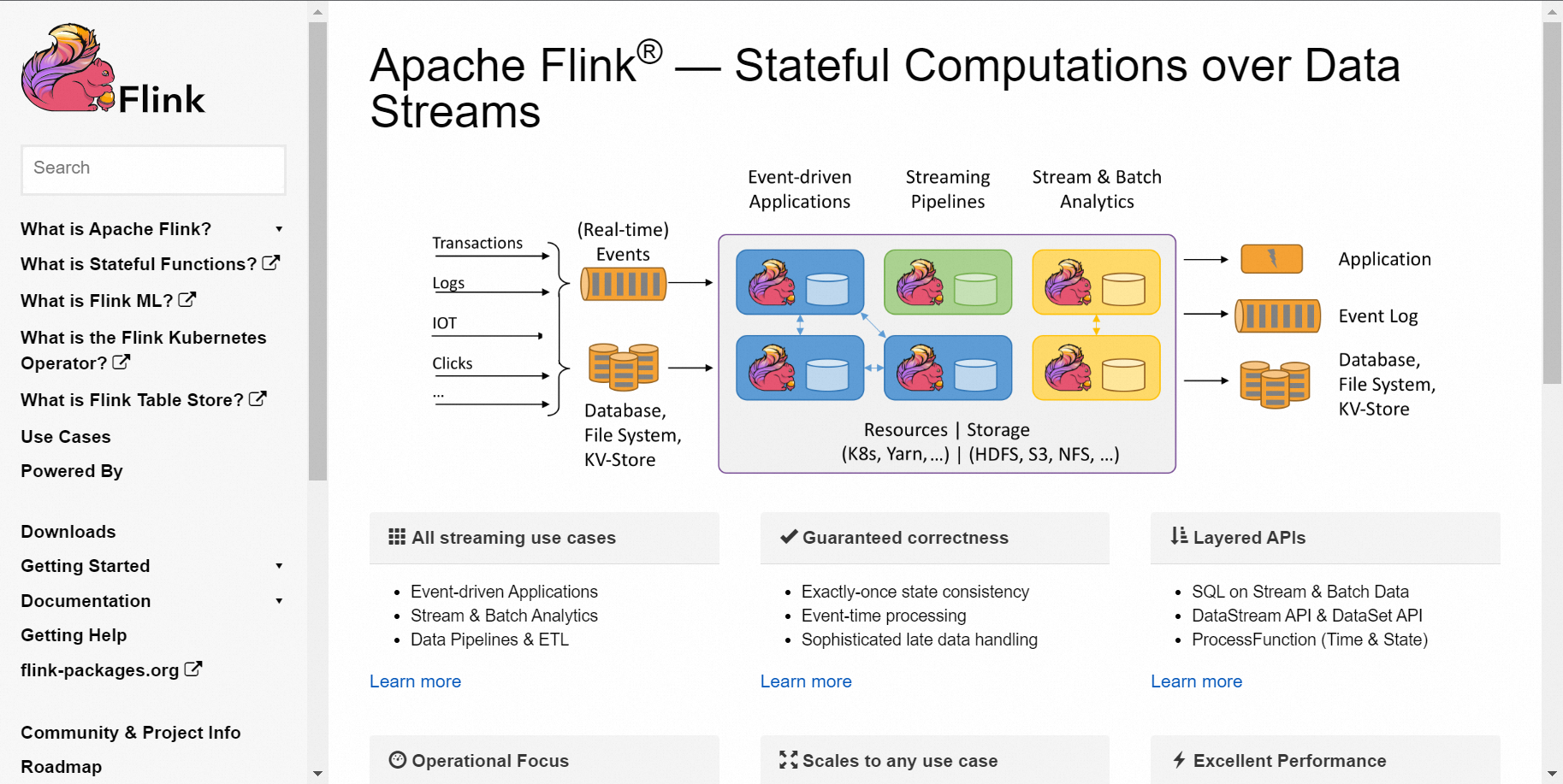

Flink CDC (Change Data Capture) 是 Flink 的一个功能,用于实时捕获数据源的变化,并将这些变化转换为可操作的数据流。Kubernetes 是一个流行的容器编排系统,可以用于部署和管理 Flink CDC 应用程序。

要在 Kubernetes 上部署 Flink CDC 应用程序,您需要执行以下步骤:

在 Kubernetes 中部署 Flink 基础架构,包括 Flink 集群和 StatefulSet。

配置 Flink CDC,以便它可以连接到数据源并将变化转换为可操作的数据流。

将 Flink CDC 应用程序部署到 Kubernetes 中,以便它可以在 Kubernetes 集群中运行。

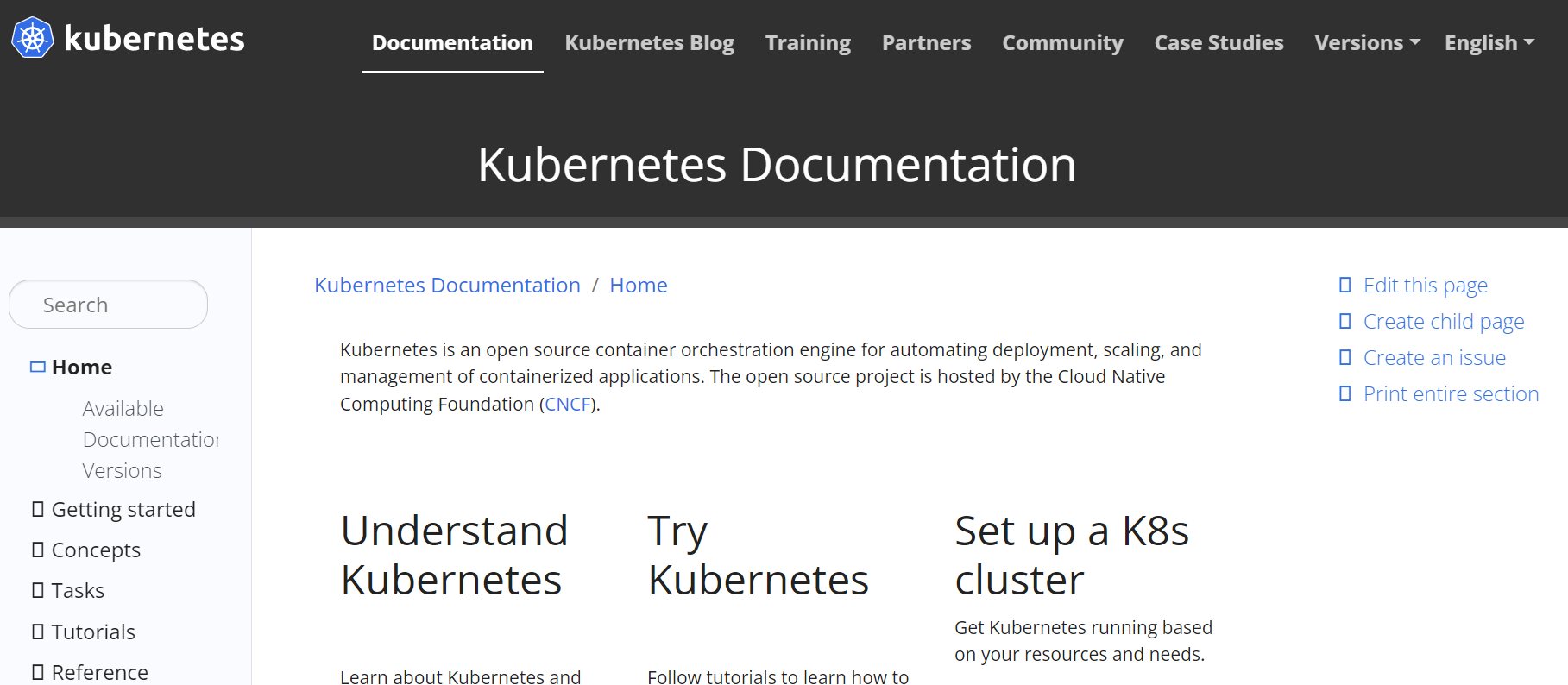

关于 Flink CDC 和 Kubernetes 的更多信息,请参阅以下文档:

Flink 官方文档中关于 CDC 的部分:https://ci.apache.org/projects/flink/flink-docs-release-1.12/zh/dev/connectors/cdc.html

Kubernetes 官方文档:https://kubernetes.io/docs/home/

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。