Flink 这个错有大佬见过么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的错误信息,虽然具体的错误内容未明确,但结合知识库中的常见问题和解决方案,以下是可能的原因及解决方法:

如果错误提示类似于 role "RAMxxxx" does not exist 或其他权限相关的报错,可能是子账号未被正确授权。

AliyunBlinkFullAccess或自定义策略)。如果错误与OSS文件写入相关,例如 The object you specified is immutable,可能是由于OSS设置了保留策略。

如果错误与MySQL相关,例如 Lock wait timeout exceeded,可能是事务回滚时申请锁失败。

jobmanager.log中检索导致Failover的表。taskmanager.log日志,搜索ERROR定位具体原因。如果错误提示类似于 The specified partition does not exist,可能是ODPS表分区未创建。

如果错误与ClickHouse相关,例如 not enough space,可能是磁盘空间不足。

如果错误与Kafka相关,例如 timeout expired while fetching topic metadata,可能是网络配置问题。

如果错误与任务运行异常相关,可以通过以下方法快速定位问题:

如果错误与Checkpoint相关,可能是Checkpoint失败导致的任务异常。

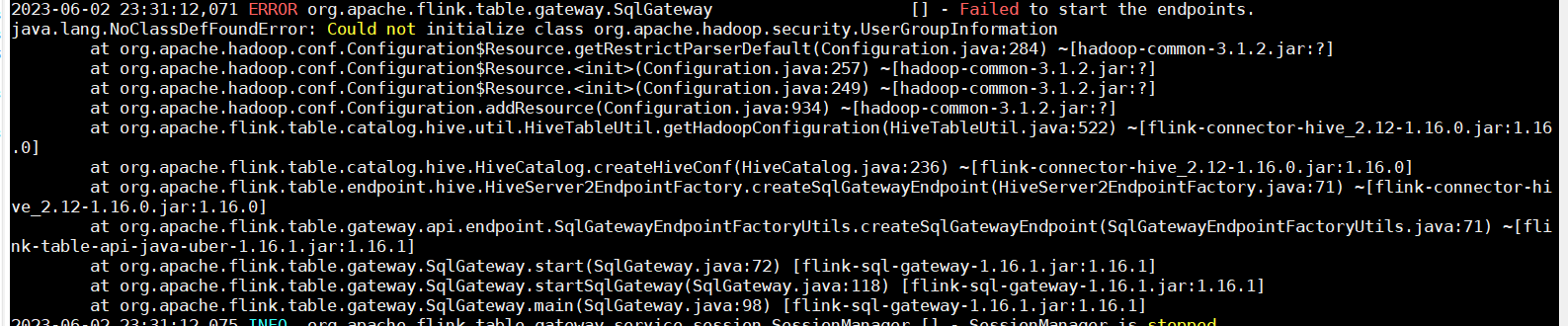

如果错误与依赖冲突相关,例如 java.lang.NoClassDefFoundError 或 java.lang.NoSuchMethodError,可能是JAR包依赖冲突。

pom.xml文件,移除不必要的依赖。jar tf foo.jar命令查看JAR包内容。mvn dependency:tree命令分析依赖冲突。provided,避免打入JAR包。Has not enough ip address,需新建可用IP。Unknown column XXX,确保DDL字段名称与物理表一致(MaxCompute会自动将字段转为小写)。table.exec.source.idle-timeout参数。如果您能提供更具体的错误信息,我可以进一步为您分析和解决问题。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。