威锋网 4 月 5 日消息,在苹果公司举行的小型记者招待会上,苹果公司软件工程高级副总裁克雷格·费德里希回答了一个关于外部 Thunderbolt GPU 的问题,不过他的回答很简单,只有一句话,“我想它们会有属于自己的位置。”

费德里希这个回答显然是经过一番斟酌的,虽然明确说出苹果正在开发这个概念,但是能让我们对苹果在这方面的行动稍有了解。

苹果与 eGPU 的兼容限制

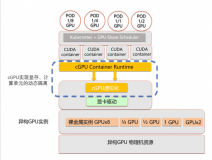

在开发 Thunderbolt 3 协议的过程中,外部 PCI-E 接线盒增加了与 GPU 无缝连接的功能。通常笔记本电脑中的 GPU 性能不强,有了外部 GPU,用户就不用再受此限制了。用户可以利用桌面 PCI-E卡,那么不管是能耗还是散热方面都会有更多好处。

目前 macOS 10.12 Sierra 的每一次更新都会从两个方面来打破兼容性,消除此前所有更新,要求有新的 GPU 驱动器。要安装新的可用的驱动器也很简单,关闭 System Integrity Protection,进行第三方脚本执行即可安装兼容的驱动器。

承认 eGPU 概念是重要的第一步

苹果可以采取更多措施限制外部 GPU 建设,只要他们想这么做。不过苹果并没有选择这么做。外部 GPU 建设仍在继续,厂商继续推出新的设计,还有一些厂商在开发“即插即玩”解决方案上取得了重大进步。

eGPU 成为一款大众工具的唯一办法就是苹果明确支持这项技术,而不是完全禁止它。在这次的小型媒体会上,苹果并没有对 Mac 产品线的更新以及未来发展遮遮掩掩,但是对 eGPU 技术却说的很少,这意味着或许苹果在进行这方面的研发。如果苹果能够能明确支持这项技术,对于用户来说这当然是好事,但是如果能在这个领域开发出什么产品来,那就更好了。

本文转自d1net(转载)