在大数据时代,企业对数据的管理和分析需求日益增长,传统的数据存储和处理方式已难以满足多元化、高时效性的数据分析要求。为此,数据仓库和数据湖作为两种重要的数据管理架构应运而生,它们在大数据生态系统中扮演着不同但互补的角色。本文旨在深入探讨数据仓库与数据湖的核心概念、技术特点、应用场景,并通过示例代码展示其实际应用,以期为企业构建高效数据架构提供参考。

一、数据仓库:结构化的数据管理与分析

1.1 定义与特征

数据仓库是一种面向主题的、集成的、非易失的、随时间变化的数据集合,主要用于支持管理决策。它通过ETL(Extract, Transform, Load)过程从不同源系统中提取数据,经过清洗、转换后加载到仓库中,形成统一的视图,便于用户进行复杂的查询和分析。

1.2 技术架构

数据仓库通常基于星型或雪花型模型设计,包括事实表和维度表,支持OLAP(在线分析处理)操作。常见的数据仓库解决方案有Teradata、Oracle Exadata、Amazon Redshift等。

1.3 应用场景

- 历史数据分析:如销售趋势分析、财务报表生成。

- BI报表:为企业提供定期的业务指标报告。

- 预测性分析:基于历史数据预测未来趋势。

1.4 示例代码:使用SQL在数据仓库中查询

SELECT d.Year, s.Region, SUM(f.SalesAmount) AS TotalSales

FROM FactSales f

JOIN DimDate d ON f.DateKey = d.DateKey

JOIN DimStore s ON f.StoreKey = s.StoreKey

WHERE d.Year = 2020

GROUP BY d.Year, s.Region

ORDER BY TotalSales DESC;

二、数据湖:原始数据的集中存储

2.1 定义与特征

数据湖是一个集中存储企业所有原始数据的系统,包括结构化、半结构化和非结构化数据。它不预先定义数据模式,支持数据的原始存储,便于数据科学家和分析师进行灵活的探索和分析。

2.2 技术架构

数据湖通常基于Hadoop HDFS、Amazon S3等分布式存储系统构建,利用Apache Spark、Presto等工具进行数据处理和查询。数据湖还常结合元数据管理工具(如Apache Atlas)来提升数据的可发现性和治理能力。

2.3 应用场景

- 大数据分析:处理PB级数据,如日志分析、用户行为分析。

- 数据科学实验:模型训练、特征工程、A/B测试。

- 数据探索:对未知数据模式的发现和验证。

2.4 示例代码:使用Spark在数据湖中处理数据

from pyspark.sql import SparkSession

spark = SparkSession.builder \

.appName("DataLakeExample") \

.config("spark.some.config.option", "some-value") \

.getOrCreate()

# 读取数据湖中的JSON文件

df = spark.read.json("s3a://your-data-lake/path/to/data/*.json")

# 数据处理示例:筛选和聚合

filteredDF = df.filter(df["event_type"] == "click") \

.groupBy("user_id") \

.agg({

"timestamp": "max"})

# 结果输出到新的目录

filteredDF.write.parquet("s3a://your-data-lake/processed_data/click_events")

三、数据仓库与数据湖的融合:湖仓一体

随着技术的发展,数据仓库与数据湖不再是互斥的概念,而是趋向于融合,形成“湖仓一体”的架构。这种架构旨在结合两者的优势,即数据湖的灵活性与数据仓库的高效查询能力,实现数据的全生命周期管理。

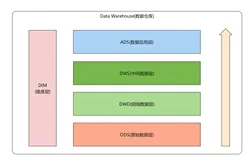

3.1 湖仓一体架构

- 数据湖作为原始数据存储:存放未经处理的原始数据,便于数据探索和实验。

- 数据仓库作为加工与分析层:基于数据湖加工数据,提供高性能的查询服务,支持BI和决策分析。

3.2 实现技术

- Delta Lake:结合事务日志,为数据湖提供ACID事务支持,使得数据湖可以支持更复杂的数据处理和版本控制。

- Hudi:类似Delta Lake,提供数据湖的事务和数据管理能力,适合大规模数据处理场景。

3.3 应用案例

企业可以先在数据湖中存储所有原始数据,通过数据管道定期或实时地将处理过的数据导入数据仓库,供决策支持系统使用。同时,数据科学家可以在数据湖中直接访问原始数据,进行深度分析和模型训练,实现数据的快速迭代和创新。

四、总结

数据仓库和数据湖在现代大数据架构中各司其职,数据仓库侧重于结构化数据的高效分析,而数据湖则提供了一个灵活的、面向未来的数据存储平台。随着湖仓一体架构的兴起,企业能够更好地整合这两种技术,实现数据的全面管理和深度洞察,加速数字化转型进程。企业在选择和实施数据架构时,应根据自身业务需求、数据规模和技术能力,灵活设计和调整,最大化数据的价值。