开发者学堂课程【新电商大数据平台2020最新课程:电商项目之 Flume 安装配置参数讲解】学习笔记,与课程紧密联系,让用户快速学习知识。

课程地址:https://developer.aliyun.com/learning/course/640/detail/10512

电商项目之 Flume 安装配置参数讲解

安装配置参数讲解

上节讲述了 Azkaban 的案例,并进行演示,调动过程从编写脚本到最后的脚本实现,到程序的运行,整体的过程已经实现完了。并且说明了如何编写任务,因为 Azkaban 本身是一个工作器,它里面一定包含一些定时任务。会根据它的 webUI 来完成定时任务就可以时间时自己选择。

电商的数据采集,现在有三行数据,业务数据通过 school 已经搞定,完全的导入到文件中形成 odsr,现在对 web 数据进行一个广告数据导入。

导入过程:

在文件中有一个1.cs 文件,这个文件是一个要进行采集的文件。

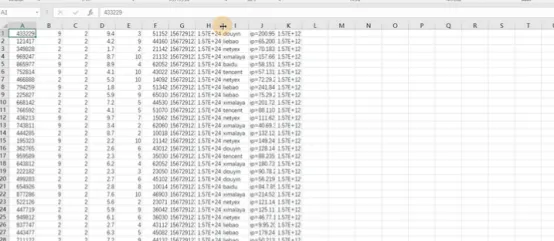

文件重要采集的数据如下图,存的是一些投放数据,这些数据需要逐一导入进去

导入:

是要使用 Flume采集,采集到 ods 就可以,这是 excel 表格的形式,这样子把规格的数字上传到服务器上。连接服务器,先进行上传,但是需要把 Flume 安装一下

这块安装的是 Flume1.8版本,如下图

直接输入语句,

tar -zxcf apache-flow1.8.0-bin.tar.gz -C /usr/local/ 进行解压,之前已经解压过,现在直接进入文件夹。可以看到有一个 flume1.8

用语句 mv 将名字进行更改,之后用 cd 进入大盘 flume1.8。现在的采集过程需要用到 flume 的 sink、source 等,在这里默认大家会使用 flume。

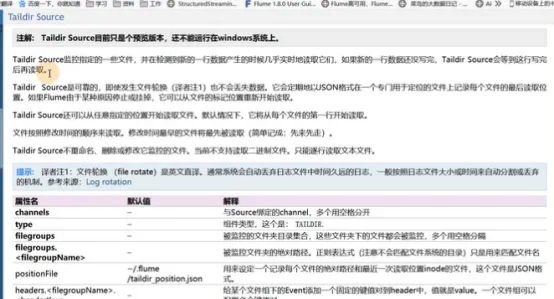

如果不会,在 flume1.8中文手册上,有对应的 flume sink、flume source、flume channel,source 选择是 Taildir source。

因为可以是监控指定的一些文件,而不是所有的文件,这个可以监控一个文件夹的目录中所有的文件,当然这个所有文件要设置采集的文件格式。

这个 Taildir source 有配置的一些参数,最大的特点就是实现一个断点续存,原因是这个内容可以存一些原数据,会以任意阶段的形式存在文件的一个位置,然后把原数据的文件保存就可以,当机器宕机或挂掉后会在原来的机器继续读取来实现断点续存。重新启动后会从原先的位置进行读取。

Channel 就是和 source 进行绑定的,type 是使用的类型是 Taildir,还有 filegroup 这个可以设置组,第四个是监控的一个路径,还有原数据,保存最近一次的文件。

配置采集的文件:

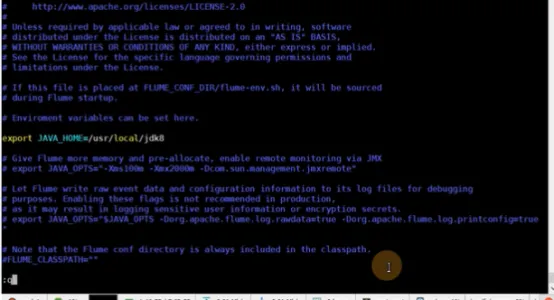

先进入 cd conf/文件但不操作,第一次检查的话会是一个.sh 文件,是一个内部的文件,需要进行一个修改。

在语句中输入 vim flume-env.sh,在里面配置一个jdk即可

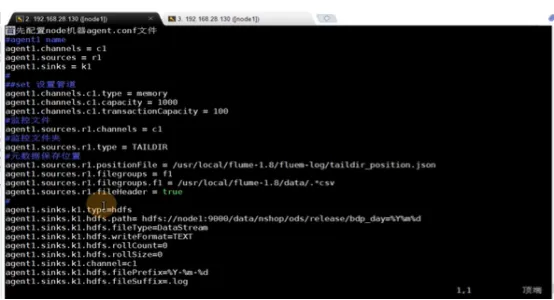

配置完后保存,创建一个新的 agent.conf,用语句 vim agent.conf 如下图。

创建一个新的是没有任何东西的,在这里是已经配置好的,是通过文档进行的配置,这个文档可以参考,包括一些高可用文件,以及 source。

打开10项目开发的内容,有对应的配置文件,但这个文件是 h1的配置文件,但要进行修改因为使用的是单机版。

所以需要一个个进行修改,首先先配置服务器的 source、channel、sink 的别名;

第二是配置 source 的配置原以及 channel 管道,这里选择的是内存 channel,还有大小;

第三是监控的文件,这并不是监控的文件而是一个对机,比如 sink 和 channel 对接的一个整合,相当于告诉channel 接受的是哪一个 sink 的数据,监控文件夹使用的类型是 Taildir;

第五是元数据保存位置,就是所要采集的文件夹、数据的文件位置,比如说第一个是元数据的保存位置,这个文件不需要创,只用给出位置以及相应的数据就行,再写上对应的名字,第二个上是组织的f1,如果有多个文件夹可以配置成 f2f3f4。

第三个是配置文件夹得路径,采集得是 flume1.8下所有csv文件,之后就是配置 sink,使用得是 sh.sink,直接将数据存储到 azkaban 上,设置类型是 hdfs,之后是hdfs保存的路径买这个路径要保持一样,到最后还要采集到后面得表中,直接放入当前得文件加就行,直接映射即可。

接下来采集得文件类型是 dataStream 流得形式,使用 text 得形式书写。

之后得两行设置0,是因为输出,flume 采集得时候会使用大量的写文件,需要把写文件合并成一个,就要设置为0,就会形成一个文件。之后配置 sink 和 channel 的对接文件,要告诉 sink 是哪一个 channle 对接,最后配置前缀和后缀,log 文件,前缀使用 true 的形式保存的,这就是单机版的配置。

到这整体来说搭建成功,它本身就是一个搭建工具,所以不太麻烦,最后测试一下采集,直接使用就行,如果有问题就解决就行。