flinkcdc在监听binlog时如果程序停掉,中途又新增,如何让程序在停掉的点重新监听?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

为确保Flink CDC在程序因故停掉后能从之前的Binlog位置继续读取,您需要采取以下几个关键措施:

记录并保存Binlog位置: 在Flink作业配置中,确保为MySQL CDC Source指定了唯一的serverId,这将帮助MySQL识别并跟踪此Flink作业的读取位置。当作业停止时,MySQL的Binlog不会删除该作业已读取但尚未提交的事务对应的日志条目。

故障恢复与断点续传: 利用Flink的Checkpoint机制。通过配置合适的Checkpoint间隔(如execution.checkpointing.interval),Flink会在运行过程中定期创建Checkpoint,记录作业的运行状态及Source读取的Binlog位置。当作业意外终止后重启,Flink会自动从最近完成的Checkpoint处恢复执行,从而继续从之前的Binlog位置读取。

配置MySQL Binlog保留策略: 确保MySQL服务器的Binlog不会在Flink作业因维护或其他原因短暂中断期间被自动删除。根据您的业务连续性和数据保留需求,适当调整MySQL的Binlog保留策略,例如通过expire_logs_days参数设置日志过期天数,确保在Checkpoint恢复所需的时间范围内,相关Binlog不会被清理。

通过上述方法,即使Flink CDC程序中途停掉并重新启动,也能够基于之前记录的Binlog位置继续监听和处理增量数据,实现断点续传的功能。

在Flink CDC监听Binlog过程中,如果程序意外停掉,且期间数据库有新增数据,要使程序从停掉的点继续监听,您需要采取以下步骤:

选择合适的启动策略:Flink作业重启时,通过配置启动模式来控制从哪里开始读取数据。对于您的需求,应选择使用specific-offset模式,这样可以从程序停掉前的特定Binlog位点恢复消费。<

配置具体位点信息:在Flink SQL配置中,设置scan.startup.mode = 'specific-offset',并且提供正确的scan.startup.specific-offset.file(Binlog文件名)和scan.startup.specific-offset.pos(Binlog内部的偏移量),或者使用GTID集通过scan.startup.specific-offset.gtid-set来指定启动位置。

确保Binlog未被清理:为了能够成功从之前的位点恢复,必须确保数据库服务器上的相关Binlog没有因为过期而被自动清理。因此,检查并适当调整MySQL的Binlog保留策略,如时间、大小或文件数量限制,以覆盖程序可能的停机时间范围。

监控与测试:在应用此配置前,建议在测试环境中先行验证,确保配置正确无误且能按预期恢复数据消费。同时,部署时考虑监控Binlog位点和Flink作业状态,以便及时发现并处理任何潜在问题。

通过设置特定的启动位点和合理管理Binlog,即可实现Flink CDC在程序停掉后从之前的点继续监听Binlog的目标。

Flink CDC Connectors支持Flink的检查点(Checkpoint)机制。通过定期创建检查点,Flink可以保存当前的偏移量信息。如果程序停止,可以从最近的检查点恢复。

你还需要确保数据库的binlog是开启的,并且binlog文件不会被在Flink处理之前清理掉。这样即使Flink作业停止,binlog中的数据仍然可用。手动控制作业的保存点,可以使用Flink的Savepoint功能。Savepoint是作业的一个一致性快照,可以手动触发并保存到文件系统中。

这样你试试

Apache Flink CDC (Change Data Capture) 是一个连接器,用于捕获数据库中的变更事件,并将这些变更事件流式传输到 Flink 数据流中。当 Flink CDC 程序意外停止后,再次启动时,可以通过配置来指定从上次停止的位置继续监听 binlog,即所谓的“断点续传”功能。

Flink CDC 支持两种恢复模式:

earliest: 从最早的可用位置开始消费 binlog。

latest: 从最新的可用位置开始消费 binlog。

specific-offset: 从特定的偏移量开始消费 binlog。

如果想要实现从上次停止的位置继续监听 binlog,你需要使用 specific-offset 模式,并且保存上次消费的 binlog 位置信息。下面是一个简单的示例来说明如何实现这一点:

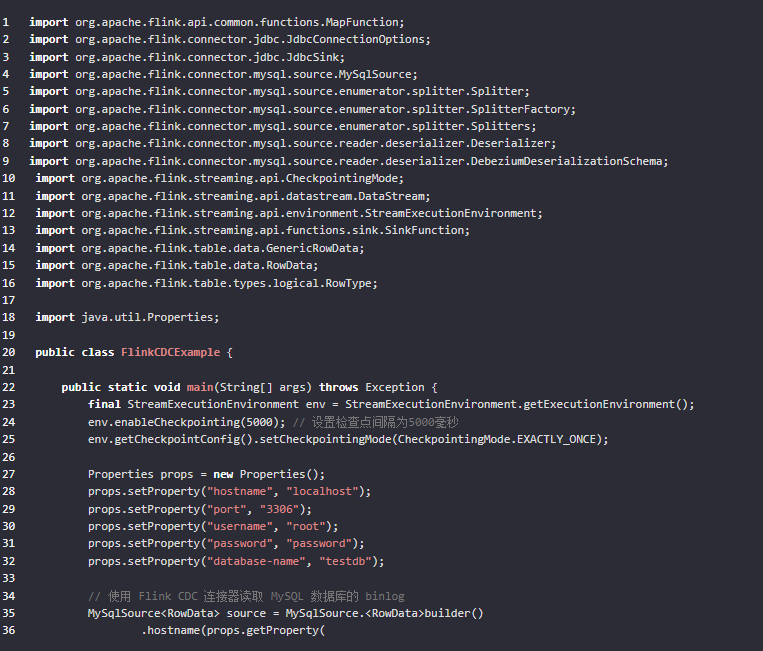

首先,确保你的 Flink CDC 连接器版本支持断点续传功能。接下来,我们将使用 Java API 来配置 Flink CDC 连接器。

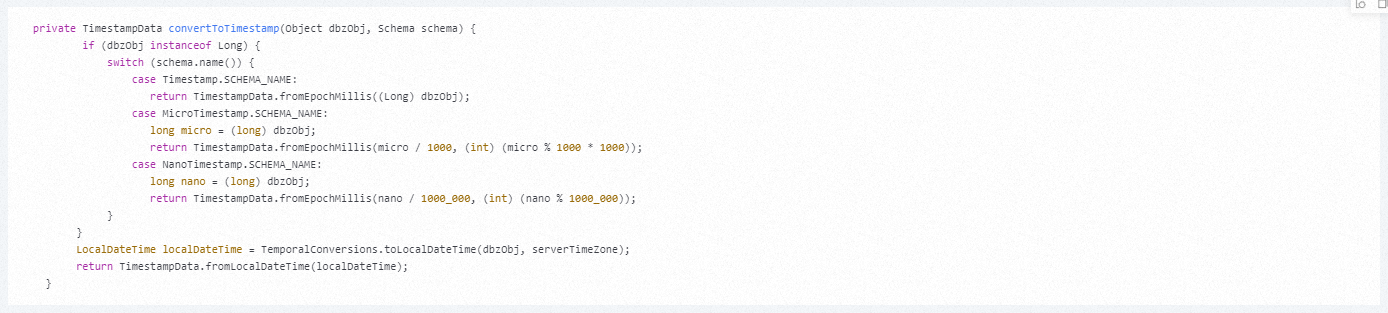

假设你正在使用 MySQL 数据库,以下是一个示例代码片段,展示如何配置 Flink CDC 以实现断点续传功能:

看网上说可以这样的:

配置启动策略:Flink作业重启时,可以通过设置启动策略来控制数据读取的起始位置。有两种主要策略:

全新启动:作业会从配置的初始Binlog位点开始重新消费。如果您希望完全重做整个流程,包括全量导入和之后的增量数据,可以选择此选项。

从最新状态恢复:作业会从上次停止的位置继续消费Binlog,这意味着它会忽略全量导入阶段,直接处理停顿后的新增数据。

还有一个类似的问答看看:https://developer.aliyun.com/ask/635306

设置 snapshot.mode 为 initial 或 when_needed。这将允许 Flink CDC 在启动时首先执行一个快照,然后从上次停止的位置继续处理 binlog。

{

"connector": "sqlserver",

"url": "jdbc:sqlserver://<host>:<port>;databaseName=<database>",

"table-name": "database_name.table_name",

"username": "<username>",

"password": "<password>",

"snapshot.mode": "initial",

"decimal.mapping": "string",

"connect.timeout.ms": "30000",

"connect.max.retries": "3"

}

配置 scan.startup.mode 为 initial 或 latest-offset。initial 模式会在启动时执行全表扫描,而 latest-offset 则会尝试从上次停止的 binlog 位置继续。

为了解决Flink CDC在程序停止后重新启动时能从上次停止的位置继续监听Binlog的需求,可以采取以下措施:

可以自己记录位点,重启的时候从记录的位点开始。你可以试一下 ,此回答整理自钉群“【①群】Apache Flink China社区”

为了让Flink CDC在程序中断后从上次的位点继续监听MySQL的binlog,您需要配置scan.startup.mode。如果Flink作业在运行过程中因故停止,您可以在重启时设置scan.startup.mode为specific-offset,并提供上一次检查点时的Binlog文件名和位置,或者使用timestamp指定一个时间戳来恢复。可以从Flink的Checkpoint日志中获取这些信息,日志前缀是Binlog offset on checkpoint {checkpoint-id}。这样,作业就能从上次检查点的位点继续读取了。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。