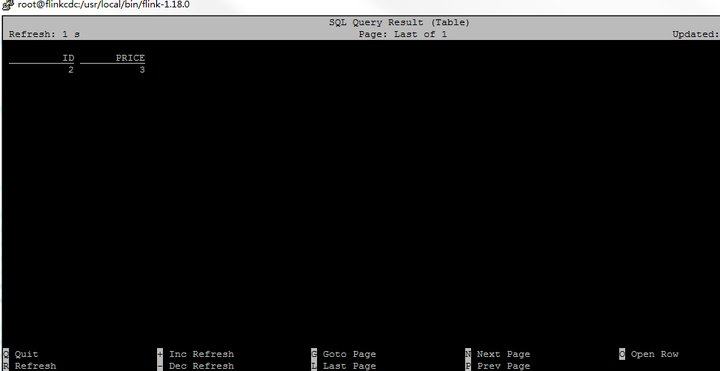

在Flink CDC中oracle这个数据只能读到一行数据,需要怎么处理呢?请参考图片:

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

检查您的Flink CDC配置:确保您已经正确地设置了连接Oracle数据库所需的参数,包括用户名、密码、主机名、端口号和数据库服务名称。

确认表选择:检查您的Flink CDC任务是否选择了正确的表。如果只有一张表被选中,那么可能只有这张表中的数据会被捕获。

验证过滤条件:如果有任何过滤条件或WHERE子句限制了数据的范围,请确保它们不会排除您想要捕获的数据。

检查数据流:查看Flink CDC的任务日志以了解是否有任何错误或警告消息。这可以帮助您确定是否存在数据流问题。

更新刷新频率:根据图片底部的选项,您可以调整刷新频率来更快地看到新数据。尝试增加刷新频率,看看是否可以更快地获取新的数据行。

调整Flink CDC设置:如果上述步骤都无法解决问题,您可能需要进一步调整Flink CDC的设置。例如,您可以尝试更改数据捕获模式(如全量或增量),或者调整其他相关参数。

确认在Flink的SQL DDL中配置Oracle CDC Source时,是否正确设置了所有必需的参数,特别是与连接、登录凭据、以及Oracle数据库的变更数据捕获相关的配置。

第二个呢:主键配置: 对于实时计算引擎vvr-4.0.8-flink-1.13及以后的版本,如果启用了按主键分片的多并发读取功能(默认开启),则必须在DDL中明确指定主键。缺少主键配置可能导致数据读取受限。请检查并确保如果你需要多并发读取,已正确定义了主

Debezium 是 Flink CDC 的底层组件,用于解析数据库日志。确保 Debezium 配置正确,特别是 debezium.log.mining.strategy 和 debezium.log.mining.continuous.mine 参数。这些参数可以帮助优化日志挖掘策略,减少数据延迟

对于 Oracle 数据库,需要确保表的补充日志(Supplemental Logging)配置正确。可以使用以下命令为表添加补充日志:

ALTER TABLE MY_SCHEMA.test ADD SUPPLEMENTAL LOG DATA (ALL) COLUMNS;

http://t.csdnimg.cn/12ETe![image.png]

检查表结构:确认表的结构是否正确,包括字段定义、索引和约束等。

检查数据量:确认表中确实只有一行数据,而不是数据量非常小。

检查连接器配置:确认Flink CDC连接器的配置是否正确,包括数据库连接、表映射等。

检查日志:查看Flink CDC连接器的日志,了解具体的错误信息。

调整连接器参数:根据错误信息,尝试调整连接器的参数,例如调整批量大小、重试次数等。

联系支持:如果上述方法都无法解决问题,联系Flink CDC或Oracle的技术支持团队获取帮助。

使用快照模式:如果连接器支持,可以尝试使用快照模式(snapshot mode)来初始化数据。

重新初始化数据:如果表中确实只有一行数据,可以尝试重新初始化数据,以覆盖现有数据。

针对Flink CDC在处理Oracle数据时只能读取到一行数据的问题,可以从以下几个方面进行排查和解决:

确保配置中没有限制只读取一行数据的参数,比如是否误设了限制读取记录数的选项。

确认Flink CDC的schema提取逻辑是否正确识别了Oracle表结构,特别是在表结构发生DDL变更后,需确保Flink的内部schema与数据库实际schema保持同步。如有需要,可尝试重新初始化作业或更新schema信息。

相关链接

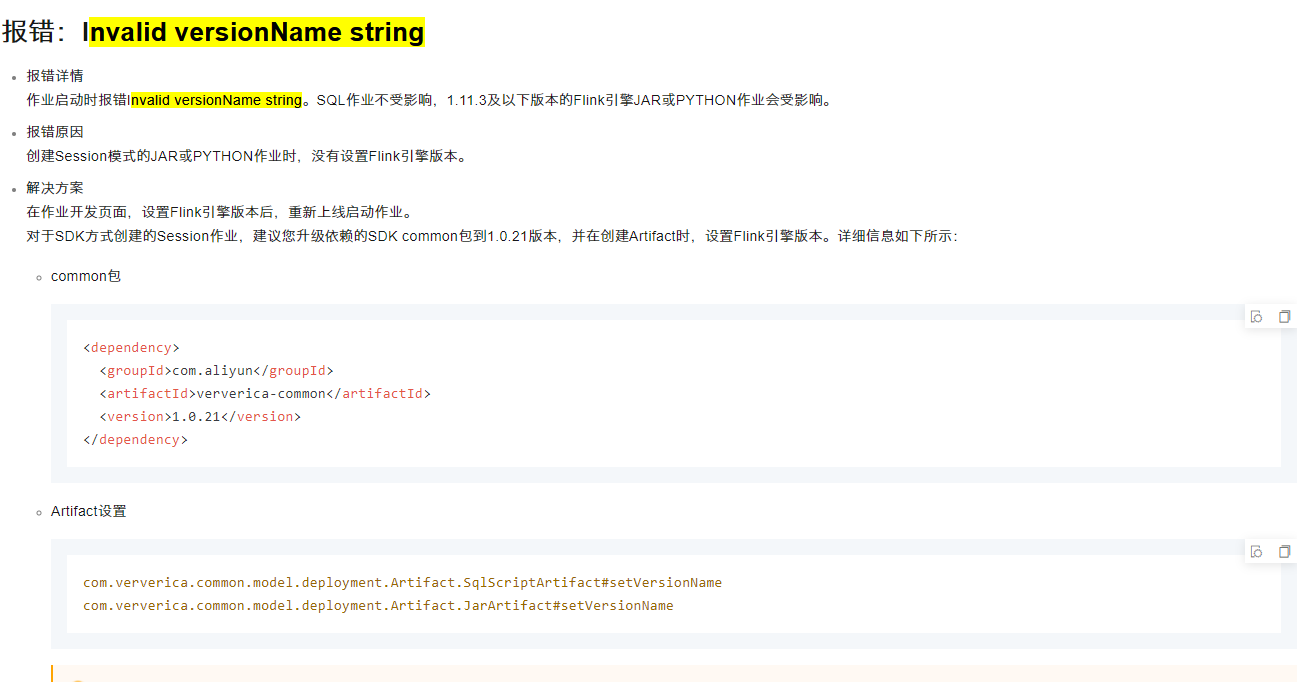

https://help.aliyun.com/zh/flink/support/troubleshooting

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。