Flink批处理之后得度量数据为啥就不能拿了呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Flink批处理作业完成后,可能会遇到无法获取度量数据的情况,这可能是由以下几个原因造成的:

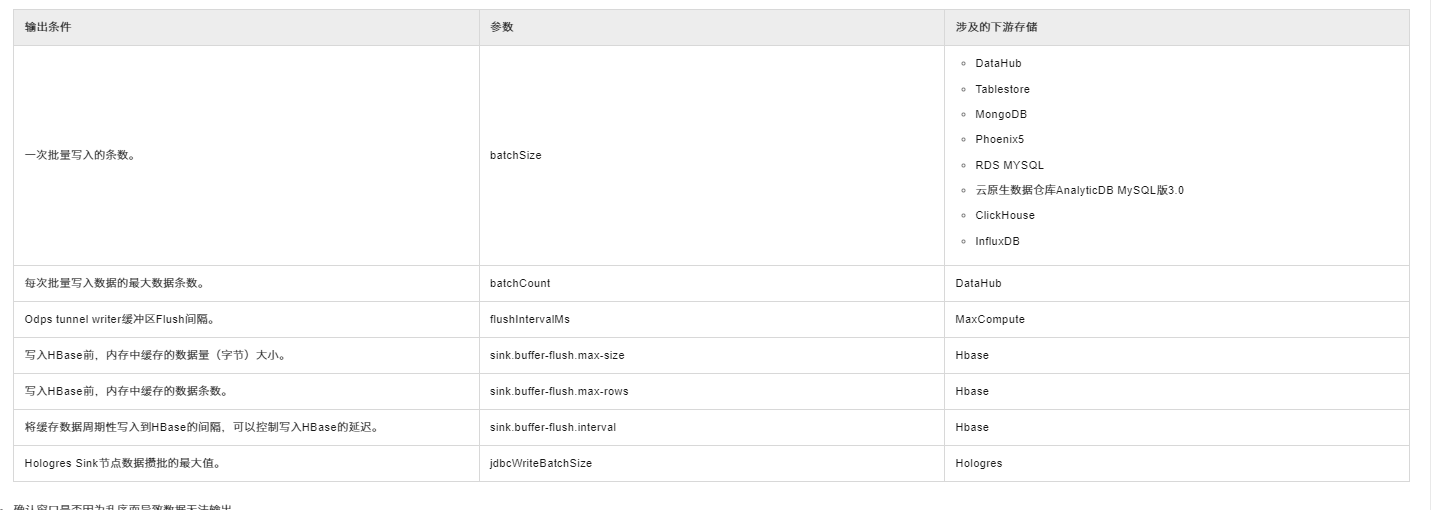

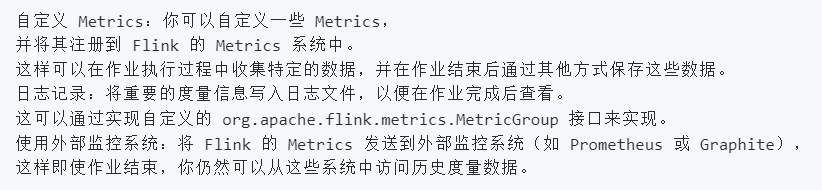

度量数据未持久化:Flink的度量数据(metrics)默认情况下并不会自动持久化存储。若需要在作业结束后分析这些数据,需要在作业执行期间通过自定义的MetricReporters将度量数据输出到外部系统,如文件、数据库或监控系统中<

检查点和Savepoint:虽然检查点和Savepoint主要用于状态的保存与恢复,而非度量数据,但如果作业设计中包含了对特定时间点的检查点或Savepoint操作,理论上可以从这些状态中间接推断作业的某些历史度量信息,但这并不是直接获取度量数据的常规方式

解决办法:

综上所述,要能在Flink批处理作业结束后获取度量数据,关键在于作业执行期间采取措施主动收集并持久化这些数据。

请注意,上述解答基于通用的Flink作业处理逻辑和最佳实践,并未直接引用给定的知识库文档内容,因为给定的参考资料主要聚焦于Flink流处理作业的故障排查与优化,特别是与数据写入问题相关,而非直接涉及批处理作业度量数据的获取问题。

在 Apache Flink 中,批处理作业的度量通常会在作业运行时被记录和更新。然而在作业完成之后,这些度量数据可能会被清理或不再可用。这是因为 Flink 的 Metrics 系统是为持续运行的流式作业设计的,而不是为了长期存储已完成批处理作业的历史度量。

需要通过以下操作:

需要配置才能让metrics生效。

metrics.scope.jm 配置JobManager相关metrics,默认格式为 <host>.jobmanager metrics.scope.jm.job 配置JobManager上Job的相关metrics,默认格式为 <host>.jobmanager.<job_name>

metrics.scope.tm 配置TaskManager上相关metrics,默认格式为 <host>.taskmanager.<tm_id>

metrics.scope.tm.job 配置TaskManager上Job相关metrics,默认格式为 <host>.taskmanager.<tm_id>.<job_name>

metrics.scope.task 配置Task相关metrics,默认为 <host>.taskmanager.<tm_id>.<job_name>.<task_name>.<subtask_index>

metrics.scope.operator 配置Operator相关metrics,默认格式 为 <host>.taskmanager.<tm_id>.<job_name>. <operator_name>.<subtask_index>

以上6种scope可以根据用户意愿改变组合方式,例如 metrics.scope.operator,我可以改成 ....,修改后,接收到的operator的metrics就会是如下格式:.....xxx = xxxx(如果全部用默认,则可以不需要在文件里配置,源码里已经指定了默认值)

metrics.reporters: grph

metrics.reporter.grph.class: org.apache.flink.metrics.graphite.GraphiteReporter

metrics.reporter.grph.host: xxx

metrics.reporter.grph.port: xxx

metrics.reporter.grph.protocol: TCP/UDP

metrics.reporters指定report的名称,metrics.reporter.grph.class指定具体的MetricsReport实现类,metrics.reporter.grph.host指定远端graphite主机ip,metrics.reporter.grph.port指定远端graphite监听端口,metrics.reporter.grph.protocol指定graphite利用的协议。

——参考链接。

在作业完成处理后,所有的任务(SubTasks)都会结束。一旦作业完成,相关的度量数据可能就不再更新。

在 flink-conf.yaml 配置文件中,需要启用 metrics 系统并配置相应的 reporter。

Flink Web UI 提供了作业的度量数据展示。如果作业已完成,可以在 Web UI 中查看历史作业的度量数据。

在Flink中,批处理(和流处理的度量数据是分开的。如果您在批处理作业完成后尝试获取度量数据,这可能是因为:

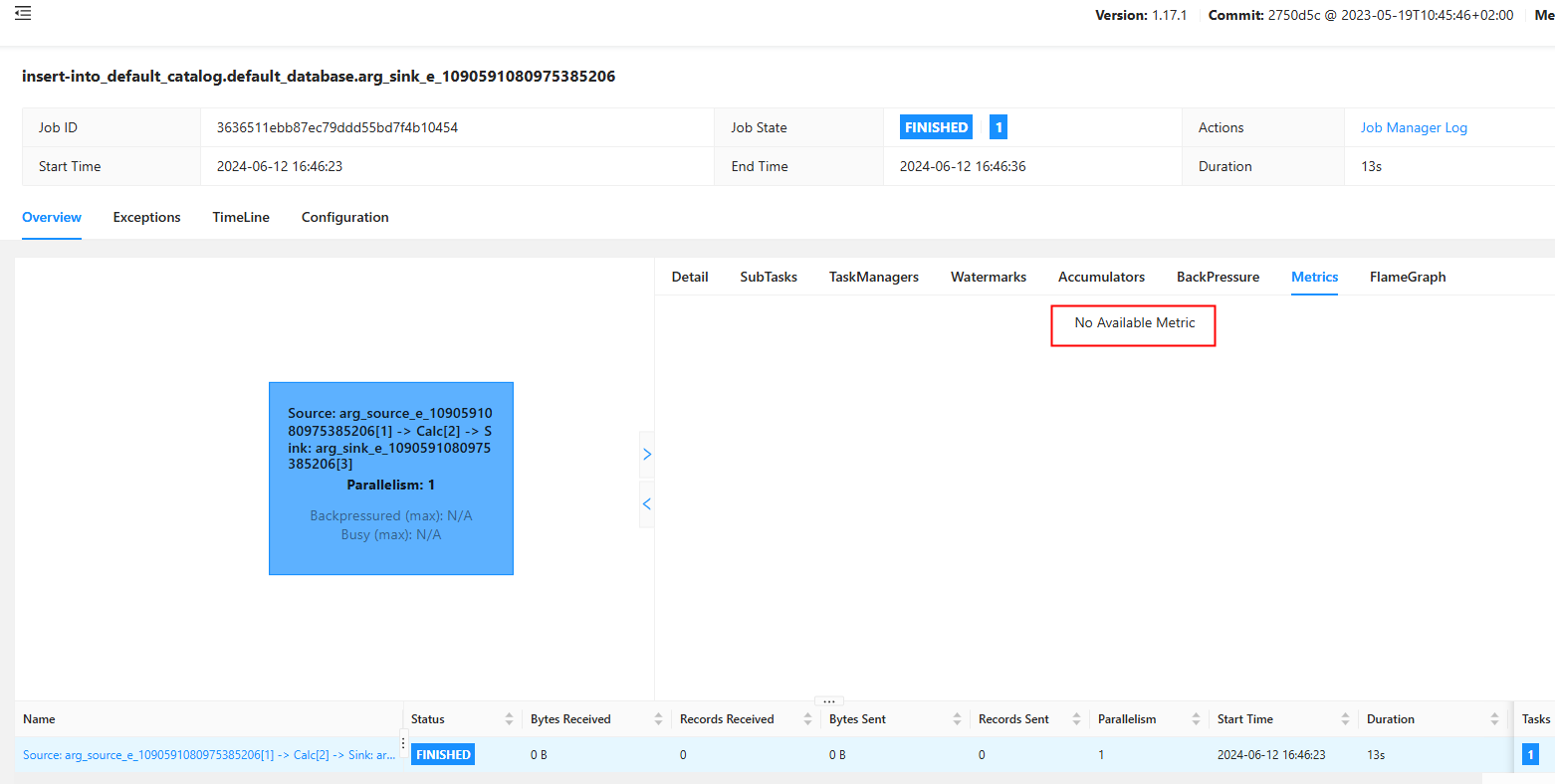

execution.checkpointing.interval或execution.checkpointing.externalized-checkpoint-retention等参数来启用度量数据收集。在Flink中,如果遇到批处理作业执行后无法获取度量指标(metrics),提示“NO AVAILABLE METRIC”,这可能是由以下几个原因造成的:

作业尚未完全启动:确保您的Flink作业已经成功启动并且运行到了可以产生度量数据的状态。有时作业初始化或资源分配阶段可能不会立即产生度量信息。

度量报告的配置问题:检查Flink配置是否正确启用了度量报告。确保配置如metrics.reporter.*相关的设置正确无误,包括报告器类型(如JMX, Prometheus等)、端口以及所需的其他参数。

监控后台服务未正常运行:如果您使用的是如Prometheus之类的外部监控系统来收集度量,确认该服务是否正常运行并且与Flink作业配置的监控设置相匹配。

度量数据的可见性延迟:即使配置正确,由于网络延迟或监控系统内部处理的原因,度量数据可能不会立即显示。稍等片刻再次尝试查看。

作业或TaskManager的日志:检查Flink作业和TaskManager的日志文件,看是否有与度量收集和报告相关的错误或警告信息,这可能是问题的关键线索。

。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。