k8s native session模式下,flink run指定的classpath好像没有生效,哪位大神了解么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在Kubernetes原生(native)Session模式下,若遇到通过flink run指定的classpath路径未生效的问题,可以遵循以下步骤进行排查和解决:

检查Classpath配置方式:

确认在提交Flink作业时,是否正确指定了额外的classpath。通常,可以通过--class-path或简写-cp参数来追加classpath路径<>。请确保命令格式正确无误,例如:

flink run -c your.main.Class -cp /path/to/your/jars/* your-job.jar

ClassLoader JAR包配置:

根据文档指导,对于包含连接器的作业,需要确保Flink能够加载到运行时所需的类。这通常涉及到配置ClassLoader JAR包,如ververica-classloader-x.x.x.jar。在Kubernetes环境中,你需要确保这些依赖也正确打包进你的job jar或通过volume挂载到所有相关pod中,并且Flink配置文件(如flink-conf.yaml)正确指向这些依赖

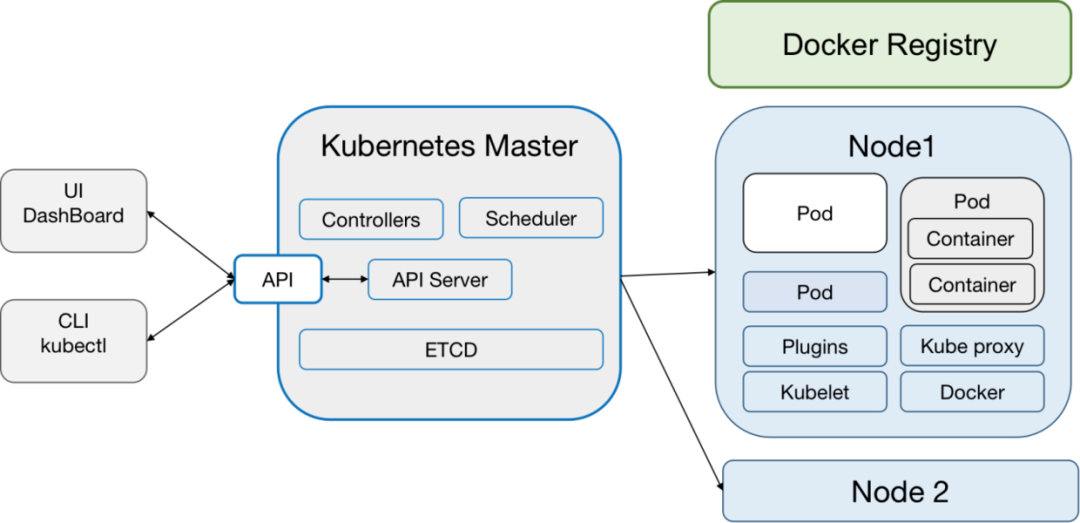

Kubernetes资源定义检查:

如果你是在Kubernetes上通过YAML文件定义Flink Deployment或Job,检查Deployment或Job的定义中是否正确设置了volume挂载、环境变量或命令行参数,以确保Flink进程能够访问到所有必要的类路径资源。

Flink配置调整:

在Flink配置文件中,检查或添加如jobmanager.classpath和taskmanager.classpath等配置项,确保它们包含了所有必要的目录和JAR文件路径。

Pod重启与日志检查:

修改配置后,可能需要重启相关的Flink JobManager或TaskManager Pod。之后,通过Kubernetes日志收集工具(如kubectl logs)检查Pod日志,确认是否仍有类找不到的错误信息,这有助于进一步定位问题。

资源隔离与权限:

确保Kubernetes集群中的Pod具有访问指定classpath路径的权限,避免因权限不足导致的类加载失败。

Pod 配置错误:在 Kubernetes 中,Flink 作业的 Pod 配置可能没有正确设置。确保 classpath 已经被正确地传递给 Flink 作业。

Flink 配置:在 Flink 的配置文件中(通常是 flink-conf.yaml),你可能需要设置 jobmanager.heap.size、taskmanager.heap.size 等参数来确保有足够的内存来加载和运行你的作业。

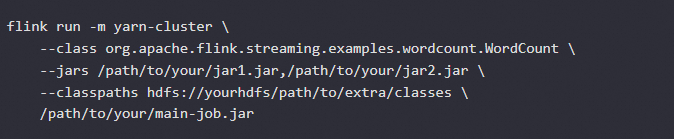

在 Kubernetes (k8s) Native Session模式下运行 Apache Flink 作业时,如果通过 --classpaths 参数指定的 classpath 没有生效,这通常是因为配置或部署过程中的某些问题。

确保 --classpaths 参数正确设置。

检查 Flink 配置和部署脚本以确保 classpath 正确传递给容器。

使用 --jars 或 --py-files 参数来添加依赖文件可能更可靠。

示例如下:

尝试配置如下操作:

# 编辑配置文件

vim /etc/profile

# 在末尾追加

export JAVA_HOME=/app/jdk1.8.0_202

export JRE_HOME=/app/jdk1.8.0_202/jre

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$PATH

# 使配置文件生效

source /etc/profile

——参考链接。

度量注册:确保您的度量(metrics)已经在 Flink 作业中正确注册。

度量收集:检查是否正确设置了度量收集器,比如使用 MetricQueryService。

Flink 并没有提供直接的“清理缓存”操作,但是您可以通过以下方法间接清理:

重启集群:重启 Flink 集群可以清理状态后端和缓存。

手动清理状态后端:如果是使用文件系统或其他存储作为状态后端,可以手动清理存储上的文件

在Kubernetes原生(k8s-native)会话模式下运行Apache Flink作业时,如果你遇到了指定的classpath没有生效的问题,可能是因为几个原因造成的。下面是一些排查和解决这个问题的建议:

检查Flink配置:

确保你在提交作业时正确地设置了--class-path或-cp参数。在使用flink run命令时,可以通过-yt或--yt-mode指定运行模式,同时加上-c来指定主类,并且通过-p来指定额外的类路径。例如:

flink run -yt kubernetes-session -c your.main.Class -p /path/to/your/jars your-job.jar

依赖打包:

确认你的Flink作业JAR文件中包含了所有必要的依赖,或者这些依赖已经被正确地添加到了Kubernetes pod的类路径中。有时候,即使指定了额外的类路径,但如果依赖没有正确打包或指定,Flink可能无法识别它们。

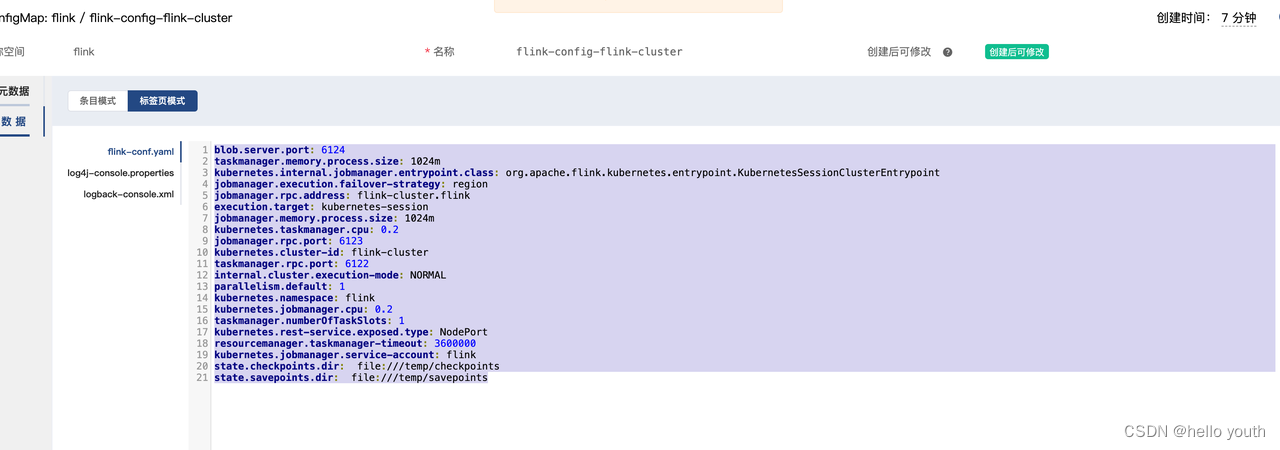

Kubernetes Pod模板:

在K8s-native模式下,Flink作业的执行是通过Kubernetes的Pod来完成的。检查你的Flink配置文件(如flink-conf.yaml)中与Kubernetes相关的设置,特别是是否自定义了Pod模板(通过kubernetes.pod-template-file配置项)。确保在这个模板中正确地挂载了额外的卷或设置了环境变量,以便类路径中的所有依赖都能被Pod访问。

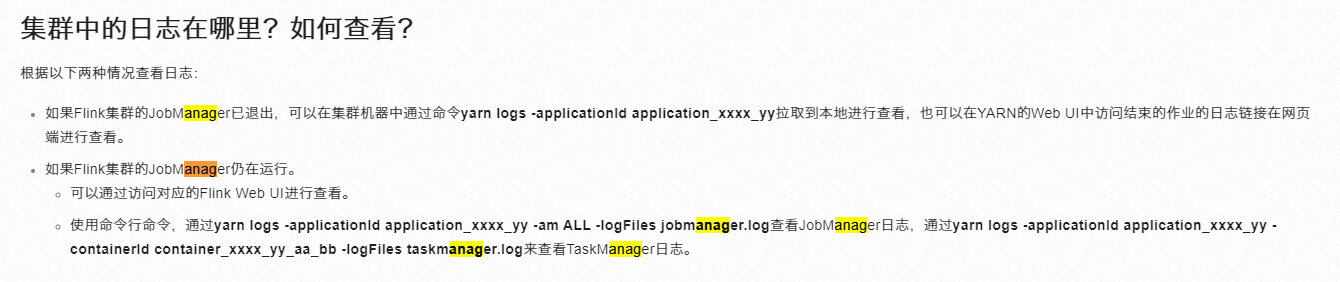

日志分析:

查看Flink作业管理器和任务管理器的日志,这些日志通常会提供关于类路径设置是否生效以及任何类找不到错误的线索。日志可以通过Kubernetes的日志功能获取,例如使用kubectl logs命令。

资源限制:

确认没有因资源限制(如内存、CPU)导致的类加载问题。虽然这不直接与类路径相关,但资源不足可能导致类加载失败或异常行为。

Flink版本兼容性:

确保你使用的Flink版本与Kubernetes原生集成没有已知的问题。有时,特定版本的Flink可能在K8s-native模式下有已知的bug,升级到较新版本可能解决问题。

如果上述步骤都无法解决问题,考虑在Flink的用户邮件列表或社区论坛中寻求帮助,提供详细的错误信息和你的配置详情,以便获得更专业的指导。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。