问下 Flink经常报

是什么意思,内存不足吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

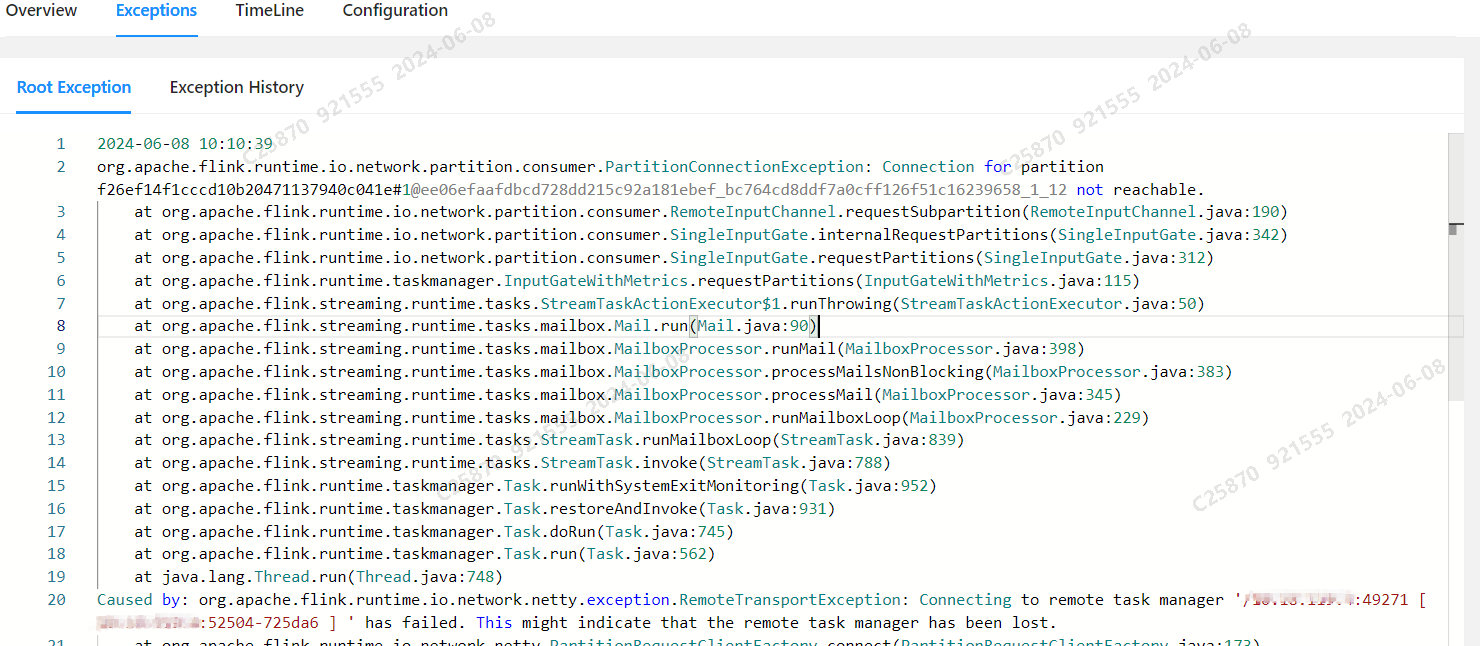

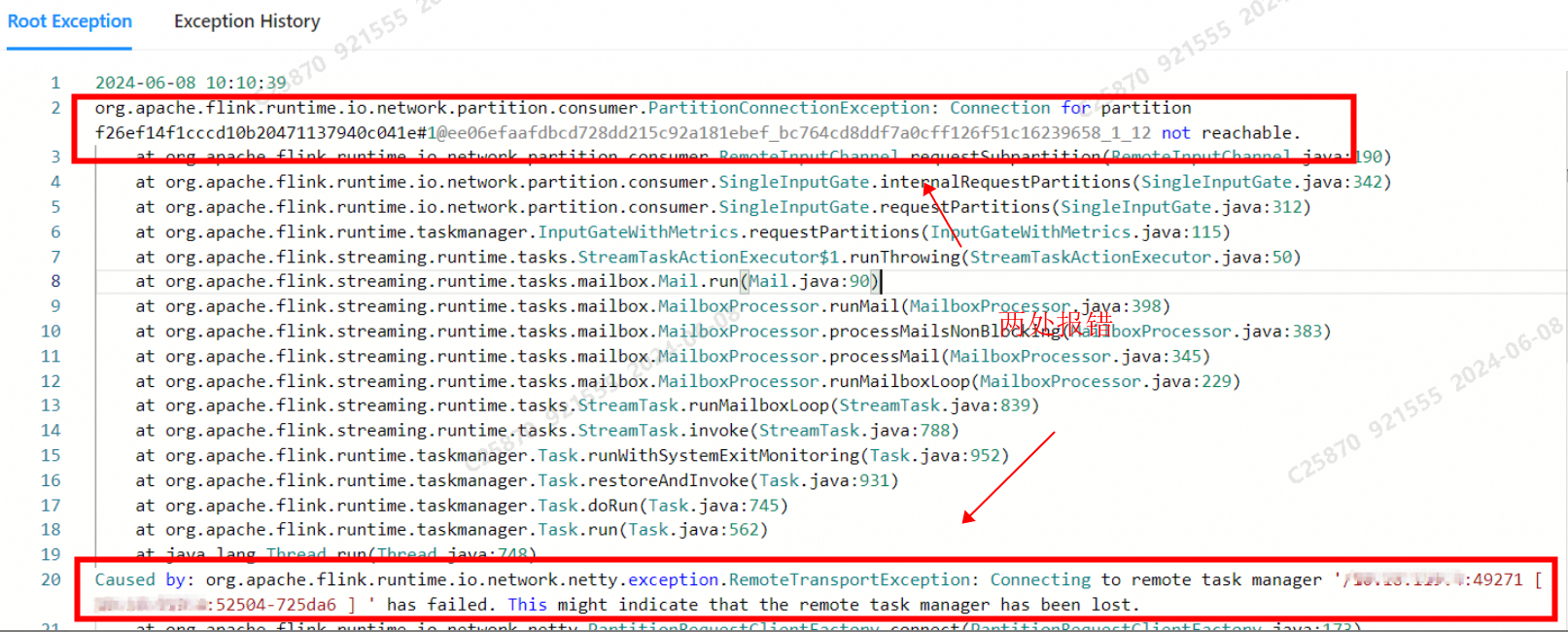

针对您提到的Flink应用程序遇到的PartitionConnectionException异常,

PartitionConnectionException,但文档中提到了处理数据源读写异常的指导[3]。这提示我们检查数据流的两端——源头数据的可访问性以及目标系统的写入权限和配置。PartitionConnectionException的具体原因和上下文信息。在 Apache Flink 中,PartitionConnectionException 是一个运行时异常,它通常表示在尝试与一个或多个数据分区进行通信时出现了问题。这个异常可能是由于多种原因引起的,包括但不限于网络问题、数据分区所在的节点故障、数据分区分配策略问题等。

查看日志:首先,检查 Flink 的日志文件以获取更多的上下文信息。PartitionConnectionException 通常会在 Flink 的任务日志中记录详细信息,包括异常堆栈跟踪和可能的错误消息。

检查网络连接:确保数据分区所在的节点与其他 Flink 节点之间的网络连接是正常的。网络问题可能是导致这个异常的原因之一。

检查数据分区状态:检查 Flink 集群中数据分区的状态。确保数据分区没有被错误地分配,或者没有被意外地停止或重启。

检查 Flink 配置:确保 Flink 的配置参数(如 rest.address、rest.port 等)正确无误,并且与你的集群设置相匹配。

检查数据分区分配策略:如果你使用了自定义的数据分区分配策略,确保该策略没有问题,并且没有意外地导致数据分区无法正确地被访问。

使用 Flink UI:访问 Flink UI(通常在 http://:8081)来查看任务的详细信息,包括任务的状态、输入和输出数据的分区信息等。

检查代码:最后,检查你的 Flink 作业代码,确保没有逻辑错误导致了对数据分区的不正确访问。

解决 PartitionConnectionException 通常需要综合考虑以上因素,并根据具体情况来采取相应的措施。如果问题依然无法解决,你可能需要提供更详细的日志信息,以便于进一步诊断问题。

根据您提供的错误信息,看起来您的Flink应用程序遇到了一个名为PartitionConnectionException的异常。这个异常通常表示Flink集群中的某个组件(可能是TaskManager)无法连接到另一个组件(可能是JobManager或另一个TaskManager)。这可能由多种原因引起,包括网络问题、资源限制(如内存不足)、任务管理器故障等。

这些错误表明可能存在与远程TaskManager的通信问题。然而内存不足并不是导致此特定错误的主要因素。

检查网络连接:确保所有 TaskManagers 和 JobManagers 之间的网络连接正常。

查看日志:查看其他节点的日志文件以获取更多上下文信息。

监控系统资源:监控系统的 CPU、内存和其他资源使用情况,看看是否有任何瓶颈。

调整配置参数:尝试调整 Flink 配置参数来优化性能,例如增加并行度、减少批处理间隔等。

是,调整管理内存大小,同步cache大小也调整

state.backend.incremental=true;

taskmanager.memory.managed.fraction =0.3;

state.backend.rocksdb.block.blocksize=64 kb;

state.backend.rocksdb.block.cache-size=128 mb;

state.backend.rocksdb.files.open = -1;

state.backend.rocksdb.writebuffer.size =128 mb;

state.backend.rocksdb.writebuffer.count=4;

state.backend.rocksdb.writebuffer.number-to-merge=2;

state.backend.rocksdb.compaction.style=level;

state.backend.rocksdb.thread.num=4;

state.backend.rocksdb.metrics.block-cache-usage=true;

state.backend.rocksdb.checkpoint.transfer.thread.num=8;

table.dynamic-table-options.enabled=true;

table.exec.mini-batch.enabled=true;

table.exec.mini-batch.size=35000;

table.optimizer.distinct-agg.split.enabled=true;

table.exec.mini-batch.allow-latency=15 s;

——参考链接。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。