flink-connector-elasticsearch7 废弃了ElasticsearchConnectorOptions 这个类 但是sql 加载的时候报错找不到这个 类,有大佬解决过这个吗?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果你在使用 Flink-connector-elasticsearch7 时遇到了 ElasticsearchConnectorOptions 类被废弃的问题,并且在使用 SQL 加载时报告找不到这个类的错误,这可能是因为你的代码或配置仍然引用了这个已经被废弃的类。

解决这个问题的方法是更新你的代码和配置,使用新的类或方法来替代 ElasticsearchConnectorOptions。

具体来说,你可以按照以下步骤进行:

查看文档:查阅 Flink-connector-elasticsearch7 的官方文档,了解 ElasticsearchConnectorOptions 类被废弃的具体原因,以及应该如何替代。

更新代码:在你的代码中,将所有引用 ElasticsearchConnectorOptions 的地方替换为新的类或方法。

更新配置:如果你的配置文件中仍然引用了 ElasticsearchConnectorOptions,也需要将其替换为新的配置项。

重新编译和测试:更新代码和配置后,重新编译你的项目,并进行测试,确保一切正常。

遇到问题描述的情况,即flink-connector-elasticsearch7已废弃了ElasticsearchConnectorOptions类,但在使用SQL加载时仍报错找不到该类,这可能是由于以下几个原因导致的:

依赖版本不匹配:首先确认你的Flink版本与Elasticsearch connector版本是否兼容。特别是当使用了较新版本的Flink或connector时,某些旧的类或接口可能已被移除或替换。请检查并确保使用的flink-connector-elasticsearch7版本与你的Flink核心库版本相适应,并且该版本的connector确实不再需要ElasticsearchConnectorOptions类。

遗留代码问题:如果项目中存在遗留代码或配置文件仍然引用了ElasticsearchConnectorOptions,你需要根据最新的connector API进行相应调整。查阅最新的connector文档,了解如何正确配置Elasticsearch连接器,特别是如何在SQL DDL中指定Elasticsearch连接参数,如endpoint、indexName等。

清理和重建项目:有时即使更新了依赖,IDE或构建系统可能因为缓存问题依旧引用旧的类。尝试清理项目(包括IDE的缓存、Maven或Gradle的本地仓库相关条目),然后重新构建项目,确保所有依赖都是最新且正确的版本。

检查SQL DDL语法:确保在创建Elasticsearch源表或结果表时使用的DDL语法正确无误,根据提供的参考资料,正确配置诸如connector、endPoint、indexName等参数,而不是错误地引用了已废弃的配置类。

查阅官方文档或更新日志:直接访问Flink和Elasticsearch connector的官方文档和更新日志,查找有关ElasticsearchConnectorOptions类被移除的具体信息及替代方案。这有助于理解变更背后的原因以及如何平滑迁移至新的API。

Flink连接Elasticsearch7时遇到ElasticsearchConnectorOptions类找不到的问题,这是因为Flink的版本更新导致的。在新版本中,这个类可能已被废弃或重命名。请检查您使用的Flink版本和对应的连接器版本是否匹配,并参考最新版本的官方文档更新配置方式。

确保Flink版本与Elasticsearch connector版本之间是兼容的。不兼容的版本可能导致类路径问题或缺失方法。检查Flink和Elasticsearch connector的官方文档,确认是否有特定版本的依赖要求。

另外既然ElasticsearchConnectorOptions已被废弃,查找并替换所有使用该类的代码。参考最新的Flink Elasticsearch connector文档,了解如何正确配置和使用Elasticsearch sink或source。可能需要改为使用新的配置方式或类来替代

参考文档

可以传入一个失败处理器,一旦出现写入失败的情况则会回调所传入的处理器用于错误恢复。

DataStream<String> input = ...;

input.addSink(new ElasticsearchSink<>(

config, transportAddresses,

new ElasticsearchSinkFunction<String>() {...},

new ActionRequestFailureHandler() {

@Override

void onFailure(ActionRequest action,

Throwable failure,

int restStatusCode,

RequestIndexer indexer) throw Throwable {

if (ExceptionUtils.containsThrowable(failure, EsRejectedExecutionException.class)) {

// 将失败请求继续加入队列,后续进行重试写入

indexer.add(action);

} else if (ExceptionUtils.containsThrowable(failure, ElasticsearchParseException.class)) {

// 添加自定义的处理逻辑

} else {

throw failure;

}

}

}));

——参考链接。

检查 pom.xml 文件中是否已经包含了正确的 Hive 连接器依赖,如 flink-connector-hive。

检查类路径:确保所有相关的 JAR 文件都已经被包含在 Flink 作业的类路径中。

根据 Flink Connector 的新版本,更新你的代码,使用新的配置类或方法。

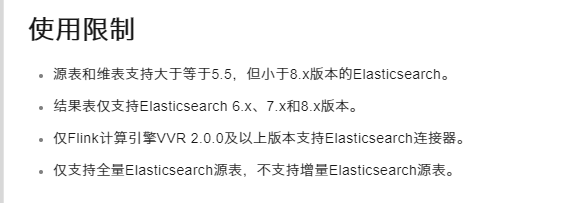

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。