大数据计算MaxCompute的udf是针对数据每行进行操作的,xgb需要对数据整体操作,该怎么改呀?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要解决MaxCompute的UDF针对数据每行操作,而XGBoost需要对数据整体操作的问题,您可以考虑以下几种方法:

使用自定义聚合函数(UDAF):如果您的需求是聚合类的计算,可以使用MaxCompute提供的自定义聚合函数(UDAF)。UDAF允许您定义一个将多条输入记录聚合成一条输出值的函数,这与SQL中的Group By语句联用非常有效。

使用MapReduce模型:如果XGBoost的模型训练需要对整个数据集进行操作,您可能需要使用MapReduce模型来处理数据。在Map阶段,您可以使用UDF对每一行数据进行处理,然后在Reduce阶段将这些结果合并起来,形成一个完整的数据集提供给XGBoost模型进行训练。

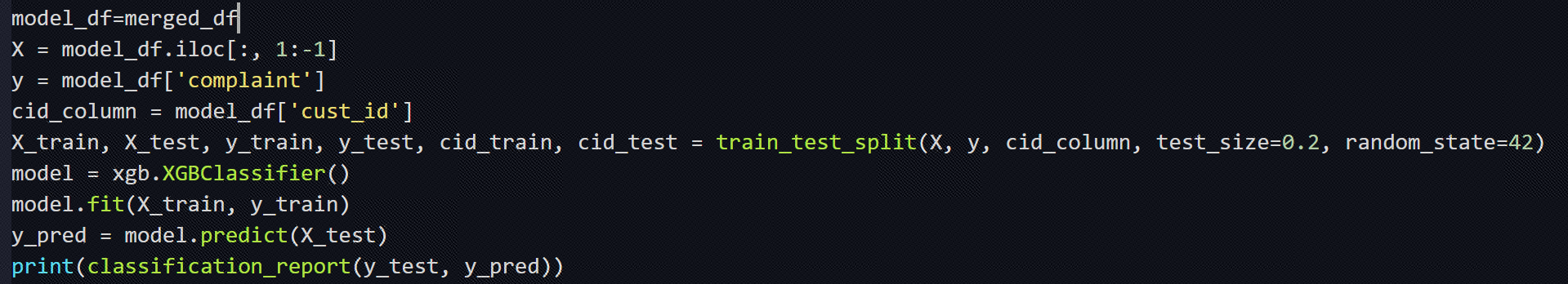

预处理聚合:在将数据送入XGBoost之前,您可以先使用MaxCompute的内置函数或UDF进行必要的预处理和聚合,使得每一行数据都包含了模型训练所需的全部信息。这样,即使UDF是按行操作的,您也能够通过预处理得到适合XGBoost训练的数据集。

利用UDTF生成中间表:如果需要一次函数调用输出多行数据,可以使用自定义表值函数(UDTF)先生成一个中间表,然后对这个中间表应用XGBoost模型进行训练。

调整模型训练方式:根据XGBoost模型的特点,您可能需要调整模型的训练方式,使其能够适应基于行的数据处理。例如,可以尝试将模型训练过程分解为多个步骤,每个步骤处理一部分数据,最后再将结果合并。

使用外部计算引擎:如果MaxCompute的UDF无法满足需求,您也可以考虑将数据导出到支持XGBoost的其他计算平台上进行处理,例如Apache Spark或者直接在单机环境下使用XGBoost。

总的来说,在进行这些操作时,请确保您的UDF代码已经编译成Jar包并上传到MaxCompute中注册,以便在SQL中使用。同时,由于MaxCompute默认不支持通过自定义函数访问外网,如果需要下载XGBoost或其他外部依赖,请确保这些依赖已经被正确部署到MaxCompute的环境中。

xgboost确实比较特殊,需要在UDF里支持batch,这个目前还没有。此回答整理自钉群“MaxFrame官方用户支持群”

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。