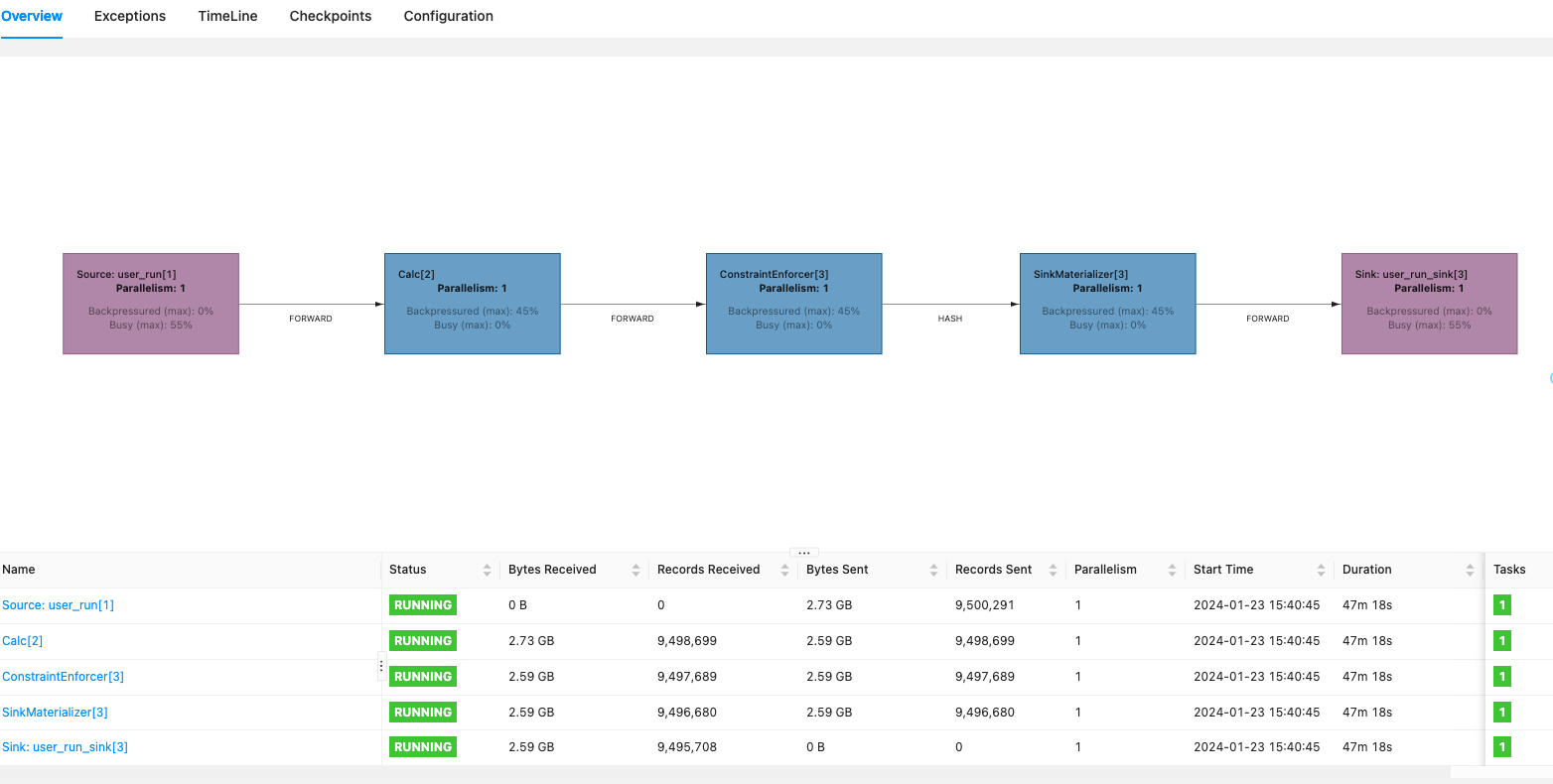

Flink CDC里source:mysql(3kw左右数据)->sink:clickhouse,全量阶段,heap内存一直涨,最后导致pod oomkilled参数:replicas: 1,"parallelism.default", "1",其他大部分是默认可能的原因会是啥呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可能的原因有以下几点:

数据量过大,导致内存占用持续增加。你可以尝试分批次处理数据,每次处理一部分数据,避免一次性加载所有数据到内存中。

没有正确地释放内存。在处理完数据后,确保及时释放不再使用的内存。可以使用Python的gc.collect()手动触发垃圾回收。

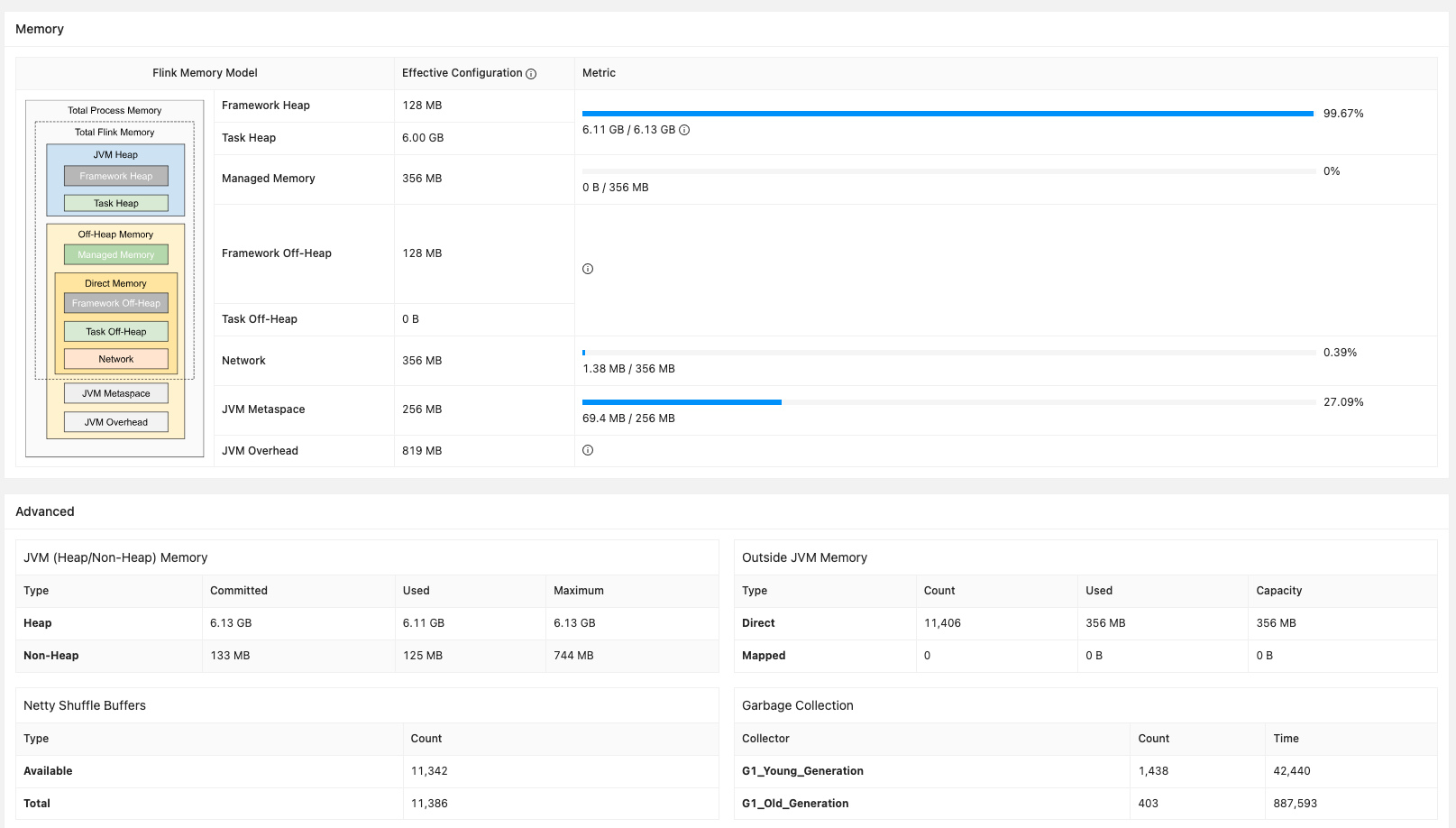

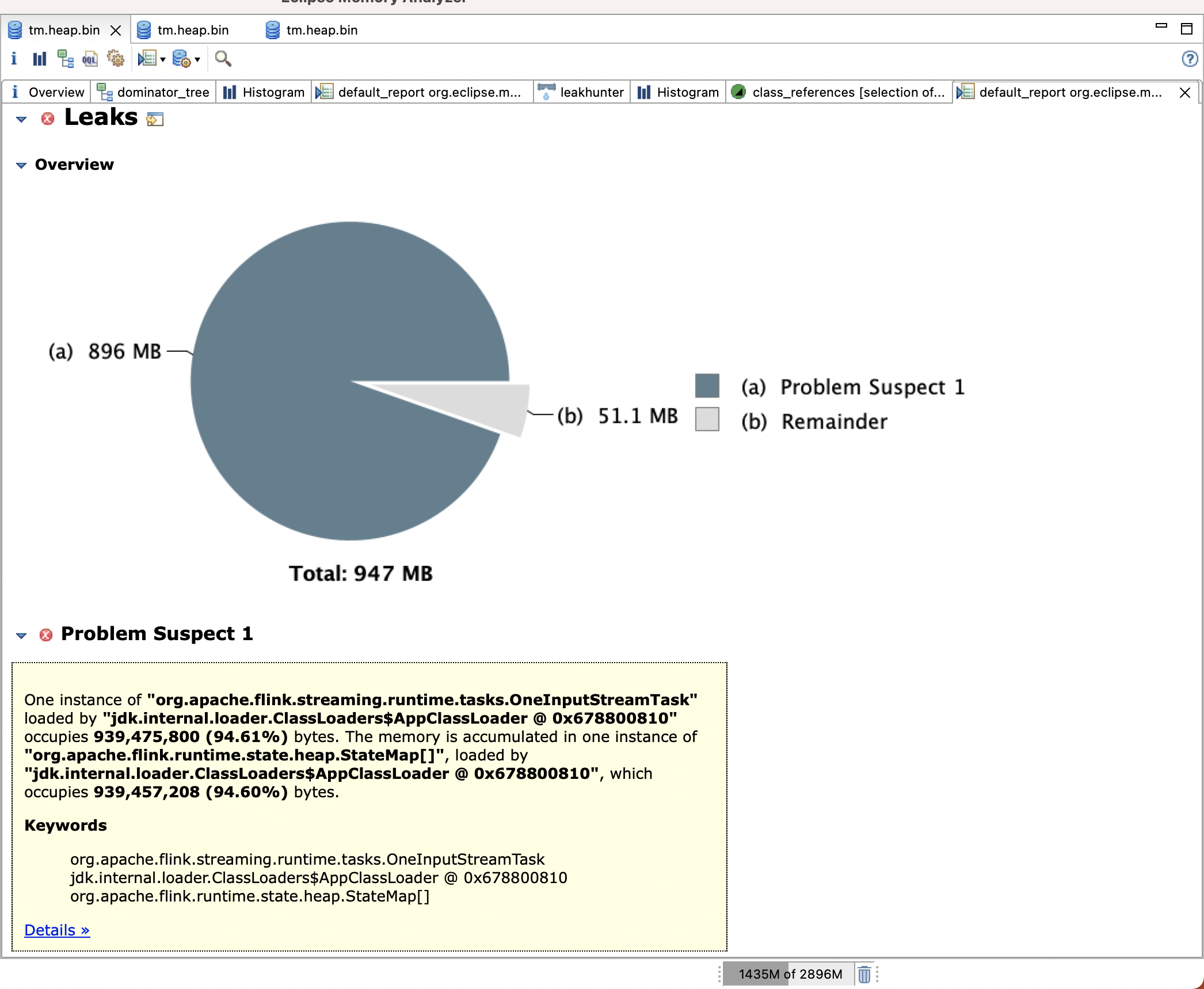

检查是否存在内存泄漏。如果代码中存在内存泄漏,可能导致内存持续增加。可以使用内存分析工具(如Python的memory_profiler)来检查代码中的内存使用情况。

考虑增加Pod的内存限制。如果确实需要处理大量数据,可以考虑增加Pod的内存限制,以避免OOM(内存不足)的问题。但这种方法只是治标不治本,最好还是优化代码以减少内存使用。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。