Flink CDC中msyql短时间内写入大批量数据 正常读取的cdc任务就会不断的报这个错误 重启,有时候能成功 有时候重启也还是报这个错误,目前还未修复,除了等写入任务结束后,重启任务从最新的日志读,然后补数据,还有其它方式能解决原本的任务数据的一致性么?

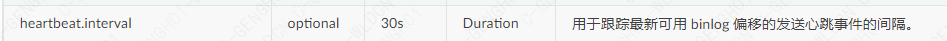

目前我这边后续还会经常有大批数据写入的情况 不然每次都得补一遍数据了,这个值默认的30s 我昨天测试加到60s 300s还是会出现

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

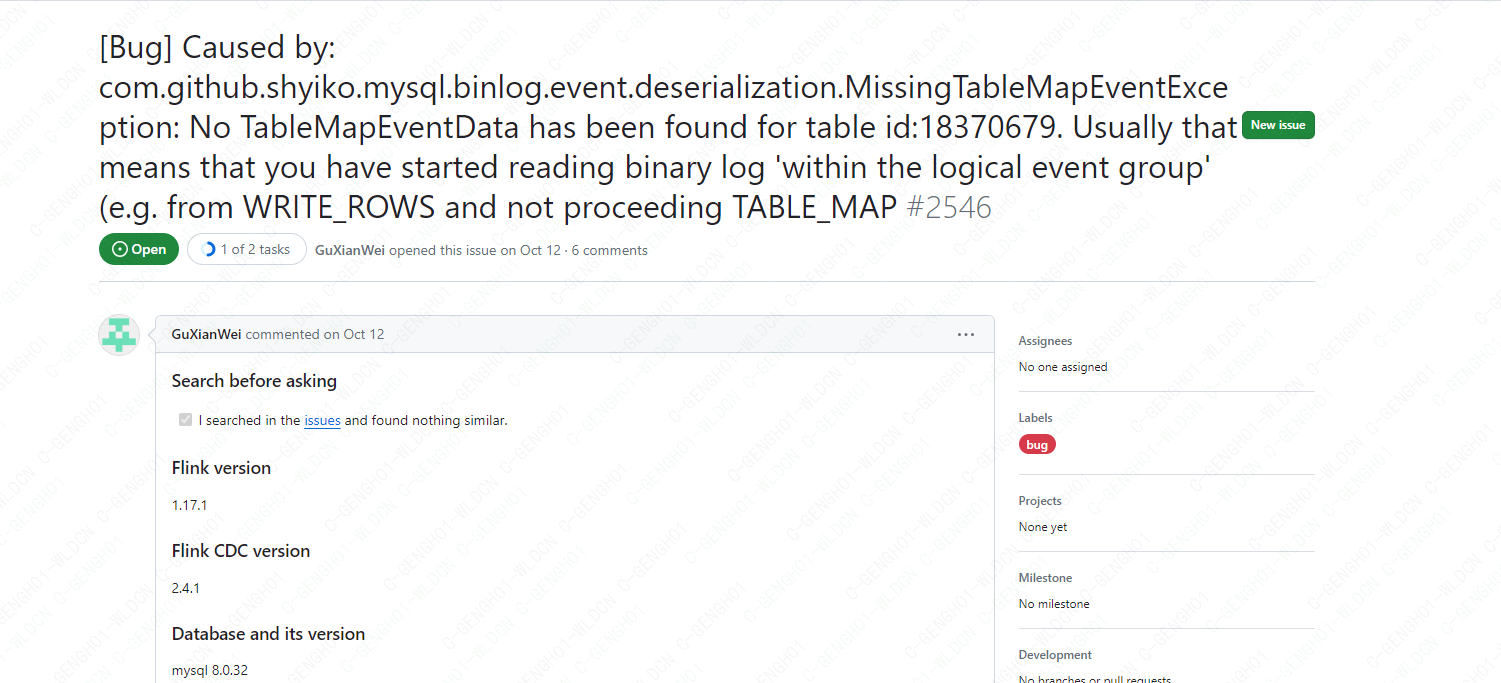

在Flink CDC中,如果MySQL在短时间内写入大量数据,可能会导致CDC任务出现错误。这是因为Flink CDC在处理数据时需要消耗一定的系统资源,而大量的数据写入可能会超出系统的处理能力。

除了等待写入任务结束、重启任务并从最新的日志读取之外,还有以下几种可能的方式可以解决该问题:

1:尝试增大点心跳时间

2:采集文件数量增大点,不过我好像没遇到你的钱问题,我晚上也会有离线百万的数据来刷数据到mysql,mysql-cdc一直是好的,目前没人修复的话,只能不断通过该参数调试的,此回答整理自钉群“Flink CDC 社区”

除了等待写入任务结束后重启任务从最新的日志读并补数据外,还可以尝试以下方式来保证原本的任务数据的一致性:

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。