你们是如何解决Hudi与Flink的checkpoint一致性问题的?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

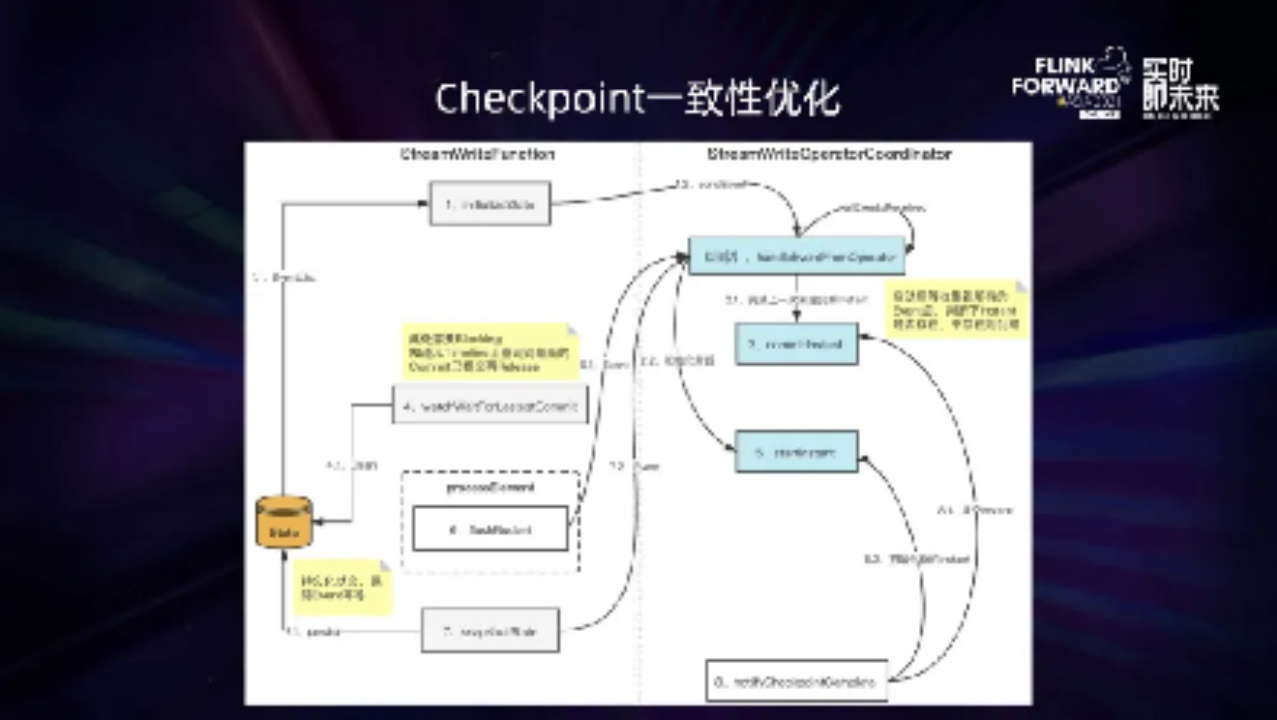

为了解决Hudi与Flink的checkpoint一致性问题,我们对任务进行了重构。Writer算子在checkpoint时,会将汇报给writer coordinator的信息进行state持久化。任务重启后,这些信息会重新汇报给writer coordinator算子。writer coordinator算子收集所有writer算子的信息,并进行一次commit判断,确保对应的commit已经完成。同时,Writer算子会保持阻塞状态,直到上次持久化的commit完成

后,才会处理最新的数据。这样,我们就对齐了Hudi与Flink的checkpoint机制,保证了边界场景数据的一致性。