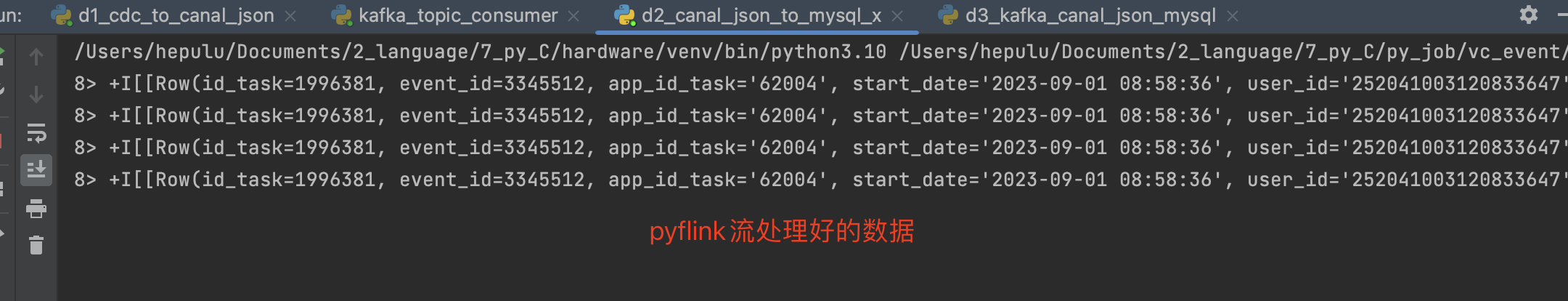

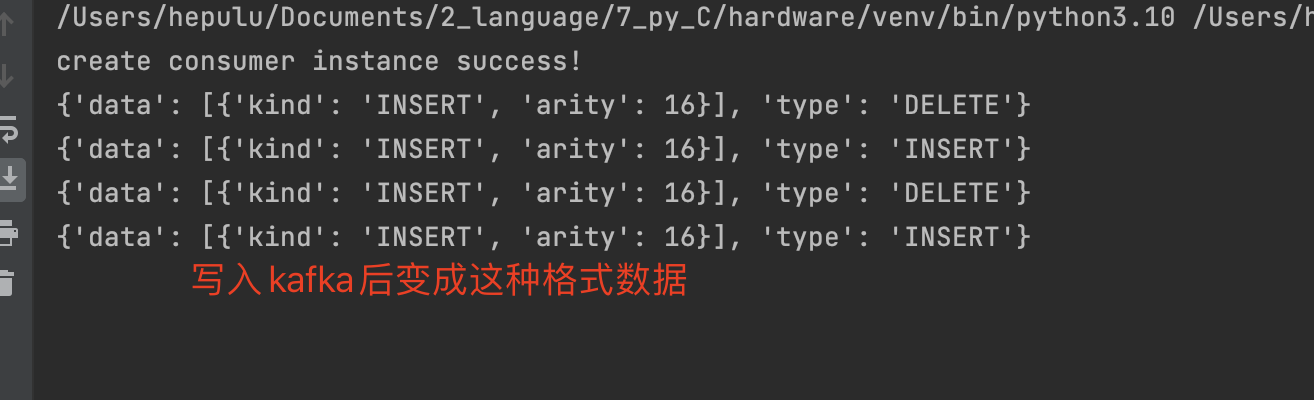

我这边使用pyflink将json的流数据写入kafka后,消费得到的数据却变成字段个数统计。如上面两图所示。请问应该如何解决?使得消费得到的数据和写入数据一致。请大神帮忙掌掌眼

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的图片,我无法查看或打开图像文件。但是,我可以为您提供一些建议来解决使用PyFlink将JSON流数据写入Kafka后,在消费时出现字段个数统计的问题。

检查数据格式:首先,确保写入Kafka的数据格式是正确的。JSON数据应该是符合预期的结构和字段,可以使用JSON验证工具来检查数据的格式是否正确。

检查数据序列化和反序列化:在生产者(写入Kafka)和消费者(从Kafka消费)端,确保正确地使用了相同的数据序列化和反序列化方式。例如,PyFlink中使用的是JSON格式,那么在消费端也需要使用相同的方式进行反序列化。

检查消费者代码:在消费者端,确保正确地解析和处理从Kafka消费的数据。检查消费者代码,确保正确地读取和解析JSON数据,并以预期的方式进行处理。

版本兼容性:确保使用的PyFlink版本和Kafka版本是兼容的。不同版本之间的API和行为可能会有所差异,可能导致数据读取和解析的问题。

日志调试:在消费者端,可以添加日志输出来跟踪数据的读取和解析过程。通过查看日志,可以定位到可能导致数据字段个数统计问题的地方,并进行逐步调试。

请根据您的具体情况和代码进行适当的检查和调试。如果您需要进一步的帮助,请提供更多代码和详细的问题描述,我将尽力为您提供支持。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。