大佬,Flink CDC可不可以在从sp,或是cp恢复的时候重新读取下元数据,这个新增字段的时候就只用停掉,然后再接上scn就好了?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

可以的。Flink CDC可以在从Spark或Hive恢复时重新读取元数据,并在新增字段时只停止并重新接上SCN。这可以通过在Flink CDC中使用适当的元数据存储和读取机制来实现。例如,可以使用Hive Metastore来存储元数据,并使用Flink的Hive Metastore Connector来读取元数据。在新增字段时,可以停止Flink CDC,更新元数据,然后重新启动Flink CDC并连接到SCN。这样,Flink CDC就可以正确地处理新增的字段。

当使用Flink CDC从Source (sp、cp)恢复时,是可以重新读取元数据的。元数据包含有关changelog的信息,以便Flink可以了解如何从changelog中捕获增量数据变更。如果在恢复过程中出现了新增字段,您通常需要采取以下步骤:

Flink CDC可以在从Sp或Cp恢复时重新读取元数据,但这个过程通常需要停掉Flink作业并重新启动。这是因为Flink CDC在启动时读取元数据信息,并在整个作业生命周期中保持不变。因此,如果元数据发生了变化,你需要重新启动Flink作业以使它重新读取并应用最新的元数据信息。

对于新增字段的情况,你可以在Flink CDC作业启动时检测到元数据的变化,然后停止接收新的数据流并等待旧的数据流处理完毕。这样可以确保新旧数据流的一致性。然后,你可以使用特定的时间戳或SCN(系统更改号)来重新开始从源系统接收数据流,以获取最新的元数据信息。

楼主你好,阿里云Flink CDC在从sp或cp恢复的过程中,是会重新读取元数据的。当新增字段时,您可以通过停止CDC任务,修改元数据,然后重新启动任务来重新加载元数据,以实现能够正确地解析新增字段。

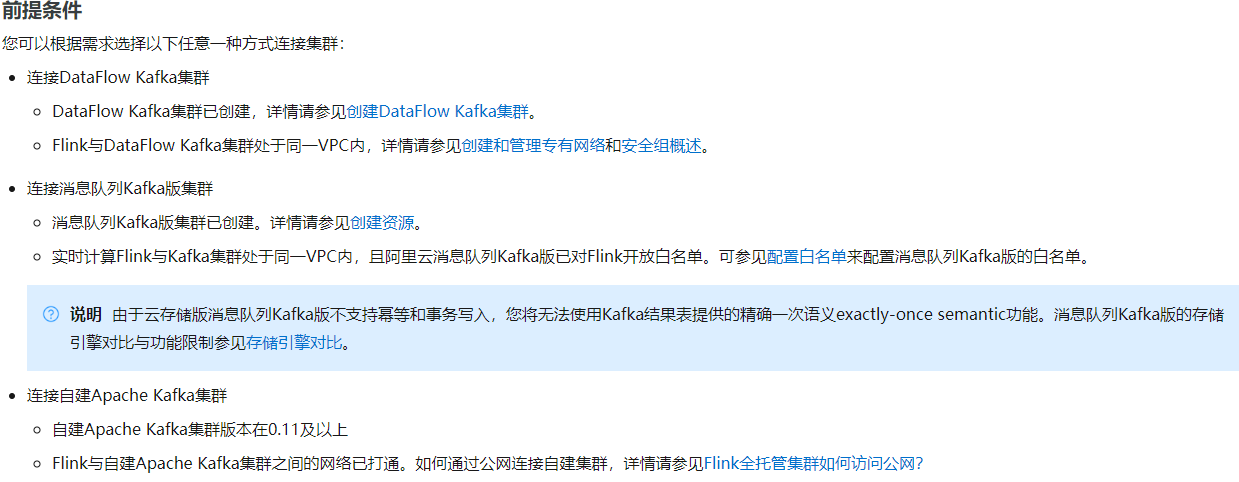

在阿里云Flink CDC中,元数据存储在外部元数据存储中心(如Redis)中,并可通过配置进行定期刷新,以保证元数据的实时性。还有就是前提看一下:

Flink CDC可以在从Sp或Cp恢复时重新读取元数据,但具体实现方式可能因Flink版本和配置而有所不同。一般来说,Flink CDC提供了重新读取元数据的选项,可以在恢复时重新建立与数据库的连接并读取最新的元数据信息。

对于新增字段的情况,停掉Flink作业并重新启动是一种可行的方法,但可能会对生产环境造成影响。为了避免这种情况,可以考虑使用Flink的版本控制功能,将作业状态和元数据信息保存在外部存储中,例如Apache Kafka或HBase等。这样在恢复时可以读取最新的元数据信息并应用状态更新,而无需停止Flink作业。

此外,Flink CDC还提供了其他一些功能和配置选项,可以根据具体情况进行优化和调整。建议参考Flink官方文档或相关社区资源,了解更多关于Flink CDC的详细信息和最佳实践。https://help.aliyun.com/zh/flink/developer-reference/apache-kafka-connector?spm=a2c4g.11186623.0.i15

您好,理解您的问题是Flink CDC在做savepoint或者checkpoint恢复时,是否可以重新读取下元数据,以便捕获之前未捕获的字段。

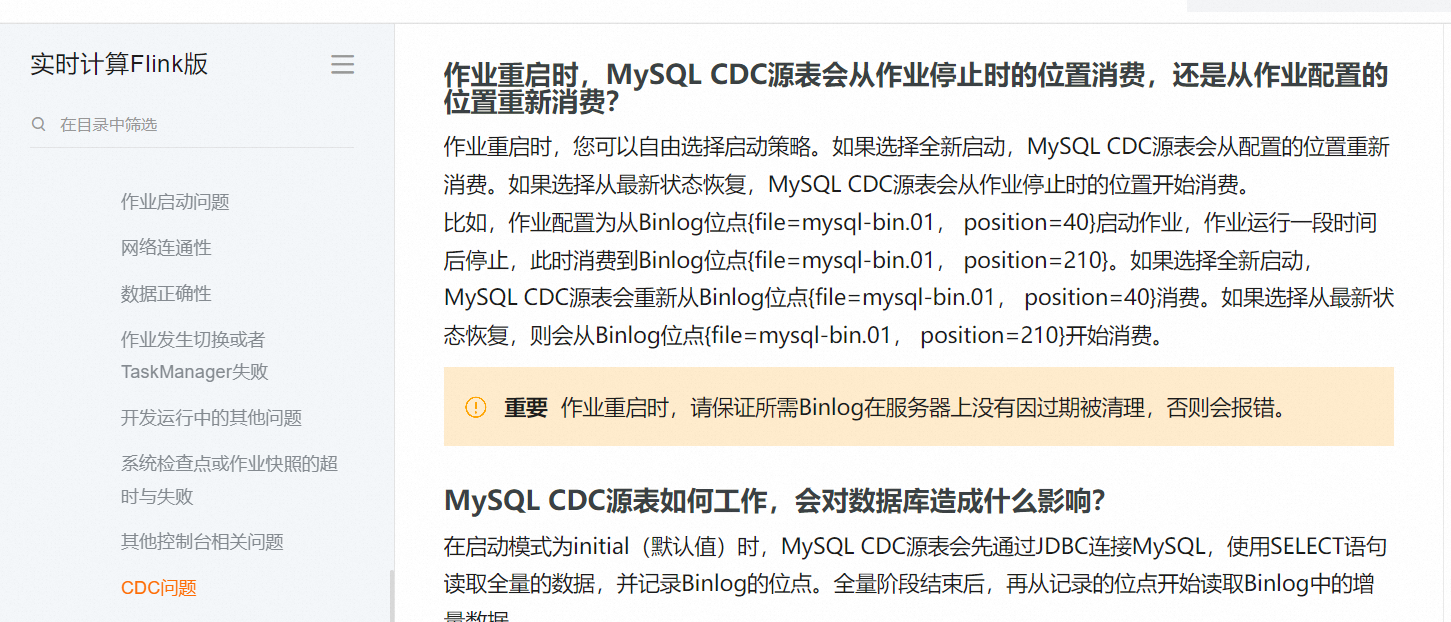

Flink CDC目前不支持在做savepoint和checkpoint恢复时重新读取元数据。原因有以下几点:

Flink CDC在从savepoint或者checkpoint恢复时,默认是不会重新读取元数据(如表结构等信息)的。

所以在这种情况下,需要手动对Flink CDC任务进行一些操作:

停止任务,清理状态数据(savepoint/checkpoint)

元数据存储系统(如Metastore)里对表结构信息进行更新

重新启动任务

Flink CDC可以在从sp或cp恢复时重新读取元数据,这样新增字段时只需要停掉Flink CDC,然后再接上scn即可。具体操作步骤如下:

在 Flink CDC 中,当源数据库发生变化(例如新增字段)时,可以通过停止 CDC Job 并重新读取元数据来适应这些变化。以下是一种可能的流程:

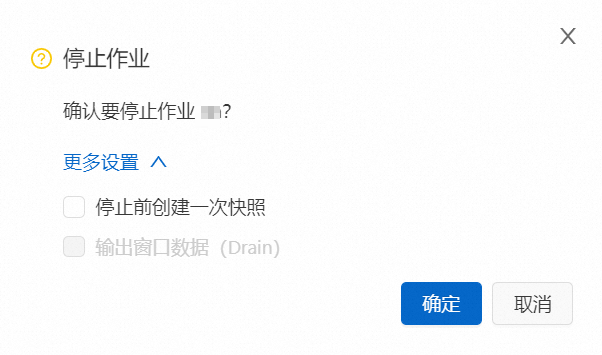

停止 CDC Job:首先,停止正在运行的 CDC Job,以确保不会发生数据丢失或重复。

重新读取元数据:在停止的状态下,Flink CDC 可以重新读取源数据库的元数据信息,包括表结构和其他相关信息。这将获取到最新的元数据信息,包括新增的字段。

更新 CDC Job 配置:根据更新后的元数据信息,您需要相应地更新 CDC Job 的配置,以适应新增的字段。这可以涉及到修改 Avro 或 JSON Schema、重新映射字段等操作,确保 CDC Job 能够正确处理新增的字段。

重新启动 CDC Job:完成配置更新后,您可以重新启动 CDC Job,并开始使用更新后的配置继续捕获和处理源数据库中的变化数据。

Flink CDC在从savepoint或者checkpoint恢复时,默认是不会重新读取元数据(如表结构等信息)的。

它会直接从之前保存的状态信息里恢复,比如保存的watermark位置等。

如果在恢复过程中,源表结构有变更(如新增字段),这时会有一些问题:

CDCSink的表结构信息不会更新,无法处理新增的字段

程序可能会因为新老结构不匹配抛异常

所以在这种情况下,需要手动对Flink CDC任务进行一些操作:

停止任务,清理状态数据(savepoint/checkpoint)

元数据存储系统(如Metastore)里对表结构信息进行更新

重新启动任务

CDC任务从最新的SCN位置重新开始捕获变更数据

实际步骤可能需要根据不同的存储系统和部署环境做对应调整。

如果您想要在Flink CDC从sp或cp恢复时重新读取元数据,可以通过以下方式进行:

在Flink CDC的配置文件中,指定snapshot参数为true,以启用Flink CDC的快照功能。这样,Flink CDC在启动时会读取数据源表的元数据,并将其存储在内存中。

在Flink CDC的配置文件中,指定recovery参数为true,以启用Flink CDC的恢复功能。这样,Flink CDC在启动时会从上一次启动时存储在内存中的元数据中恢复。

在Flink CDC的配置文件中,指定snapshot和recovery参数为true,以启用Flink CDC的快照和恢复功能。这样,Flink CDC在启动时会读取数据源表的元数据,并将其存储在内存中,同时也会从上一次启动时存储在内存中的元数据中恢复。

需要注意的是,如果您在生产环境中使用Flink CDC,那么您需要考虑Flink CDC的资源使用情况。例如,您需要确保Flink CDC有足够的内存和CPU资源,以保证数据处理和同步的效率和稳定性。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

在 Flink CDC 中,从 Savepoint(sp)或者 Checkpoint(cp)恢复时重新读取元数据,以处理新增字段的情况是可行的。

当您使用 Savepoint 或者 Checkpoint 恢复 Flink CDC 时,它会从存储的状态中恢复应用程序的状态,包括元数据信息。如果在恢复期间发现新增字段,您可以采取以下步骤来处理:

停止 Flink CDC:首先停止正在运行的 Flink CDC 应用程序,以便进行后续的元数据更新。

更新元数据:在停止的状态下,您可以通过修改元数据配置文件或其他适合的方式,将新增字段的元数据信息添加到相应的位置。这样,当 Flink CDC 再次启动时,它将会加载更新后的元数据,并能够正确处理新增字段。

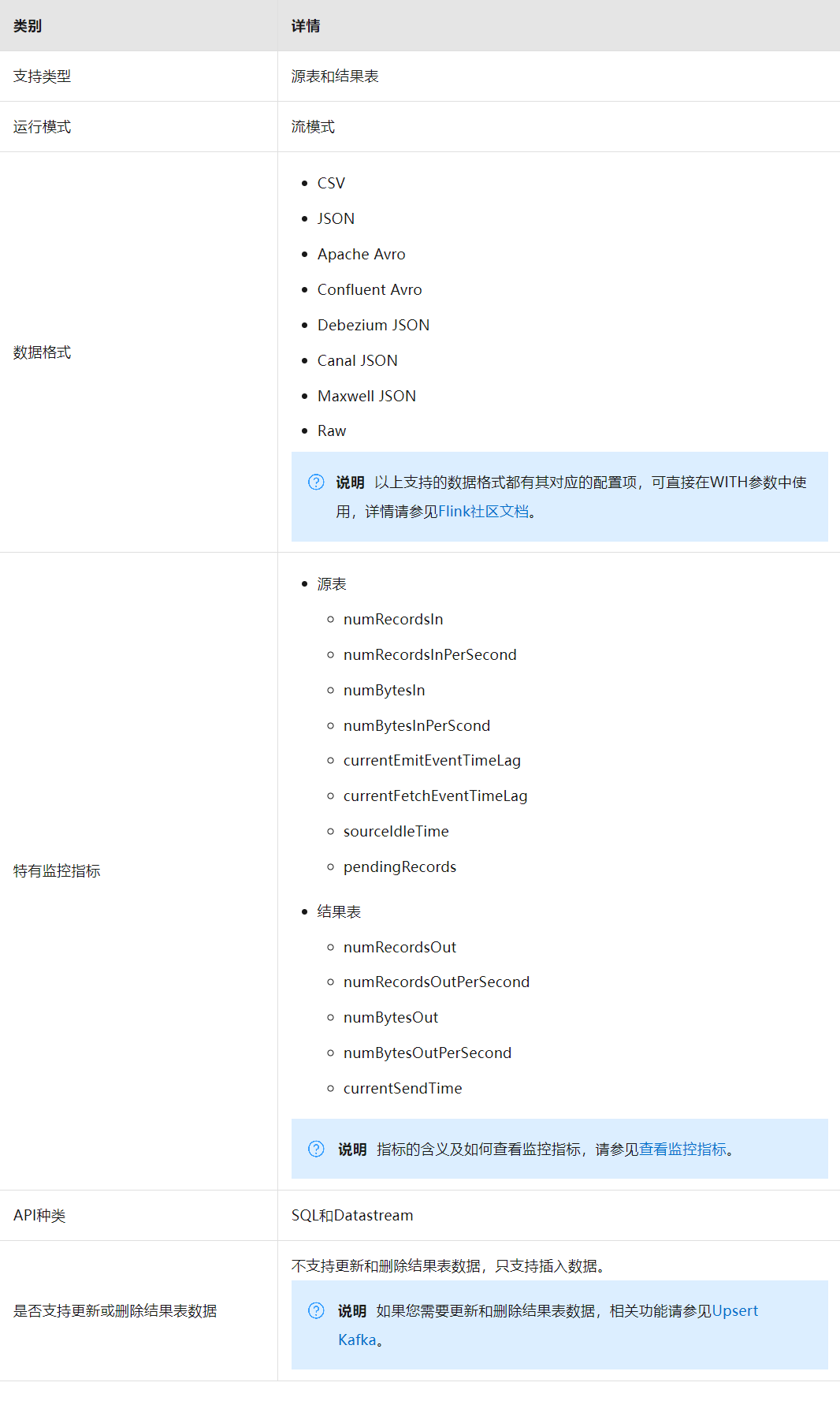

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。