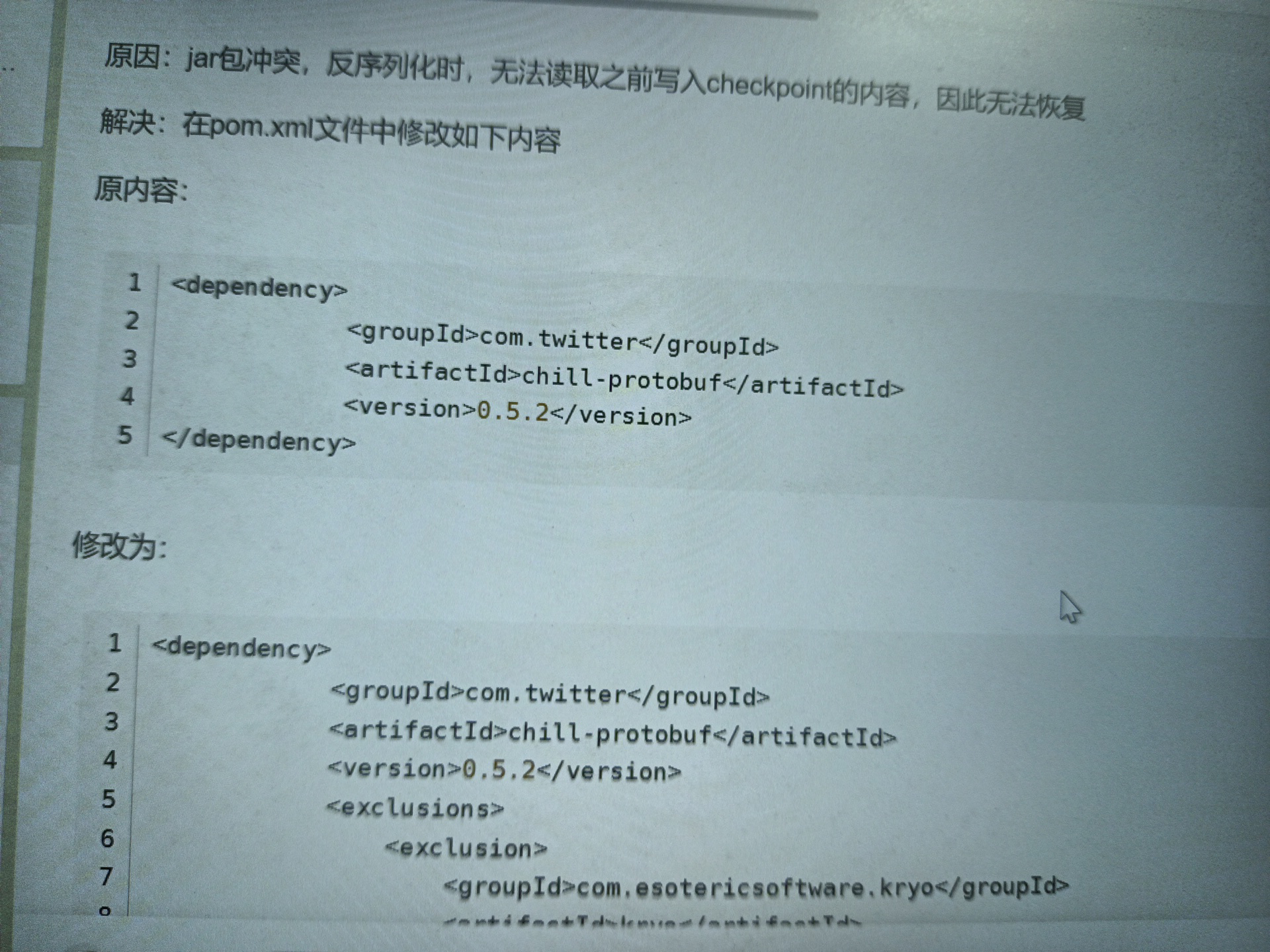

请问Flink CDC这个是什么原因啊?我在网上看是说jar包冲突

我是flinkcdc方式,在client提交的,这个在什么地方加上这个配置啊,有谁知道吗

我是flinkcdc方式,在client提交的,这个在什么地方加上这个配置啊,有谁知道吗

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

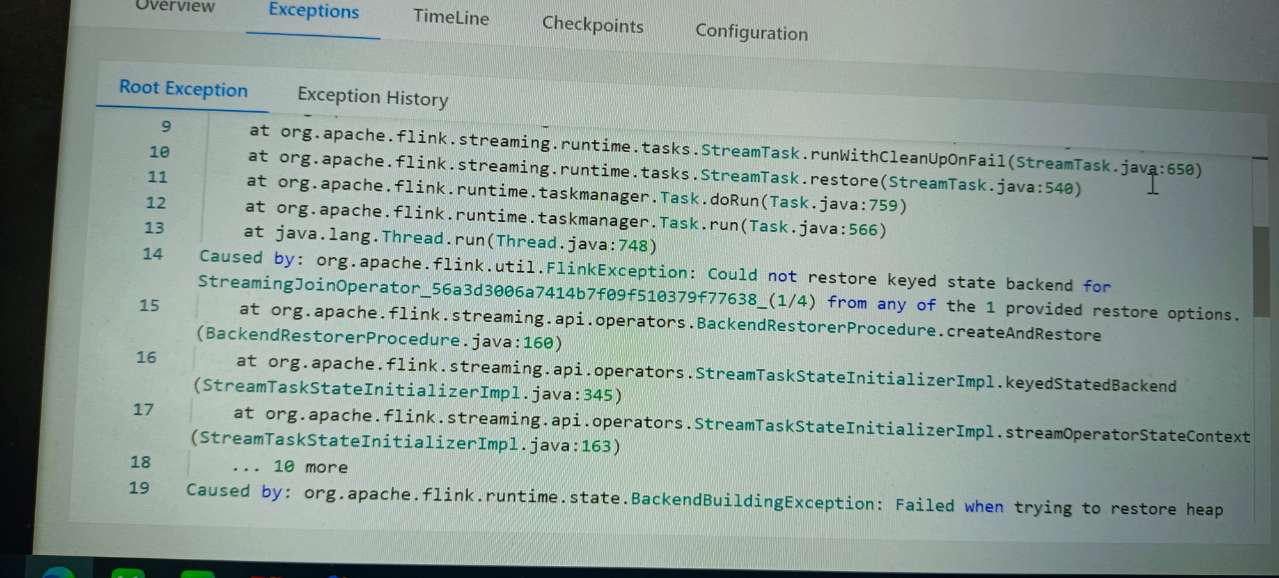

根据给出的堆栈跟踪信息,该错误是由于无法从提供的恢复选项中恢复StreamingJoinOperator的键控状态后端引起的。这可能是由于以下原因之一导致的:

1、恢复选项未正确配置:请确保在代码中正确配置了用于恢复的选项。您可以检查是否提供了正确的状态后端配置,并且有足够的资源来执行恢复操作。

2、状态后端目录不可访问:检查配置的状态后端目录是否存在并且具有适当的权限。如果目录不可访问,则可能导致无法恢复状态。

3、状态后端目录中没有可用的检查点:如果没有可用的检查点文件或检查点文件已损坏,则无法恢复状态。您可以检查状态后端目录中是否存在有效的检查点文件。

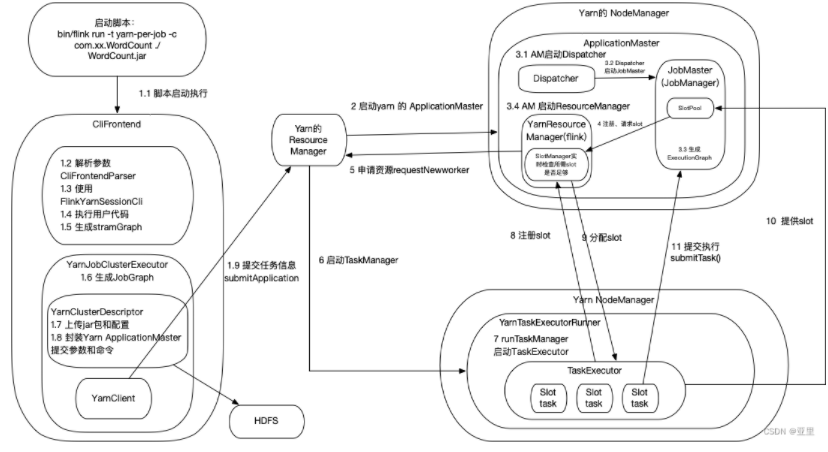

楼主你好,阿里云Flink CDC是阿里云在Flink基础之上推出的一种解决数据实时同步问题的解决方案,其实现原理是通过Flink CDC工具来实现的。

在使用Flink CDC进行数据同步时,出现阿里云Flink CDC失败的可能原因有很多,除了jar包冲突外,可能还包括网络不稳定、权限不足等问题。如果要解决这个问题,需要根据具体情况进行分析和排查。

关于在何处加上阿里云Flink CDC配置,具体实现方式可能因不同情况而异。一般来说,可以在Flink配置文件或命令行参数中进行配置。

根据报错信息,出现了一个 FlinkException,提示无法为 "StreamingJoinoperator56a3d3806a7414b7f99f510379f77638(1/4)" 恢复键控状态后端。

要解决这个问题,您可以尝试以下步骤:

flink-conf.yaml)中的相关配置正确无误。特别是与 Flink CDC 相关的配置,例如 state.backend 和 state.checkpointing。确保这些配置与您的 Flink 版本和环境兼容。Flink CDC 是一种基于 Apache Flink 的 Change Data Capture(数据变更捕获)工具,用于实时捕获和处理数据源中的变更事件。它可以连接到各种数据源(如数据库)并捕获变更日志,然后将这些变更应用到 Flink 流处理任务中进行实时处理和分析。

关于您提到的 jar 包冲突问题,这是一种常见的问题,可能会导致程序运行时出现异常或无法正常工作。

当您在使用 Flink CDC 时,可能会依赖于一些第三方库或组件,例如数据库驱动程序等。如果您的应用程序中使用的库与 Flink CDC 或其他依赖库使用的库存在版本冲突,就会发生 jar 包冲突。

jar 包冲突可能会导致以下问题:

类冲突:不同版本的同一个类在运行时发生冲突,导致类加载错误或无法找到所需的类。

方法冲突:不同版本的同一个方法在运行时发生冲突,导致方法调用错误或行为异常。

依赖关系冲突:应用程序依赖的库与 Flink CDC 或其他库的依赖关系冲突,导致无法正确加载或初始化依赖的库。

为了解决 jar 包冲突问题,您可以考虑以下几个步骤:

检查依赖版本:仔细检查您的应用程序和 Flink CDC 使用的依赖库,并确保它们的版本兼容。查看官方文档或相关资源,了解所使用库的兼容性要求和建议版本。

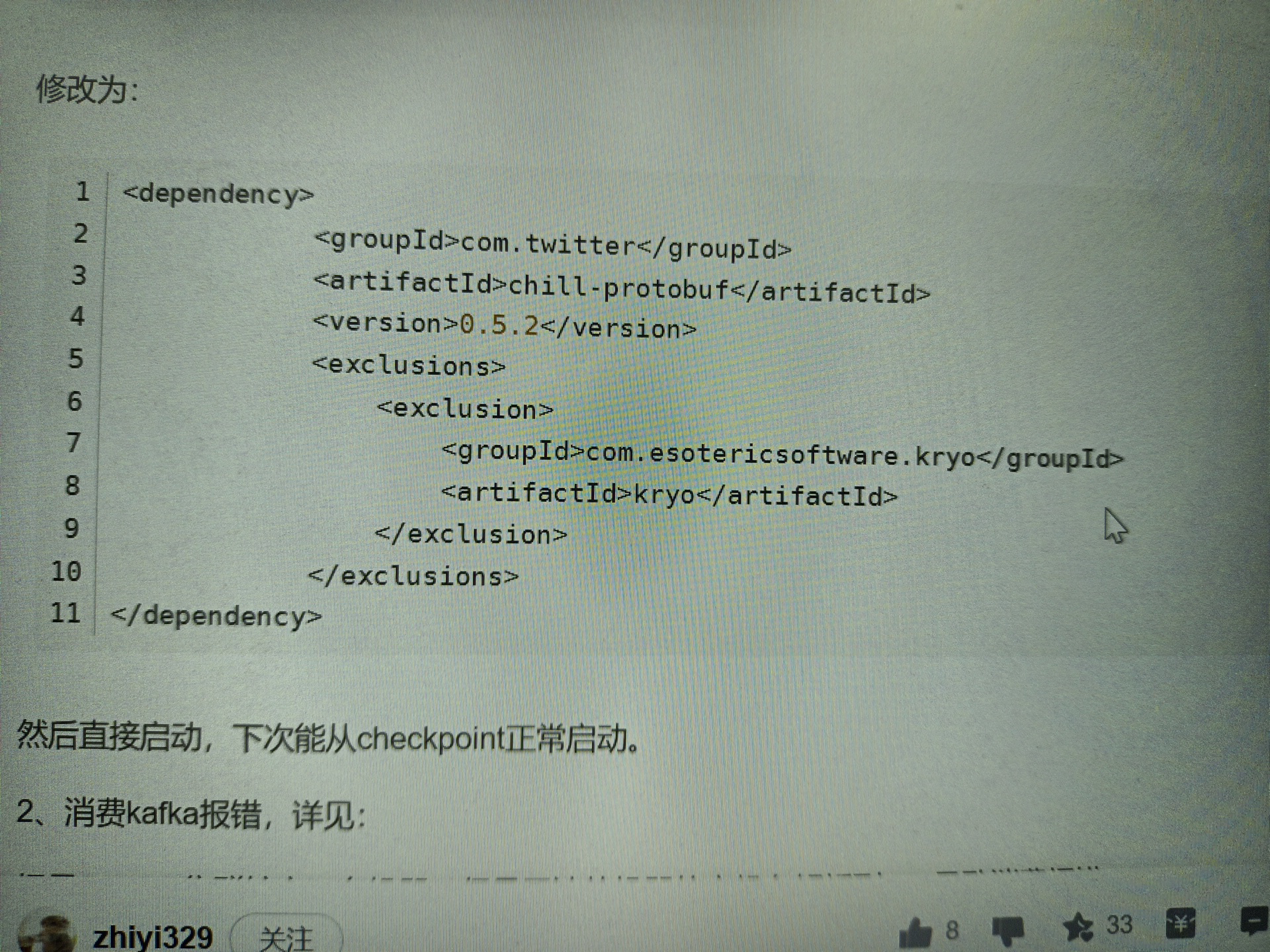

排除冲突的依赖:如果发现特定的依赖库引起了冲突,您可以尝试在应用程序的构建配置中排除该依赖,或者使用更具体的版本规范来避免冲突。

重新打包或重新编译:在某些情况下,您可能需要重新打包或重新编译您的应用程序,以确保正确的依赖库被包含,并且不存在与 Flink CDC 或其他库冲突的版本。

使用类加载器隔离:您可以考虑使用类加载器隔离的技术,如使用不同的类加载器加载不同的依赖库,以避免冲突。

如果您在使用Flink CDC时遇到了jar包冲突的问题,那么您可以尝试在Flink CDC的配置文件中,指定classpath参数和cluster参数,以指定Flink CDC的jar包路径和集群信息。具体来说,您可以在classpath参数中,指定Flink CDC的jar包路径,以便Flink CDC能够正确加载和使用jar包。同时,您还可以在cluster参数中,指定Flink CDC的集群信息,以便Flink CDC能够正确地启动和运行。

需要注意的是,如果您在生产环境中使用Flink CDC同步数据,那么您需要考虑Flink CDC的资源使用情况。例如,您需要确保Flink CDC有足够的内存和CPU资源,以保证数据处理和同步的效率和稳定性。同时,您还需要确保Flink CDC的数据备份和恢复机制,以保证数据的安全性和可靠性。

关于Flink CDI jar包冲突的问题。这个问题可能是由于你的Flink安装中存在多个版本的相同依赖项所导致的。你可以尝试以下步骤来解决这个问题:

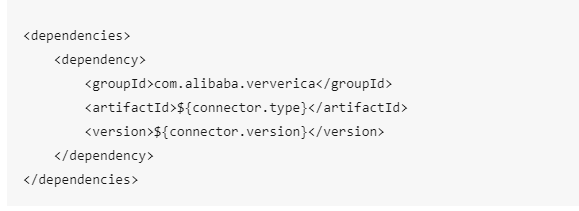

首先,检查你的Flink安装中是否有重复的依赖项。你可以通过查看pom.xml文件或者使用类似于mvn dependency:tree的命令行工具来完成这个检查。如果有重复的依赖项,请尝试删除其中一个版本较低的依赖项。

如果上述方法无法解决问题,你可以尝试在pom.xml文件中添加<version>标签,指定你想要使用的依赖项的具体版本号。这样可以防止Maven自动选择默认版本。

最后,如果你仍然无法解决问题,可以尝试重新启动你的Flink集群,看看是否解决了jar包冲突的问题。