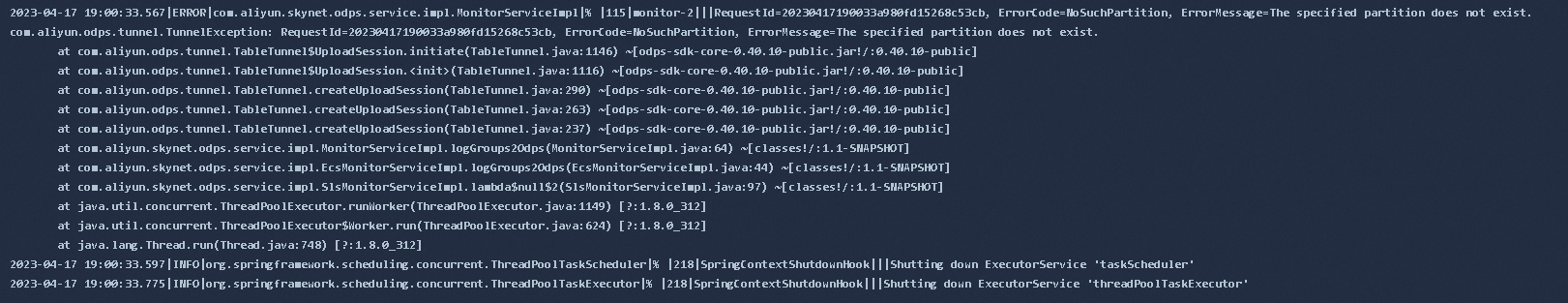

MaxCompute中请问这个怎么处理呀?SDK上传数据到分区表

MaxCompute中请问这个怎么处理呀?SDK上传数据到分区表

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在阿里云MaxCompute中,如果使用SDK上传数据到分区表时出现"The specified partition does not exist"的错误提示,可能是因为您上传的数据所对应的分区不存在。此时,您可以按照以下步骤进行处理:

确认分区是否存在:您可以通过MaxCompute客户端或者DataWorks控制台等工具查询目标分区是否存在。如果分区不存在,则需要先创建分区。

创建分区:如果目标分区不存在,您可以使用MaxCompute客户端或者DataWorks控制台等工具创建分区。具体方法如下:

使用MaxCompute客户端创建分区:

ALTER TABLE table_name ADD IF NOT EXISTS PARTITION (partition_column='partition_value');

其中,table_name为目标表名;partition_column为分区列名;partition_value为分区值。执行该命令后,如果分区不存在,则会自动创建分区。

使用DataWorks控制台创建分区:

在DataWorks控制台中,找到目标表并进入表详情页。在“分区信息”栏中,点击“新增分区”按钮,填写分区信息并保存即可。

重新上传数据:在确认目标分区已经存在或者创建成功后,您可以重新使用SDK上传数据到分区表。此时,应该不会再出现"The specified partition does not exist"的错误提示了。

这个错误提示表明指定分区不存在,你可以按照以下方式进行处理:

确认存在该分区:在MaxCompute控制台或者命令行中查看表的分区情况,确认指定的分区是否存在。

检查分区格式:检查你指定的分区格式是否与表定义中的一致。

使用正确的分区字段:在上传数据时,要确保使用正确的分区字段,同时对应的值也必须填写正确。

创建分区:如果你要上传的分区确实不存在,可以通过MaxCompute控制台或者命令行手动创建分区。

这个错误通常是由于分区不存在或者分区信息填写不正确所导致的,你需要检查相关配置和数据,并按照以上方式进行处理。

在 MaxCompute 中,您可以使用 MaxCompute Java SDK 来将数据上传到分区表中。下面是一个示例 Java 代码:

import com.aliyun.odps.Column;

import com.aliyun.odps.Odps;

import com.aliyun.odps.OdpsException;

import com.aliyun.odps.PartitionSpec;

import com.aliyun.odps.TableSchema;

import com.aliyun.odps.account.Account;

import com.aliyun.odps.account.AliyunAccount;

import com.aliyun.odps.data.Record;

import com.aliyun.odps.data.RecordWriter;

import com.aliyun.odps.tunnel.TableTunnel;

import com.aliyun.odps.tunnel.TableTunnel.UploadSession;

import com.aliyun.odps.tunnel.TunnelException;

import java.io.IOException;

public class ODPSUploadPartitionData {

public static void uploadPartitionData() {

// 连接 ODPS

Account account = new AliyunAccount("<your_access_id>", "<your_access_key>");

Odps odps = new Odps(account);

odps.setEndpoint("http://service.odps.aliyun.com/api");

odps.setDefaultProject("<your_project>");

// 设置分区表和分区信息

String tableName = "<your_table>";

PartitionSpec partitionSpec = new PartitionSpec("<your_partition_key>", "<your_partition_value>");

// 创建上传会话

TableTunnel tunnel = new TableTunnel(odps);

UploadSession uploadSession = null;

try {

uploadSession = tunnel.createUploadSession(odps.getDefaultProject(), tableName, partitionSpec);

} catch (TunnelException e) {

e.printStackTrace();

}

// 获取记录写入器

RecordWriter recordWriter = uploadSession.openRecordWriter(0);

// 写入数据

Record record = uploadSession.newRecord();

record.set(0, "data1");

record.set(1, "data2");

recordWriter.write(record);

// 关闭记录写入器

try {

recordWriter.close();

} catch (IOException e) {

e.printStackTrace();

} catch (TunnelException e) {

e.printStackTrace();

}

// 关闭上传会话

try {

uploadSession.commit(new Long[]{0});

} catch (TunnelException e) {

e.printStackTrace();

}

}

}

在代码中,我们首先通过 Odps 对象连接到 MaxCompute 服务,然后设置分区表和分区信息,创建上传会话,获取记录写入器并写入数据,最后关闭记录写入器和上传会话。

需要注意的是,SDK 上传数据到分区表时,需要先创建上传会话,并通过记录写入器向分区表中写入数据。在写入数据之后,需要关闭记录写入器,并通过提交上传会话完成数据上传操作。

总之,在 MaxCompute 中,使用 Java SDK 上传数据到分区表可以方便地实现数据的导入,提高数据导入的效率和性能。

在MaxCompute中,使用SDK上传数据到分区表可以按照以下步骤进行处理:

准备数据:首先,确保你的数据已经准备好并符合MaxCompute的表结构要求。你可以将数据存储在本地文件系统或其他存储介质中。

初始化MaxCompute SDK:使用相应的编程语言(如Java、Python等)初始化MaxCompute SDK。这通常包括设置访问密钥、项目名称、运行地域等必要的配置。

创建表对象:使用SDK创建一个MaxCompute表对象,指定要上传数据的目标表和分区信息。

读取数据文件:使用SDK读取准备好的数据文件。具体的方法会根据SDK和编程语言的不同而有所差异。

上传数据:将读取到的数据通过SDK上传到MaxCompute的分区表中。上传数据的方法也会因SDK和编程语言的不同而有所不同。

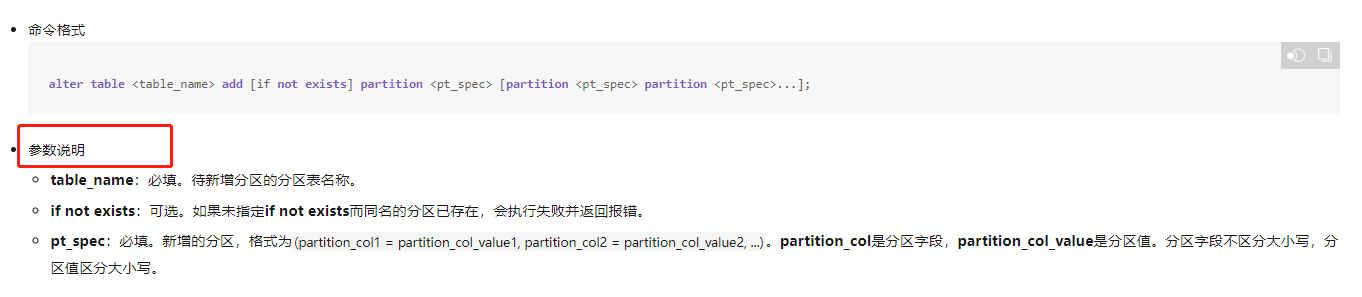

你好,根据错误提示来看的话是在执行TableTunnel进行表数据(非视图)的上传和下载时提示分区不存在,那么这就需要先对表创建分区,创建分区的操作

alter table <table_name> add [if not exists] partition <pt_spec> [partition <pt_spec> partition <pt_spec>...];

需要注意的是: 1.MaxCompute单表支持的分区数量上限为6万个。 2.对于有多级分区的表,如果需要添加新的分区值,必须指明全部的分区。 3.仅支持新增分区值,不支持新增分区字段。 另外创建分区的参数说明如下

在MaxCompute中,向分区表中上传数据可以使用MaxCompute SDK中TableTunnel类实现。具体步骤如下:

首先,需要在代码中引入MaxCompute SDK库:

import com.aliyun.odps.Odps;

import com.aliyun.odps.TableSchema;

import com.aliyun.odps.account.Account;

import com.aliyun.odps.account.AliyunAccount;

import com.aliyun.odps.data.Record;

import com.aliyun.odps.data.RecordWriter;

import com.aliyun.odps.tunnel.TableTunnel;

import com.aliyun.odps.tunnel.TableTunnel.UploadSession;

import com.aliyun.odps.tunnel.TableTunnel.UploadStatus;

然后,需要创建MaxCompute SDK的Odps实例,并对其进行账号认证:

Account account = new AliyunAccount(accessId, accessKey);

Odps odps = new Odps(account);

odps.setEndpoint("http://service.odps.aliyun.com/api");

odps.setDefaultProject("my_project");

其中,accessId 和 accessKey 是您的MaxCompute访问凭证。

然后,需要创建TableTunnel实例,并使用该实例进行数据上传:

TableTunnel tunnel = new TableTunnel(odps);

String tableName = "my_table";

String partitionSpec = "pt='20220518'";

TableSchema schema = tunnel.getTableMeta("my_project", tableName).getSchema();

UploadSession uploadSession = tunnel.createUploadSession("my_project", tableName, partitionSpec);

RecordWriter recordWriter = uploadSession.openRecordWriter(0);

Record record = uploadSession.newRecord();

record.set(0, "my_field_1_value");

record.set(1, "my_field_2_value");

recordWriter.write(record);

recordWriter.close();

上述代码中,需要将 my_table 替换为您要上传数据的目标表名,pt='20220518' 替换为您要上传数据的分区列的值。

数据写入时,先使用 Record 对象填充一行数据,然后将该行数据交给 RecordWriter 进行写入。最后,关闭 RecordWriter 对象即可。

需要注意的是,在分区表中上传数据时,必须指定分区列的值,否则数据将被上传到整个表中,而不是目标分区。

另外,如果要批量上传数据,可以使用 createBlockUploadSession() 方法创建BlockUploadSession对象,实现数据块的上传。

NoSuchPartition错误通常是由于上传数据时指定的分区不存在导致的。在上传数据到分区表时,需要确保指定的分区已经存在,否则会出现NoSuchPartition。

解决方法如下:

一、 确认分区是否存在:在上传数据之前,您需要确认指定的分区是否已经存在。您可以如下命令来查看分区列表:

show partitions table_name;

如果指定的分区不存在,您需要先创建分区,然后再上传数据。

二、 检查分区名称:在上传数据时,需要确保指定的分区名称与表定义中的分区名称一致。如果分区名称不一致,会导致NoSuchPartition错误。

三、 检查分区值:在上传数据时,需要确保指定的分区值与表定义中的分区值致。如果分区值不一致,也会导致NoSuchPartition错误。

四、 检查权限:如果您没有足够的权限来访问指定的分区,也会导致NoSuchPartition错误。在这种情况下您需要联系管理员来获取相应的权限。

需要注意的是,如果您在上传数据时指定了多个分区,需要确保所有的分区已经存在,并且分区名称和分区值都正确。如果您仍然无法解决NoSuchPartition错误,请检查您的代码和日志,以确定问题的具体原因。

在MaxCompute中,如果尝试向分区表上传数据到不存在的分区,就会出现上述错误消息。如果您遇到这种情况,可以按照以下步骤进行处理:

确认分区是否存在:首先需要确认要上传的分区是否已经存在。可以使用ODPS SQL命令或者DataWorks等可视化工具查看分区的情况。

创建分区:如果要上传的分区不存在,需要先创建分区。可以使用ODPS SQL命令或者DataWorks等可视化工具创建分区。

上传数据:在确认分区存在的情况下,可以使用Java SDK上传数据到分区表。在上传数据时,需要指定要上传的分区信息,例如:

Odps odps = new Odps(account);

odps.setDefaultProject("project_name");

TableTunnel tunnel = new TableTunnel(odps);

PartitionSpec partitionSpec = new PartitionSpec();

partitionSpec.set("partition_col1", "partition_value1");

partitionSpec.set("partition_col2", "partition_value2");

TunnelUploadSession uploadSession = tunnel.createUploadSession("table_name", partitionSpec);

TunnelRecordWriter writer = uploadSession.getWriter();

// 上传数据

...

writer.write(record);

...

writer.close();

以上代码中,PartitionSpec用于指定上传数据的分区信息。在创建TunnelUploadSession时,需要指定要上传的表名和分区信息,然后通过getWriter方法获取TunnelRecordWriter对象,使用write方法上传数据。最后需要调用close方法关闭TunnelRecordWriter对象。

在MaxCompute中,您可以使用MaxCompute SDK上传数据到分区表。以下是一些基本步骤:

首先,您需要创建一个要写入的MaxCompute表,并在其中制定一个或多个分区。

接下来,您需要准备好要写入表格的数据。这可能涉及从文件、Hive表等源读取数据,或者生成/处理数据。

然后,您可以使用MaxCompute SDK的TableWriter类将数据写入表格。分别指定每个数据行和它所属的分区,以确保数据被正确地写入表格。

最后,您需要提交作业以启动数据写入过程。

这只是一个简单的概述,具体实现方式还需要根据实际情况进行调整。如果您需要更详细的说明,请参阅MaxCompute官方文档或咨询MaxCompute技术支持团队。

在MaxCompute中上传数据到分区表,需要使用MaxCompute SDK中提供的TableTunnel API。以下是一个示例代码:

from odps import ODPS from odps.tunnel import TableTunnel

odps = ODPS('', '', '', endpoint='')

tunnel = TableTunnel(odps)

partition_spec = odps.PartitionSpec(partition='dt=20220101')

table = odps.get_table('my_table')

with open('data.csv', 'rb') as f: upload_id = tunnel.create_upload_session(table, partition_spec) with tunnel.open_upload_session(upload_id) as upload: upload.write(f.read()) python 在上述代码中,我们首先初始化了一个ODPS对象,然后使用该对象获取了TableTunnel对象。接着,我们设置了上传数据的分区信息,并获取了上传数据的表对象。最后,我们使用TableTunnel对象创建了上传数据的数据流对象,并将数据写入该对象中。

需要注意的是,在上传数据到分区表时,必须指定分区信息,否则数据将无法正确地写入到表中。

在MaxCompute中,可以使用SDK通过编程的方式上传数据到分区表。

准备数据:首先需要准备要上传的数据文件(如csv、txt等格式),将其保存至本地或OSS等存储环境中。

初始化MaxCompute SDK:为了在代码中使用MaxCompute SDK操作表格存储,需要先进行初始化,设置相应参数

根据错误信息提示,上传数据到分区表时出现了NoSuchPartition错误,即指定的分区不存在。这可能是因为在上传数据时指定的分区名称错误或者该分区已被删除。建议检查上传代码中指定的分区名称是否正确,或者尝试重新创建该分区。

同时,也可以查看MaxCompute控制台中的分区列表,确认该分区是否存在。如果分区已被删除,可以尝试重新创建该分区并重新上传数据。另外,还可以检查是否有其他进程或者应用在操作该分区,导致分区被锁定或者不可用。

创建分区表:首先,您需要在MaxCompute中创建一个分区表,并定义相应的列和分区信息。例如,以下是一个名为my_table的分区表的示例代码:

准备数据文件:接下来,您需要准备一份包含要上传数据的文本文件或者二进制文件,并按照分区信息进行命名和组织。例如,假设您有一份名为data.txt的文本文件,其中包含了要上传到分区表my_table中的数据:

使用SDK上传数据:最后,您可以使用ODPS SDK提供的API,通过Java代码上传数据到分区表

从错误表述看,是分区不存在

在MaxCompute中,您可以使用SDK上传数据到分区表,具体步骤如下:

Odps odps = new Odps(new AliyunAccount(accessId, accessKey));

odps.setEndpoint(endpoint);

odps.setDefaultProject(projectName);

TableTunnel tableTunnel = new TableTunnel(odps);

PartitionSpec partitionSpec = new PartitionSpec();

partitionSpec.set("partition_col1", "value1");

partitionSpec.set("partition_col2", "value2");

TableTunnel.UploadSession uploadSession = tableTunnel.createUploadSession(projectName, tableName, partitionSpec);

RecordWriter recordWriter = uploadSession.openRecordWriter(0);

// 循环将数据写入分区表

while (hasNextData()) {

List<Object> rowData = getNextData();

Record record = uploadSession.newRecord();

record.set(0, rowData.get(0));

record.set(1, rowData.get(1));

recordWriter.write(record);

}

recordWriter.close();

在上面的示例代码中,我们首先创建了一个ODPS对象,并设置相关参数。然后,我们使用TableTunnel获取目标分区表,并指定分区列和相应的分区值。接下来,我们创建一个上传会话并打开一条记录写入器。最后,我们循环读取数据,并将数据写入分区表中。

需要注意的是,在上传数据到分区表时,必须确保数据的格式与分区表的定义相匹配,否则可能会导致上传失败或者出现数据格式错误等问题。

希望这个回答对您有所帮助,如果您还有其他问题,请随时提出。

在MaxCompute(原ODPS)中使用SDK上传数据到分区表,需要按照以下步骤处理: 1. 准备分区表达式。根据分区表的分区表达式,计算每个数据条目对应的分区目录。例如,如果分区表达式为pt=date_format(logdate,'yyyy-mm-dd'),则需要计算每个logdate对应的数据上传到的分区目录。 2. 准备上传的数据。正常情况下,上传的数据文件格式为CSV或JSON等文本文件。如果数据体量较大,可以切分成多个文件上传。 3. 创建上传的Upload任务。使用MaxCompute SDK的UploadClient类创建Upload任务,需要指定上传的文件路径,上传的表名,分区信息等。 4. 添加上传文件。调用UploadClient的addFile方法添加需要上传的文件。如果有多个文件,重复调用addFile方法添加。 5. 提交上传任务。调用UploadClient的submitUploadTask提交上传任务。 6. 监控上传进度。调用UploadClient的getUploadProgress获取上传进度,可用于显示上传进度条等。 7. 处理上传完成。上传完成后,调用UploadClient的isSucceed方法检查上传是否成功。如果成功,数据即已上传至MaxCompute并根据分区表达式插入到对应的分区中。 示例代码如下:

在MaxCompute中,上传数据到分区表需要按照以下步骤进行:

CREATE TABLE partition_table(col1 STRING, col2 STRING, col3 STRING) PARTITIONED BY (dt STRING, region STRING);

ossutil mkdir oss://my-bucket/my-table/dt=20220101/region=cn-shanghai/

tunnel upload /path/to/local/file oss://my-bucket/my-table/dt=20220101/region=cn-shanghai/

或者

ossutil cp /path/to/local/file oss://my-bucket/my-table/dt=20220101/region=cn-shanghai/

需要注意的是,上传的数据文件名必须和分区表定义的分区列值匹配,例如,上述示例中的数据文件名称应该为“col1_col2_col3”,具体格式可以根据需求自定义。

ALTER TABLE partition_table ADD PARTITION (dt='20220101', region='cn-shanghai');

或者

ALTER TABLE partition_table ADD IF NOT EXISTS PARTITION (dt='20220101', region='cn-shanghai');

刷新分区表后,就可以使用SQL查询分区数据了。

需要注意的是,上传分区表数据时,还可以使用其他工具,例如DataWorks,或者通过编写MaxCompute的Java/Python SDK程序实现。

MaxCompute中上传数据到分区表,可以使用MaxCompute SDK来实现。具体步骤如下:

AliyunAccount设置账号信息,使用DefaultOSSCredentialProvider设置OSS访问凭证,使用DefaultAcsClient设置MaxCompute服务域名和Region信息,创建Odps对象连接MaxCompute服务。from odps import ODPS

from odps.account import AliyunAccount

from odps.credentials import DefaultOSSCredentialProvider

access_id = 'your_access_id'

access_key = 'your_access_key'

project_name = 'your_project_name'

end_point = 'your_endpoint'

region_name = 'your_region_name'

account = AliyunAccount(access_id, access_key)

odps = ODPS(account=account, project=project_name,

endpoint=end_point, region=region_name,

odps_config={'odps.cupid.resource.pool': 'your_resource_pool'})

create_table方法创建分区表,使用write_partition方法上传数据到指定分区。from odps.models import Schema, PartitionSpec

from odps.utils import to_binary

table_name = 'your_table_name'

partition_spec = PartitionSpec('your_partition_key=your_partition_value')

schema = Schema.from_json('your_json_schema')

table = odps.create_table(table_name, schema=schema, partition='your_partition_key string')

with table.open_writer(partition=partition_spec) as writer:

data = 'your_data'

row = list(to_binary(x) for x in data)

writer.write(row)

其中,Schema.from_json()的参数是JSON格式的Schema定义,用于描述表的结构和字段信息,例如:

schema_str = '{"columns":[{"name":"f1","type":"bigint"},{"name":"f2","type":"string"}],"partitionKeys":[{"name":"your_partition_key","type":"string"}]}'

schema = Schema.from_json(schema_str)

open_writer()方法返回一个用于写入数据的TableWriter对象,使用write()向表中写入一条数据,使用close()关闭TableWriter对象。

以上代码示例中,使用了PartitionSpec指定分区键和分区值,用于上传数据到指定分区。

通过使用MaxCompute SDK实现上传数据到分区表,可以方便地进行分区数据的管理和查询,并且支持高效的数据上传和处理。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。