2026年OpenClaw(原Clawdbot/Moltbot)作为轻量化、高扩展性的AI助手框架,其核心价值在于通过对接各类大模型API实现多样化的智能任务处理。阿里云百炼作为国内领先的大模型服务平台,提供了丰富的模型选择、稳定的接口性能和企业级安全保障,将OpenClaw与阿里云百炼API集成,能让OpenClaw具备更强的自然语言理解、内容生成和任务执行能力。本文基于2026年最新版本实测,从环境准备、OpenClaw部署、阿里云百炼API配置到功能验证,提供包含完整代码命令的保姆级教程,零基础用户也能零失误完成配置。

一、核心价值与前置条件

(一)OpenClaw+阿里云百炼API联动价值

- 能力全面升级:接入阿里云百炼API后,OpenClaw可调用通义千问、文心一言等主流大模型,实现智能问答、文案生成、数据分析、代码编写等复杂任务,摆脱内置轻量化模型的能力限制;

- 企业级稳定性:阿里云百炼提供99.9%的服务可用性,支持弹性扩缩容,满足OpenClaw在高并发场景下的API调用需求,避免第三方API频繁限流、中断的问题;

- 灵活的模型选择:阿里云百炼支持按场景选择不同模型(如对话型、生成型、推理型),OpenClaw可根据任务类型自动匹配最优模型,提升响应质量与效率;

- 数据安全合规:阿里云百炼符合国内数据安全法规,企业级用户可配置专属模型部署环境,确保OpenClaw处理的敏感数据不泄露。

(二)部署前置条件

- 阿里云账号:注册阿里云账号,完成企业/个人实名认证,拥有阿里云百炼服务开通权限、API密钥创建权限;

- OpenClaw部署环境:支持Linux(CentOS 9.x/Ubuntu 24.04)、Windows 11、Docker容器等环境(本文以Linux Docker环境为例);

- 基础工具:已安装Docker、Docker Compose,具备基础的命令行操作能力;

- 网络环境:可正常访问阿里云百炼API接口(企业内网需配置阿里云域名白名单)。

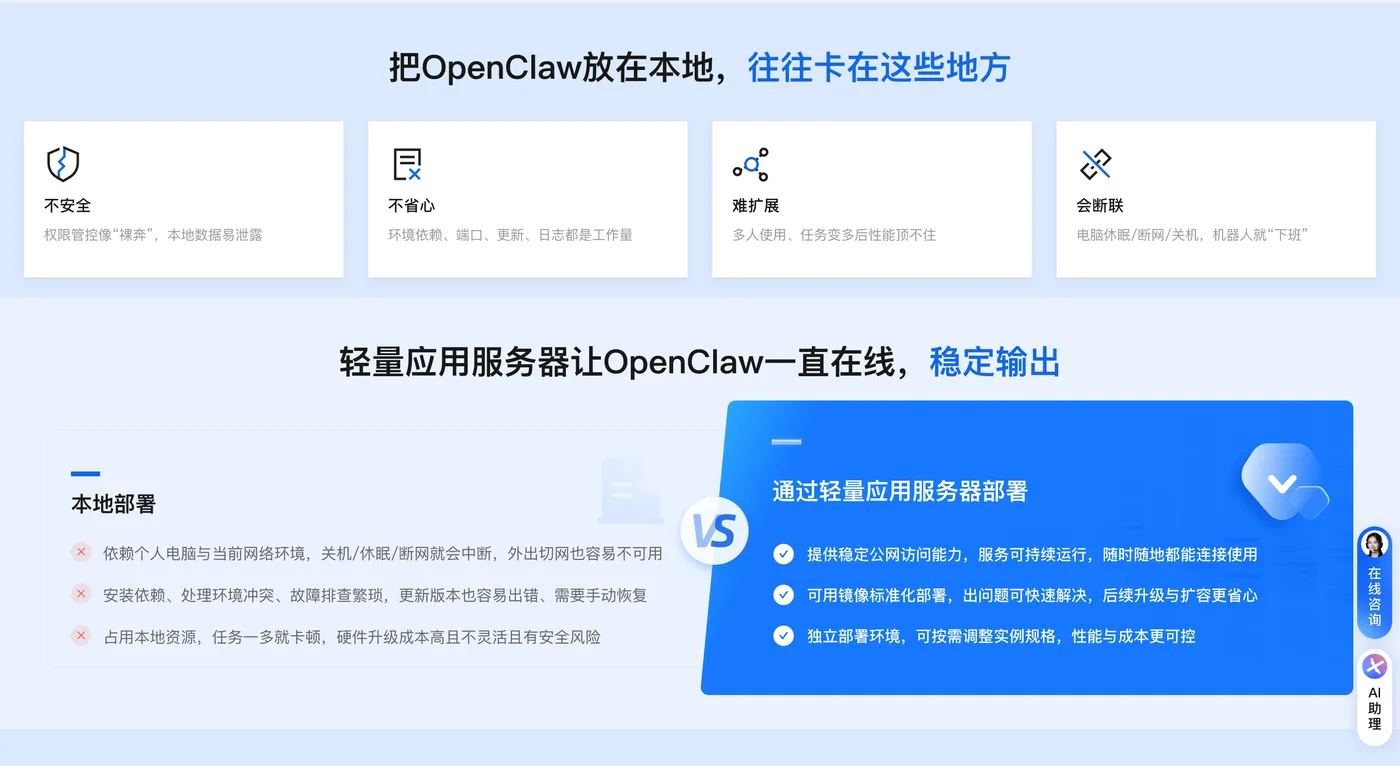

(三)一键部署OpenClaw

第一步:访问阿里云OpenClaw一键部署专题页面,找到并点击【一键购买并部署】

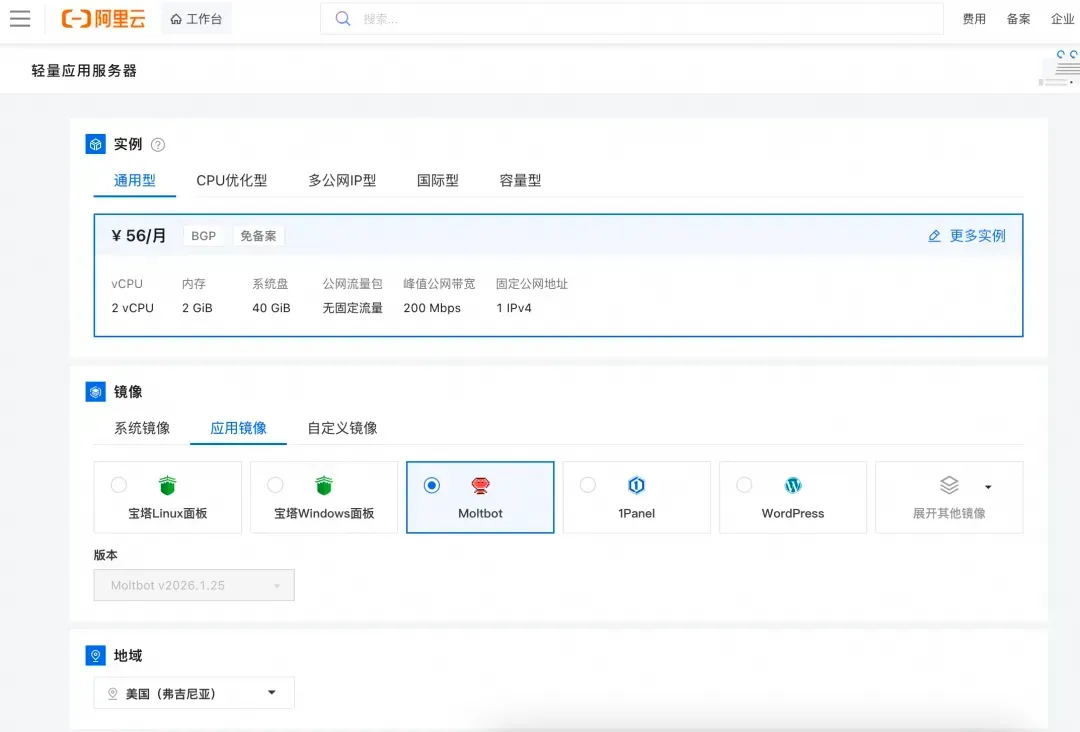

第二步:选购阿里云轻量应用服务器,配置参考如下:

- 镜像:OpenClaw(Moltbot)镜像(已经购买服务器的用户可以重置系统重新选择镜像)

- 实例:内存必须2GiB及以上。

- 地域:默认美国(弗吉尼亚),目前中国内地域(除香港)的轻量应用服务器,联网搜索功能受限。

- 时长:根据自己的需求及预算选择。

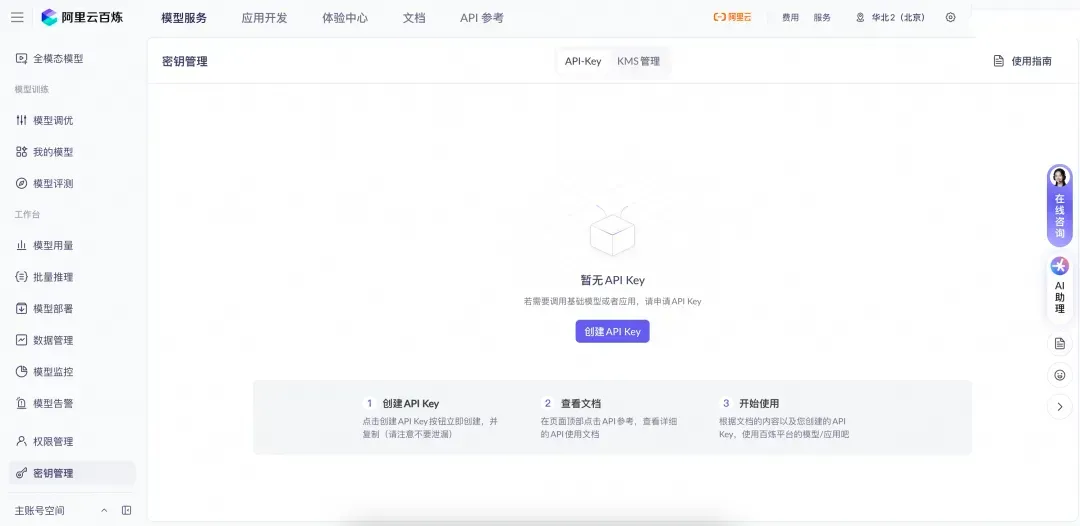

第三步:访问阿里云百炼大模型控制台,找到密钥管理,单击创建API-Key。

前往轻量应用服务器控制台,找到安装好OpenClaw的实例,进入「应用详情」放行18789端口、配置百炼API-Key、执行命令,生成访问OpenClaw的Token。

- 端口放通:需要放通对应端口的防火墙,单击一键放通即可。

- 配置百炼API-Key,单击一键配置,输入百炼的API-Key。单击执行命令,写入API-Key。

- 配置OpenClaw:单击执行命令,生成访问OpenClaw的Token。

- 访问控制页面:单击打开网站页面可进入OpenClaw对话页面。

二、前期准备:开通阿里云百炼并获取API密钥

(一)开通阿里云百炼服务

- 登录阿里云控制台,访问百炼大模型服务页面,进入产品页面后点击“立即开通”;

- 根据需求选择计费方式:个人测试可选“按量付费”,企业用户可选择“资源包套餐”;

- 完成服务开通后,进入“百炼工作台”,确认服务状态为“已开通”,并记录工作台访问地址。

(二)创建API密钥与配置权限

- 进入阿里云 “AccessKey管理页面”,点击“创建AccessKey”;

- 选择“子账号AccessKey”(推荐,避免主账号密钥泄露),为子账号授予“AliyunBailianFullAccess”(百炼全权限)或精细化权限(如“AliyunBailianReadOnlyAccess+AliyunBailianInvokeAccess”);

- 保存生成的AccessKey ID和AccessKey Secret(仅显示一次,务必妥善保管);

- 进入百炼工作台“API配置”模块,记录API端点地址(2026年默认端点:https://bailian.aliyuncs.com)和**模型版本ID**(如通义千问2.0的模型ID:qwen-turbo-2026)。

三、OpenClaw基础部署(Docker环境)

(一)部署环境准备(Linux)

# 1. 登录服务器(以CentOS 9.x为例)

ssh root@你的服务器IP

# 2. 更新系统依赖

yum update -y

# 3. 安装Docker与Docker Compose

yum install -y yum-utils device-mapper-persistent-data lvm2

yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

yum install -y docker-ce docker-ce-cli containerd.io

systemctl start docker

systemctl enable docker

# 安装Docker Compose

curl -L "https://github.com/docker/compose/releases/download/v2.26.0/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

chmod +x /usr/local/bin/docker-compose

# 验证安装

docker --version

docker-compose --version

# 4. 配置阿里云镜像加速(可选,提升OpenClaw镜像拉取速度)

mkdir -p /etc/docker

tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://你的阿里云镜像加速地址.mirror.aliyuncs.com"]

}

EOF

systemctl daemon-reload

systemctl restart docker

(二)OpenClaw容器化部署

# 1. 创建OpenClaw工作目录

mkdir -p /opt/openclaw && cd /opt/openclaw

# 2. 编写docker-compose.yml配置文件

tee docker-compose.yml <<-'EOF'

version: '3.8'

services:

openclaw:

image: openclaw/openclaw:2026-stable # 2026稳定版镜像

container_name: openclaw-core

restart: unless-stopped

ports:

- "3000:3000" # 管理后台端口

- "8080:8080" # API服务端口

environment:

- NODE_ENV=production

- PORT=3000

- LOG_LEVEL=info

volumes:

- ./config:/app/config # 配置文件持久化

- ./data:/app/data # 数据持久化

networks:

- openclaw-network

networks:

openclaw-network:

driver: bridge

EOF

# 3. 启动OpenClaw服务

docker-compose up -d

# 4. 验证部署结果

docker-compose logs # 无ERROR日志即为启动成功

curl http://localhost:3000/health # 输出{"status":"ok"}即为服务正常

(三)OpenClaw基础配置

- 访问

http://你的服务器IP:3000进入OpenClaw管理后台,首次登录默认账号:admin,密码:openclaw2026(务必立即修改); - 进入“系统设置”→“基础配置”,修改管理员密码、任务超时时间(建议设为60秒)、日志保留天数等核心参数;

- 进入“插件管理”,确认“大模型API连接器”插件已预装(2026版本默认集成)。

四、核心步骤:配置阿里云百炼API到OpenClaw

(一)方式1:命令行配置(适合技术人员)

# 1. 进入OpenClaw容器

docker exec -it openclaw-core /bin/bash

# 2. 进入API配置目录

cd /app/config

# 3. 创建阿里云百炼API配置文件

tee bailian-api-config.json <<-'EOF'

{

"provider": "aliyun-bailian",

"accessKeyId": "你的阿里云AccessKey ID",

"accessKeySecret": "你的阿里云AccessKey Secret",

"endpoint": "https://bailian.aliyuncs.com",

"modelId": "qwen-turbo-2026", # 通义千问2026轻量版(可替换为其他模型)

"temperature": 0.7, # 生成随机性(0-1,值越高越灵活)

"topP": 0.9, # 采样阈值

"maxTokens": 2000, # 最大生成字符数

"timeout": 30000, # API调用超时时间(毫秒)

"retryTimes": 3, # 失败重试次数

"enableCache": true # 开启缓存,避免重复调用API

}

EOF

# 4. 修改OpenClaw主配置文件,关联百炼API

vi app.js

# 在文件末尾添加以下配置

module.exports = {

// 原有配置...

llm: {

defaultProvider: "aliyun-bailian",

providers: {

"aliyun-bailian": require("./bailian-api-config.json")

}

}

};

# 5. 安装阿里云SDK依赖

cd /app

npm install @alicloud/bailian20230711 @alicloud/openapi-client @alicloud/tea-util --save

# 6. 退出容器并重启OpenClaw

exit

docker-compose restart

(二)方式2:可视化配置(新手友好)

- 进入OpenClaw管理后台,点击“集成中心”→“大模型API配置”;

- 选择“新增配置”,配置类型选择“阿里云百炼”;

- 依次填写以下信息:

- 配置名称:阿里云百炼-通义千问(自定义);

- AccessKey ID:填写阿里云创建的AccessKey ID;

- AccessKey Secret:填写阿里云AccessKey Secret;

- API端点:https://bailian.aliyuncs.com;

- 模型ID:qwen-turbo-2026(可从阿里云百炼工作台复制);

- 高级配置:温度(0.7)、最大令牌数(2000)、超时时间(30秒);

- 点击“测试连接”,提示“API连接成功”后保存配置;

- 进入“系统设置”→“全局配置”,将“默认大模型提供商”设置为刚创建的阿里云百炼配置,保存后生效。

(三)关键配置说明

| 配置项 | 作用 | 推荐值 |

|---|---|---|

| temperature | 控制生成内容的随机性,值越高越灵活,越低越精准 | 0.5-0.8(办公场景) |

| maxTokens | 限制单次API调用生成的最大字符数 | 1000-3000(根据任务调整) |

| enableCache | 开启后缓存重复请求结果,减少API调用次数 | true(测试/办公场景) |

| retryTimes | API调用失败后的重试次数 | 2-3次(避免网络波动导致失败) |

五、功能验证:测试阿里云百炼API调用

(一)命令行快速验证

# 1. 进入OpenClaw容器

docker exec -it openclaw-core /bin/bash

# 2. 执行测试脚本

cd /app

tee test-bailian-api.js <<-'EOF'

const OpenClaw = require('./core/OpenClaw');

const claw = new OpenClaw();

// 调用阿里云百炼API生成周报模板

async function testBailianAPI() {

try {

const result = await claw.llm.generate({

prompt: "帮我生成一份2026年Q1销售周报模板,包含销售额、客单价、复购率等核心指标",

provider: "aliyun-bailian"

});

console.log("API调用结果:\n", result.data.content);

} catch (error) {

console.error("调用失败:", error.message);

}

}

testBailianAPI();

EOF

# 3. 运行测试脚本

node test-bailian-api.js

若终端输出完整的销售周报模板内容,说明阿里云百炼API配置成功;若提示错误,优先检查AccessKey是否正确、阿里云百炼服务是否开通、网络是否能访问API端点。

(二)管理后台可视化验证

- 进入OpenClaw管理后台,点击“工具中心”→“AI指令测试”;

- 输入测试指令:“基于阿里云百炼API,分析近3个月的用户增长数据,生成一份可视化分析报告大纲”;

- 点击“执行”,等待10-20秒后,若页面显示完整的分析报告大纲,且无“API调用失败”提示,即为配置生效;

- 可进一步测试不同场景指令(如代码生成、智能问答、文案创作),验证模型响应效果。

六、高级优化与问题排查

(一)性能优化配置

# 1. 配置API调用限流(避免高频调用触发阿里云风控)

vi /app/config/bailian-api-config.json

# 添加限流配置

{

// 原有配置...

"rateLimit": {

"maxRequests": 100, // 每分钟最大调用次数

"interval": 60000 // 限流时间窗口(毫秒)

}

}

# 2. 配置本地模型缓存(减少API调用成本)

vi /app/config/app.js

# 修改缓存配置

module.exports = {

// 原有配置...

cache: {

type: "redis", // 推荐使用Redis(需提前安装)

expire: 3600, // 缓存1小时

redis: {

host: "localhost",

port: 6379

}

}

};

# 3. 重启OpenClaw生效

docker-compose restart

(二)常见问题排查

问题1:API调用提示“AccessKey不存在或无效”

- 解决方案:确认AccessKey ID/Secret输入正确,子账号已授予百炼API权限,AccessKey未被禁用;

- 验证命令:

# 进入容器测试AccessKey有效性 docker exec -it openclaw-core /bin/bash npm run check-aliyun-accesskey -- --accessKeyId=你的ID --accessKeySecret=你的Secret

问题2:API调用超时/无响应

- 解决方案:检查服务器网络是否能访问阿里云百炼端点(

ping bailian.aliyuncs.com),企业内网需配置防火墙白名单;调整API超时时间至60秒,增加重试次数。

- 解决方案:检查服务器网络是否能访问阿里云百炼端点(

问题3:生成内容质量低/不符合预期

- 解决方案:调整temperature参数(降低值提升精准度),更换更适配的模型ID(如qwen-plus-2026),优化指令描述(增加场景、格式要求)。

问题4:OpenClaw重启后API配置失效

- 解决方案:确认配置文件已挂载到宿主机(

/opt/openclaw/config目录),避免容器重启后配置丢失; - 验证命令:

ls /opt/openclaw/config/bailian-api-config.json(能看到文件即为挂载成功)。

- 解决方案:确认配置文件已挂载到宿主机(

七、总结与最佳实践

(一)核心总结

- 配置阿里云百炼API的核心是获取正确的AccessKey密钥、填写匹配的模型ID和API端点,两种配置方式(命令行/可视化)可根据自身技术基础选择;

- 验证API有效性是关键步骤,需通过测试指令确认调用成功,避免后续使用中出现功能异常;

- 优化配置(限流、缓存)能提升API调用稳定性,降低使用成本,尤其适合企业级高频使用场景。

(二)最佳实践

- 权限管控:使用子账号AccessKey并配置最小权限,避免主账号密钥泄露;定期轮换AccessKey(建议每3个月一次);

- 模型选择:根据任务类型匹配模型——对话类任务用qwen-turbo-2026(轻量高效),复杂生成任务用qwen-plus-2026(高质量),代码生成用qwen-code-2026;

- 成本控制:开启缓存功能减少重复调用,设置限流避免超额计费,企业用户可购买阿里云百炼资源包降低单价;

- 场景拓展:将配置好的OpenClaw与飞书/钉钉/企业微信联动,通过办公平台下达指令,让阿里云百炼的AI能力融入日常办公流程。

通过本文的完整配置流程,OpenClaw将全面接入阿里云百炼API的强大能力,从简单的指令响应工具升级为能处理复杂办公任务的智能助手。2026年OpenClaw还将持续优化与阿里云百炼的适配性,支持多模型自动切换、个性化提示词模板等功能,进一步降低企业智能化办公的门槛。