语音合成(TTS)技术正成为 AI 重点探索领域。比如在智能座舱场景下,用语音播报的形式来实现车主和大模型的语音交互;在儿童教育场景下,语音合成可以帮助小朋友用喜欢的声音轻松阅读故事。

CosyVoice 凭借在多语言生成、零样本生成等领域的优势,成为诸多企业客户选择;最新版本 CosyVoice2,更是在功能和性能上带来显著提升,与前代相比,CosyVoice2 在多语言语音生成、零样本语音生成、跨语言语音生成、富文本和自然语言细粒度控制方面表现出色,展现出强大竞争力。

然而,随着 AI 技术的深入发展,企业对 AI 场景多样化的需求日益增长,企业级规模化的语音生成应用仍面临 GPU 算力依赖和复杂部署运维的挑战,导致资源与人力成本居高不下。阿里云函数计算 Function AI 推出语音合成新模板,托管了 CosyVoice2.0 模型,让用户一键部署和拉起 CosyVoice2.0 模型,轻松实现 CosyVoice2.0 模型在业务场景的快速接入和落地。

传统语音合成场景的痛点

传统语音合成场景参数调节的不便

在语音合成场景下,对音频的要求相对较高。不仅要保证合成的音频的流畅度和完整性,也要保证音频的质量和灵活性,例如支持不同的音频格式,语速等等。对企业员工来说,调参是一个相对频繁的事情,因此需要一个简单的调试环境来支持高频率参数的调节。

模型的部署运维对企业的长期“阵痛”

要想让模型在业务中集成和落地,模型企业化成为了每个企业的必经之路。企业不仅需要考虑模型是否“能用”,更要考虑模型是否“好用”。所以,功能和性能成为了模型企业化进程中不可避免的问题。在语音合成的场景中,更多面对的是有语音合成诉求的 C 端用户,对延时和稳定都有很高的要求。因此,企业不仅需要先了解模型如何推理和调用,将模型顺利的部署起来,更要思考如何从容应对高并发的场景,并满足低延时的诉求。从前将模型部署在服务器上,由企业员工自行维护,随之而来的问题是,随着企业业务规模的不断扩张,服务器的即时扩容就成为了一大难题,无法应对突发的流量高峰。与此同时,服务器的运维也会变得耗时耗力。因此长期来看,模型在服务器上的部署和维护成为了企业的长期“阵痛”。

成本压力阻碍企业对 AI 语音合成场景的探索

由于 GPU 算力是语音合成模型的刚需,模型的执行效果又强依赖 GPU 的算力,算力越高,成本越昂贵,企业客户会选择购买 GPU 来长期提供算力。然而,在实际的业务场景中,并不需要持续消耗 GPU 算力,导致了资源利用率很低。因此,就会浪费不少成本。昂贵的算力资源给企业带来了不小的成本压力,也违背了当今经济环境下,企业客户对于降本的诉求。阻碍了企业在 AI 方向持续探索的脚步。

基于 Function AI 的 Serverless 化语音合成方案

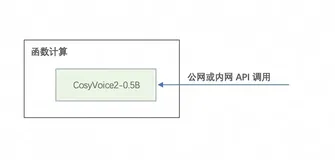

方案架构图

解放调试压力,实现业务的快速交付

阿里云函数计算提供了自定义编辑环境变量的能力,让用户可以自主变量调节。基于 Function AI 的语音合成 Serverless 化 API 可以通过 “speed, bit_rate, sample_rate” 等参数来调节音频的速度,音频质量和音频的采样率,同时支持原生 PCM,MP3 和 WAV 格式的音频,让用户能自由选择。也能和阿里云存储桶 OSS 集成,支持用户自主上传音色。这种方案,能让企业用户调试过程更简单,从而更关注业务,提高效率。

解放部署运维压力,更具长期性

基于阿里云函数计算打造的 Function AI 平台支持对 CosyVoice2.0 模型的一键部署,几分钟就能将 CosyVoice 模型迅速接入业务,解决了传统语音合成场景部署流程长,部署缓慢的痛点。

阿里云函数计算支持修改单实例并发度,并提供了强大的可观测能力,让用户可以根据观测到的指标结合自身业务情况,自定义单张GPU可承载的流量值。同时也提供了 GPU 的弹性能力,在流量峰值的时候实现秒级弹性,能够帮助企业用户从容应对突发的流量峰值。此外,对于要求低延时和高稳定性的用户,函数计算提供秒级快照和毫秒级快照,如果业务规模持续扩张,只需要在控制台上修改快照数量,即可轻松实现扩容,极大程度上降低了运维的复杂度和冗长的部署流程,让业务更具有长期性。

阿里云函数计算支持秒级快照,有请求的时候会快速启动快照,没有请求的时候保持闲置状态,只收取很少的 GPU 资源占用费。对于业务峰谷明显的企业用户,很大程度上提高了 GPU 资源的利用率,能帮助用户节约成本,实现降本诉求。

一键部署 CosyVoice2-0.5B(API调用/WebUI)

1. 登录 Function AI 控制台,找到探索页,人工智能页签下的「托管开源 CosyVoice2-0.5B 模型【1】」模板。

2. 点击立即部署。

3. 填写部署地域,并选择 OSS Bucket 和 GPU 卡型,然后点击部署项目。

4. 等待三分钟,即可完成部署。

5. 部署完成后可以看到「访问地址」页签下的模型 Endpoint,同时支持公网和内网调用 API。

6. 模型 API 调用示例请参考使用说明【1】。

7. 如需 WebUI 版本,请体验:https://cap.console.aliyun.com/template-detail?template=268

后续计划

随着语音合成场景的不断深入,LLM + TTS 的模式日益普遍,流式输入也成为刚需,因此后续会考虑:

1. 流式输入,解决 LLM + TTS 场景下的语音合成。

2. WebSocket 连接,让流式输出更可靠。

【1】托管开源 CosyVoice2-0.5B 模型