Logz.io提供了一种使用机器学习进行智能日志分析的托管服务。该服务能够从人类与日志数据的交互中获得新的观点,这些日志数据包括技术论坛上的讨论内容和公共代码库。

DevOps团队使用ELK这类日志分析工具中心化了日志的聚合和索引过程,但是现代应用正快速地生成大量的日志和度量指标,日志的庞大规模使得日志分析工作难以顺利进行。另一方面,所采集度量指标的数量也在快速地增长,这导致传统监测工具只能用来做数据展示。数据在规模上的增长也导致了基于阈值的报警不再适用,这也引发了异常检测系统的异军突起,这些系统包括Anomaly.io、Datadog和SumoLogic,以及Etsy的Skyline这样的开源系统。

相比异常检测系统而言,Logz.io所提供的服务更进了一步,它给出了对异常情况的深层见解,这些见解是通过在人们的网络交互数据上进行机器学习得出的。这些数据中包括在StackOverflow和Github这样的网站上对类似异常情况的讨论。如果单纯地使用Google搜索异常情况,这常会出现大量的搜索结果,Logz.io是如何做到对相关结果的过滤的呢?InfoQ联系了Logz.io公司的CEO和联合创始人Tomer Levy,他对此做了详述:

Logz.io使用了机器学习技术去理解线索的情境、线索所指的产品、是否有解决方案以及提问者对给出的方案是否满意。我们还拿自有的用户数据跟这些线索进行交叉引用。

此外,Levy还指出:“在给出了对用户关注的见解后,我们进而基于他/她对该见解的反馈情况对它们之间的相关性进行评估。”这就实现了一种反馈闭环,使得该服务系统可以与时俱进。

很多现代的软件产品都是使用开源程序库构建的,因此大部分情况下在因特网上搜索这些产品的某个错误或异常都会给出搜索结果。但也应考虑到在极少数情况下,还有一些产品是完全从头构建的,没有使用任何公开可用的代码。对此,Logz.io计划在未来发布一种“非公开见解”,允许组织定义自己的异常和异常的相关细节。

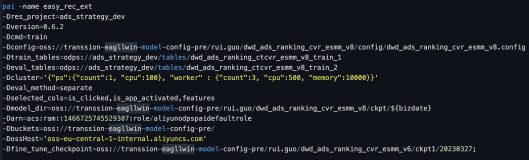

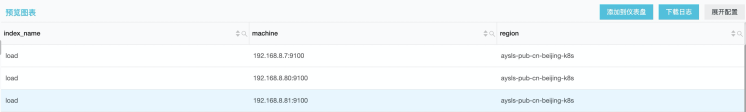

Logz.io采用了Elasticsearch-Logstash-Kibana(ELK)技术栈作为后台,提供的服务托管在Logz.io私有云上,这意味着日志数据必须要从各个应用端传输到该私有云中。对那些部署了自有ELK的组织来说,Logz.io提供了本地日志传输器,帮助这些组织将数据安全传输到Logz.io云上。

作为对如何解决企业所关注的数据安全问题的回应,Levy说道:

在数据安全方面,我们投入大量精力在数据加密和全面的安全流程上。Logz.io聘请了安永会计师事务所对安全基础设施和流程进行审计,并在近期通过了欧盟对SOC 2 II型报告和ISO-27001标准的合规审计。此外,公司的数据是在美国托管的。为确保遵守欧盟的法规,基于欧盟的企业可以选择将数据放在法兰克福保存。

本文转自d1net(转载)