编辑:杜伟

在生成式 AI 盛行的今天,英伟达在文本生成视频领域更进了一步,实现了更高分辨率、更长时间。

要说现阶段谁是 AI 领域的「当红辣子鸡」?生成式 AI 舍我其谁。包括 ChatGPT 等对话式 AI 聊天应用、Stable Diffusion 等 AI 绘画神器在内,生成式 AI 展示的效果深深地抓住了人们的眼球。

我们以图像生成模型为例,得益于底层建模技术最近的突破,它们收获了前所未有的关注。如今,最强大的模型构建在生成对抗网络、自回归 transformer 和扩散模型(diffusion model, DM)之上。其中扩散模型的优势在于能够提供稳健和可扩展的训练目标,并且参数密集度通常低于基于 transformer 的竞品模型。

虽然图像领域取得了长足进步,但视频建模却落后了,这主要归咎于视频数据训练的高昂计算成本以及缺乏大规模公开可用的通用数据集。目前视频合成虽有丰富的研究文献,但包括先前视频 DM 在内的大多数工作仅能生成分辨率较低且往往较短的视频。

因此,如何生成分辨率更高、更长的视频成为一个热门研究课题。近日慕尼黑大学、英伟达等机构的研究者利用潜在扩散模型(latent diffusion model, LDM)实现了高分辨率的长视频合成。相关论文已经发表在 arXiv 上。

- 项目主页:https://research.nvidia.com/labs/toronto-ai/VideoLDM/

- 论文地址:https://arxiv.org/pdf/2304.08818.pdf

在论文中,研究者将视频模型应用于真实世界问题并生成了高分辨率的长视频。他们关注两个相关的视频生成问题,一是高分辨率真实世界驾驶数据的视频合成,其在自动驾驶环境中作为模拟引擎具有巨大潜力;二是文本指导视频生成,用于创意内容生成。

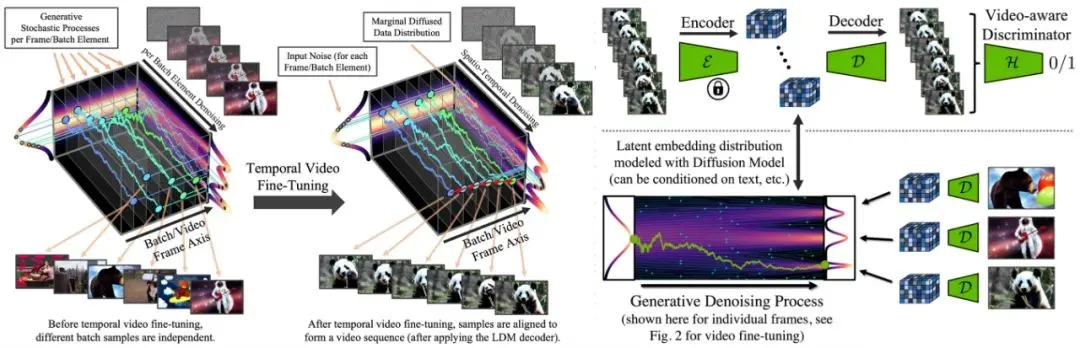

为此,研究者提出了视频潜在扩散模型(Video LDM),并将 LDM 扩展到了计算密集型任务 —— 高分辨率视频生成。与以往视频生成 DM 工作相比,他们仅在图像上预训练 Video LDM(或者使用可用的预训练图像 LDM),从而允许利用大规模图像数据集。

接着将时间维度引入潜在空间 DM、并在编码图像序列(即视频)上仅训练这些时间层的同时固定预训练空间层,从而将 LDM 图像生成器转换为视频生成器(下图左)。最后以类似方式微调 LDM 的解码器以实现像素空间中的时间一致性(下图右)。

此外,为了进一步提高空间分辨率,研究者对像素空间和潜在 DM 上采样器进行时间对齐,将它们转换为时间一致的视频超分辨率模型。在 LDM 的基础上,本文方法以计算和内存高效的方式生成了全局连贯的长视频。对于非常高分辨率的合成,视频上采样器只需要在本地运行,保持了较低的训练和计算要求。

最后,研究者进行了消融实验,在分辨率为 512×1024 的真实驾驶场景视频上对其方法进行了测试,实现了 SOTA 视频质量,并合成了几分钟的视频。此外,他们还微调了 Stable Diffusion,将它变成一个高效、强大的文本到视频生成器,分辨率最高可达 1280 × 2048。

通过将经过训练的时间层迁移至不同的微调文本到图像 LDM,研究者首次展示了个性化的文本到视频生成,并希望自己的工作为高效的数字内容创建和自动驾驶模拟开辟新的途径。

我们来看几个文本到视频生成示例,比如「弹电吉他的泰迪熊、高分辨率、4K」。

比如「海浪拍打着一座孤独的灯塔、不详的灯光」。

再比如「夕阳下独自穿行在迷雾森林中的旅行者」。

方法解读:潜在视频扩散模型

这部分中,研究者描述了为实现高分辨率视频合成,对预训练图像 LDM 和 DM 上采样器进行视频微调。