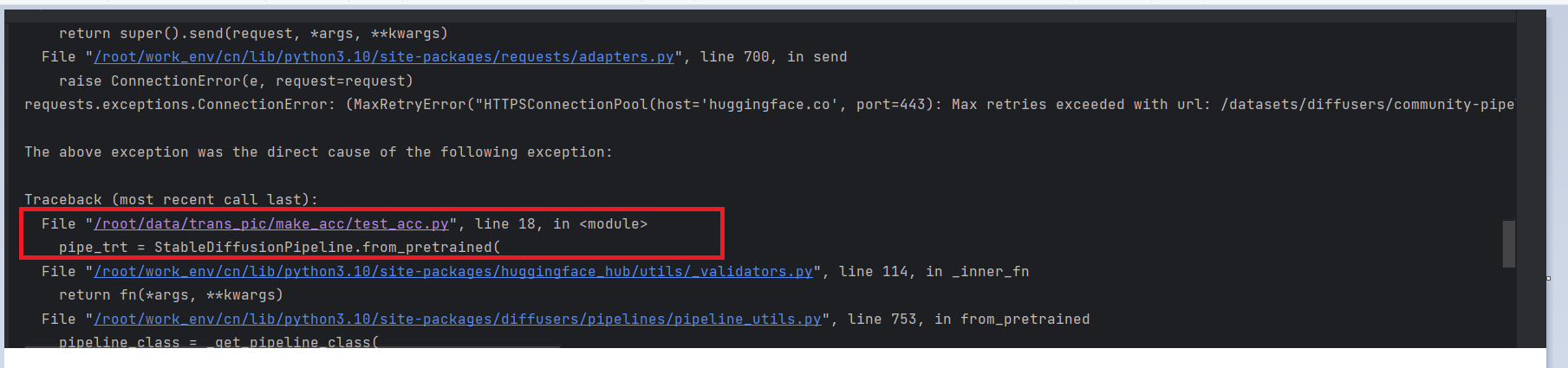

"import diffusersimport torchimport tensorrtfrom diffusers.pipelines.stable_diffusion import StableDiffusionPipelinefrom diffusers import DDIMScheduler# 默认从huggingface下载,如果机器无法访问huggingface,也可以使用本地模型。# 如使用本地模型,替换runwayml/stable-diffusion-v1-5为本地模型地址即可model_path = ""/root/ai-model/stable-diffusion-v1-5""scheduler = DDIMScheduler.from_pretrained(model_path, subfolder=""scheduler"")# 使用自定义的pipelinepipe_trt = StableDiffusionPipeline.from_pretrained( model_path, custom_pipeline=""stable_diffusion_tensorrt_txt2img"", revision='fp16', torch_dtype=torch.float16, scheduler=scheduler,)# 设置缓存地址# 会在缓存地址下生成engine文件夹,包含clip.plan、unet.plan、vae.plan文件。A10上首次生成plan文件需要约35分钟pipe_trt.set_cached_folder(model_path, revision='fp16')pipe_trt = pipe_trt.to(""cuda"") modelscope本地模型为什么会报错 ?

"

您搜一下StableDiffusionPipeline如何加载本地模型,有解决方案叭。此回答整理自钉群“魔搭ModelScope开发者联盟群 ①”

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352