函数计算FC这个问题怎么解决?

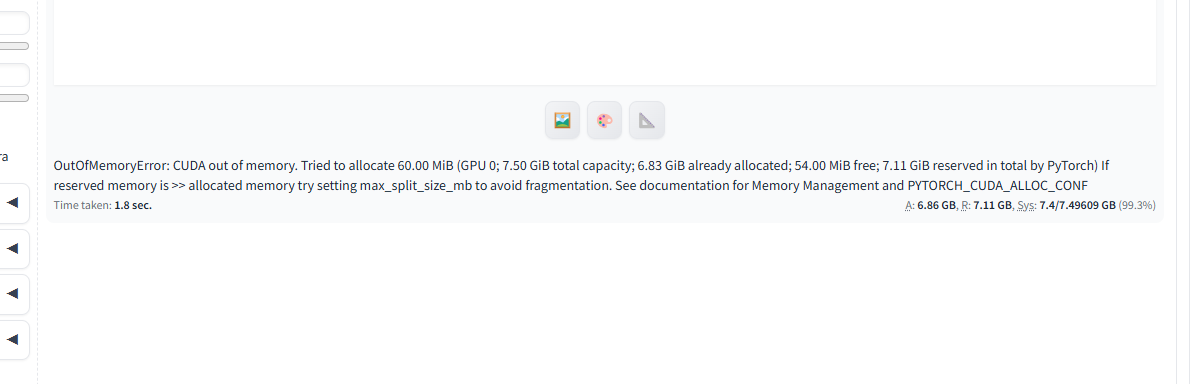

OutOfMemoryError: CUDA out of memory. Tried to allocate 60.00 MiB (GPU 0; 7.50 GiB total capacity; 6.83 GiB already allocated; 54.00 MiB free; 7.11 GiB reserved in total by PyTorch) If reserved memory is >> allocated memory try setting max_split_size_mb to avoid fragmentation. See documentation for Memory Management and PYTORCH_CUDA_ALLOC_CONF

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

如果您遇到 outofmemoryerror: cuda out of memory 错误,这通常意味着您的图形处理器(GPU)在运行过程中没有足够的内存来完成操作,特别是在处理大型图像或复杂的模型时。针对这一问题,可以尝试以下几个解决方案:

减小批量大小(Batch Size):如果您是在进行训练或推理任务,尝试减少每次处理的数据量大小。

降低分辨率:在生成图像时,使用更低的分辨率设置可以显著减少所需的 GPU 内存。

优化模型:如果可能,尝试对您的模型进行优化,比如剪枝、量化,以减小其内存占用。

使用内存释放脚本:在某些场景下,如 Stable Diffusion 使用中,可能有内存释放脚本或者命令可以运行,以确保之前的操作没有遗留占用的内存。

升级硬件:最后,如果上述软件层面的调整都无法满足需求,考虑升级到具有更大 GPU 内存的设备。

对于稳定扩散(Stable Diffusion)WebUI 用户来说,一个快速的解决尝试是重启 WebUI,有时候这能清理遗留的内存占用问题。如果错误持续发生,检查是否有消耗大量资源的插件正在运行,并尝试禁用它们。

请尝试上述建议并观察是否有所改善。如果问题依旧,建议查阅 Stable Diffusion WebUI 的 GitHub 仓库中的 issue 页面,那里可能有其他用户遇到相同问题的解决方案。 此回答整理自钉群“【交流群】函数计算 AIGC 场景技术交流”