使用阿里云DeepGPU能带来哪些性能提升?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

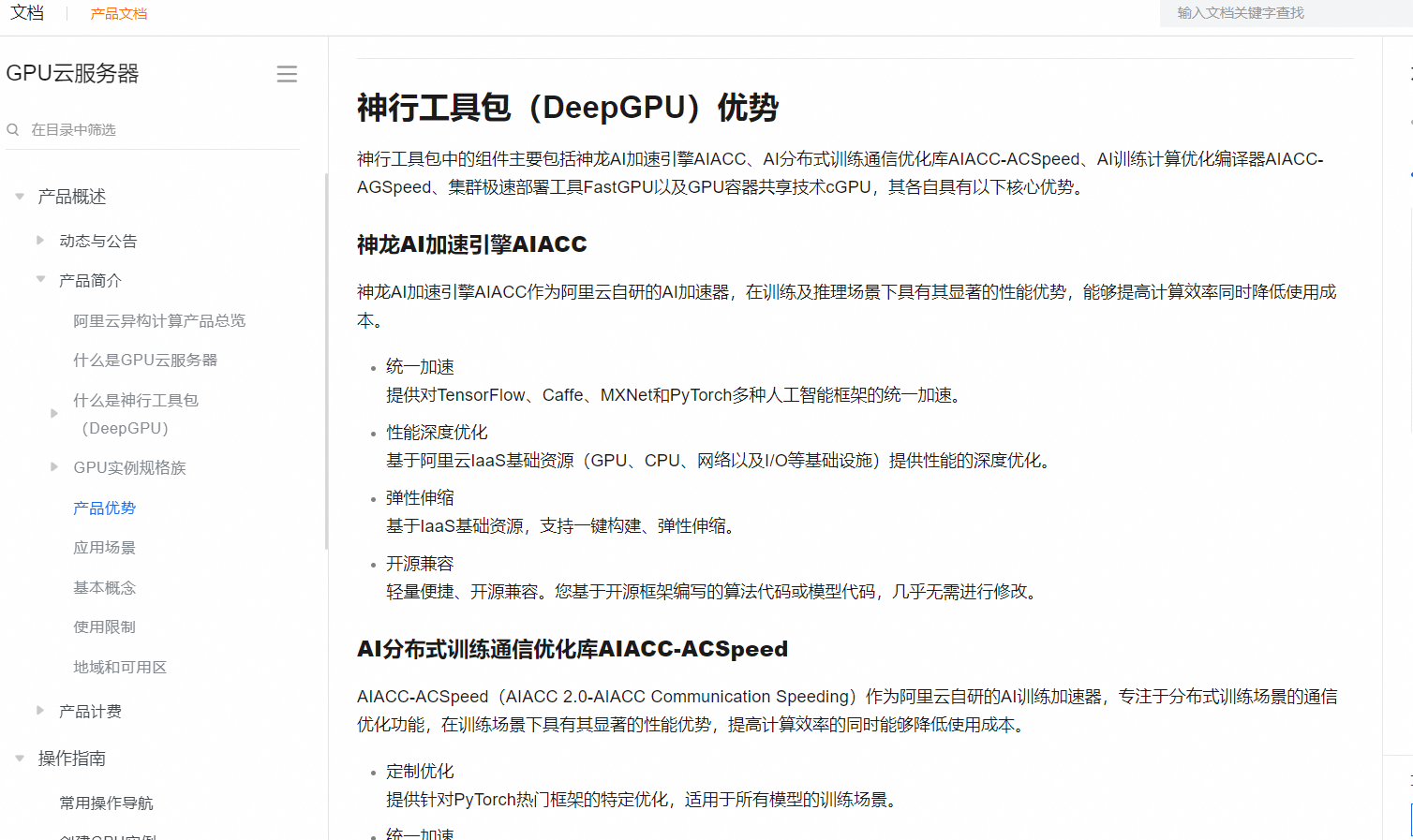

神行工具包中的组件主要包括神龙AI加速引擎AIACC(AIACC-Training和AIACC-Inference)、AI分布式训练通信优化库AIACC-ACSpeed、AI训练计算优化编译器AIACC-AGSpeed、集群极速部署工具FastGPU以及GPU容器共享技术cGPU,该工具主要适用于AI训练和AI推理场景。具体说明如下:

AIACC能够适用于所有AI推理场景。该工具进行AI推理的典型业务场景如下所示:

参考文档https://help.aliyun.com/zh/egs/scenarios-2?spm=a2c4g.11186623.0.i76

阿里云DeepGPU工具包提供了多个组件,如AIACC加速引擎、AI分布式训练通信优化库AIACC-ACSpeed、AI训练计算优化编译器AIACC-AGSpeed、FastGPU集群部署工具和GPU容器共享技术cGPU。这些工具在以下几个方面能提升性能:

统一加速:支持多种AI框架的统一优化,如TensorFlow、Caffe、MXNet和PyTorch。

性能深度优化:针对阿里云IaaS资源进行优化,提高计算和通信效率。

弹性伸缩:快速构建和调整资源,适应业务需求变化。

开源兼容:几乎无需修改代码,轻松集成现有模型。

定制优化:针对特定框架和场景提供优化,如PyTorch的训练加速。

资源利用率提升:通过cGPU技术,实现GPU资源的灵活分配和安全隔离,降低成本并提高利用率。

可以参考链接标题中的信息。

阿里云DeepGPU使用了高性能的GPU,如NVIDIA的Tesla系列,这些GPU专为深度学习任务设计,可以提供比CPU更高的计算速度。这对于运行复杂的神经网络模型尤为重要,可以显著减少模型的推理时间。

使用阿里云DeepGPU可以帮助用户优化他们使用GPU的效率。在LLM微调训练场景下,性能最高可提升80%;在Stable Diffusion推理场景下,性能最高可提升60%。