"

在其他的pipeline上能够调用GPU加速,但是无法将ModelScope模型在GPU上推理,有解决方法吗?"

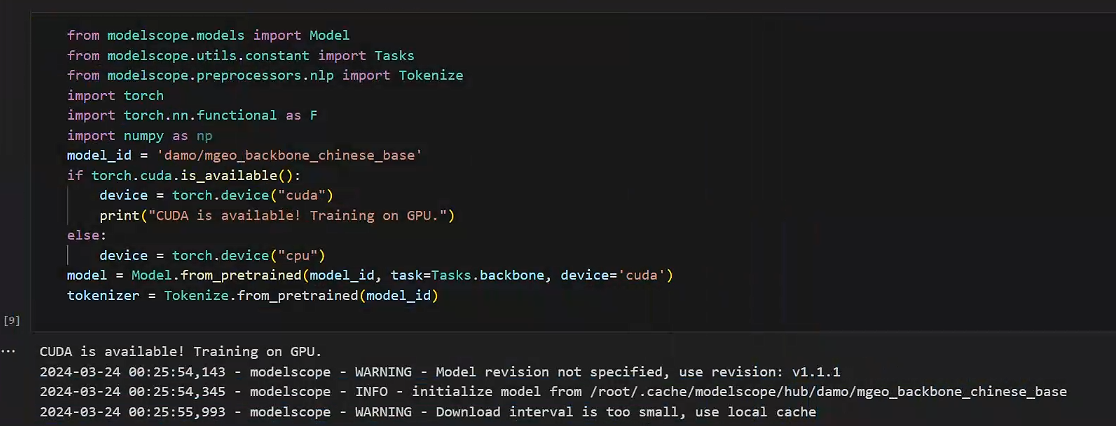

有解决方法可以让您在GPU上进行ModelScope模型的推理。

首先,确保您的环境中已经安装了CUDA,并且配置正确,以便可以利用GPU的计算能力来加速模型的推断过程。CUDA是NVIDIA提供的一个平台,它允许软件利用NVIDIA的GPU进行并行计算。

其次,如果您在使用ModelScope时遇到无法在GPU上进行模型推理的问题,可以尝试设置环境变量CUDA_VISIBLEDEVICES来指定在哪张显卡上运行推理任务。这个环境变量接受一个设备列表,您可以指定一个或多个GPU设备ID,以便将计算任务分配到这些设备上。

此外,由于ModelScope服务端的配置和实现可能会影响模型在特定GPU上的运行,您可能需要检查ModelScope的服务端设置,以确保它们支持在GPU上进行模型推理。

综上所述,通过安装和配置CUDA、设置CUDA_VISIBLE_DEVICES环境变量以及检查ModelScope服务端的配置,您应该能够解决无法在GPU上进行ModelScope模型推理的问题。如果问题依旧存在,建议联系ModelScope的技术支持以获取更专业的帮助。

可以尝试通过设置环境变量来指定ModelScope模型在特定GPU上进行推理。

如果您在其他pipeline上能够成功调用GPU加速,但在ModelScope中遇到无法在GPU上进行模型推理的问题,可能是由于ModelScope服务端的配置和实现导致的。通常情况下,ModelScope可能不支持直接通过参数来指定模型在特定GPU上运行。不过,您可以尝试以下方法来解决这个问题:

CUDA_VISIBLE_DEVICES环境变量来指定在哪张显卡上运行推理任务。这个环境变量接受一个设备编号列表,通过指定不同的编号,可以让模型在不同的GPU设备上运行。综上所述,虽然ModelScope可能没有直接的参数来指定模型在特定GPU上运行,但通过设置环境变量和其他配置,您仍然有机会实现在GPU上的模型推理。

可以尝试通过设置环境变量CUDA_VISIBLE_DEVICES来指定ModelScope模型在特定GPU上进行推理。

如果您在其他pipeline中能够成功调用GPU加速,但在ModelScope中无法实现模型的GPU推理,可能是由于ModelScope服务端的配置或者实现方式导致的。在ModelScope中,可能无法直接通过参数来指定模型在特定GPU上运行。不过,您可以通过设置CUDA_VISIBLE_DEVICES环境变量来尝试解决这个问题。这个环境变量允许您指定在哪张显卡上运行推理任务。

具体操作步骤如下:

CUDA_VISIBLE_DEVICES环境变量,例如export CUDA_VISIBLE_DEVICES=0,这将会指定使用编号为0的GPU设备来进行推理任务。此外,还可以考虑检查ModelScope的服务端配置是否存在限制,或者是否有特定的Agent设置需要调整,例如Modelscope结合α-UMi的多模型协作Agent可能会有特殊的配置要求。

综上所述,通过设置环境变量和检查ModelScope的相关配置,您应该能够找到解决无法在GPU上进行模型推理的方法。如果问题依旧无法解决,建议寻求专业技术支持。

ModelScope旨在打造下一代开源的模型即服务共享平台,为泛AI开发者提供灵活、易用、低成本的一站式模型服务产品,让模型应用更简单!欢迎加入技术交流群:微信公众号:魔搭ModelScope社区,钉钉答疑群:44837352