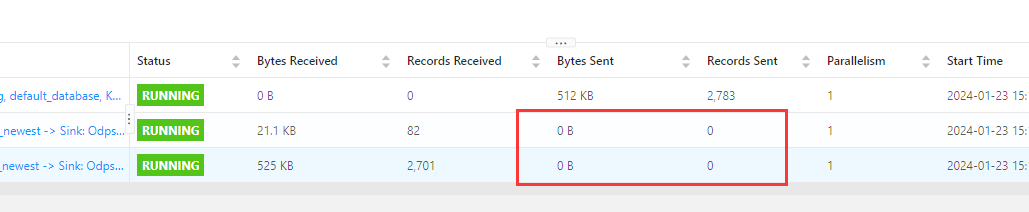

使用自建flink写入大数据计算MaxCompute数据写不进去是咋回事?已开通Transaction Table2.0类型表

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在使用自建Flink集群写入阿里云MaxCompute的Transaction Table 2.0时,如果数据无法成功写入,可能存在以下原因及相应的解决办法:

Flink Connector MaxCompute版本兼容性问题:

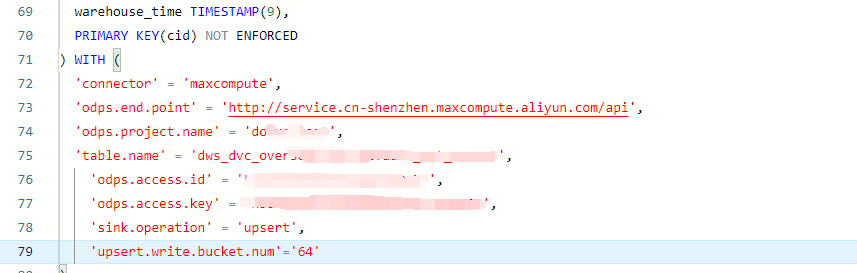

配置错误:

表结构不匹配:

权限问题:

事务一致性问题:

网络问题或超时:

楼主你好,看了你的问题,你可以尝试检查代码逻辑,确保代码没有错误,包括连接MaxCompute的配置信息是否正确,数据写入的逻辑是否正确。

还有就是检查依赖库,确保使用的Flink依赖库版本与MaxCompute兼容。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。