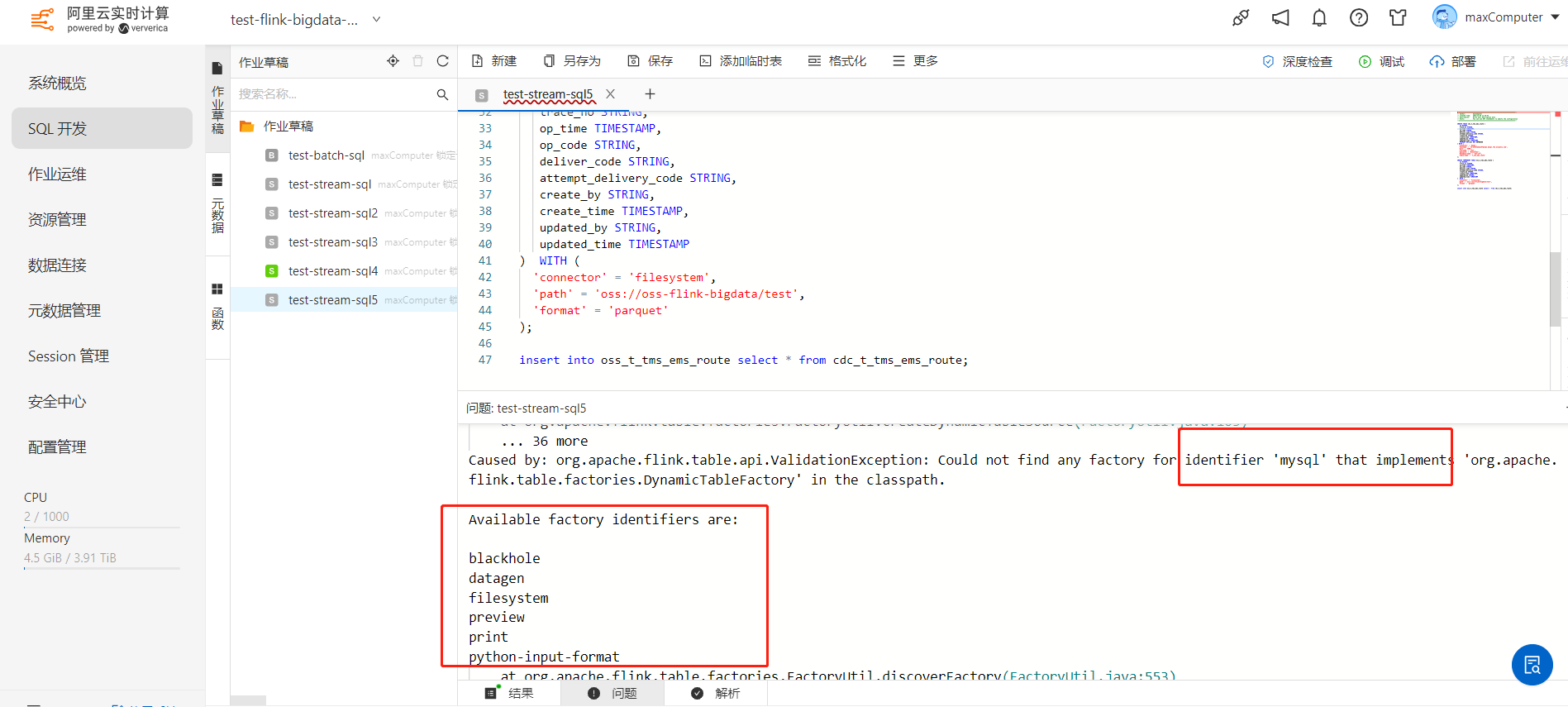

Flink这个mysql-cdc连接器应该怎样添加呢?使用平台的connector,我想用平台的flink mysql cdc功能去链接我们的阿里云mysql数据库。

https://vvp.console.aliyun.com/web/b769aca49e204d/zh/#/workspaces/b769aca49e204d/namespaces/test-flink-bigdata-default/draft/cd34195d-0c7e-4441-8350-e8a3bbae97af/sql

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

要解决这个问题,请按照以下步骤操作:

首先,在你的项目中安装 Flink 连接 MySQL 的依赖库。如果你正在使用 Maven 或 Gradle 管理依赖项,则需要在 pom.xml(Maven)或 build.gradle(Gradle)文件中添加相应的依赖。

对于 Maven:

```xml

com.google.code.findbugs

jsr305

provided

对于 Gradle:

```groovy

implementation 'org.apache.flink:flink-connector-mysql-cdc-java_2.11:$FLINK_VERSION'

// 如果你想支持 Java 8,请添加此依赖

implementation "com.google.code.findbugs:jsr305"

请确保将 $FLINK_VERSION 替换为实际版本号,并根据需要调整其他配置选项。

flink-connector-mysql-cdc 连接器到你的作业代码中。你可以参考官方文档:https://ci.apache.org/projects/flink/flink-docs-release-1.14/dev/table/connectors/mysql_cdc.html#configuration例如,创建一个新的 SQL 脚本以加载数据并将其插入到表中:

INSERT INTO my_table SELECT * FROM source_table;

请注意替换 my_table 和 source_table 为你想要使用的表名和源表名。

以下是可能有用的环境变量示例:

export FLINK_CDC_MYSQL_HOST=localhost

export FLINK_CDC_MYSQL_PORT=3306

export FLINK_CDC_MYSQL_USER=root

export FLINK_CDC_MYSQL_PASSWORD=<your_password_here>

export FLINK_CDC_MYSQL_DATABASE=my_database_name

请将上述值替换为你自己的 MySQL 数据库相关信息。

要在Flink中添加MySQL-CDC连接器,您需要按照以下步骤操作:

首先,确保您的Flink版本支持MySQL-CDC连接器。根据官方文档,Flink 1.13及以上版本支持MySQL-CDC连接器。

下载MySQL-CDC连接器的JAR文件。您可以从Maven仓库下载最新版本的MySQL-CDC连接器:https://mvnrepository.com/artifact/com.ververica/flink-connector-mysql-cdc_2.12

将下载的JAR文件添加到Flink的lib目录下。在Flink安装目录下的lib文件夹中,将下载的JAR文件复制到该文件夹中。

在Flink的配置文件(例如flink-conf.yaml)中,添加以下配置以启用MySQL-CDC连接器:

jobmanager.rpc.address: <JobManager地址>

jobmanager.rpc.port: <JobManager端口>

taskmanager.numberOfTaskSlots: <任务插槽数量>

state.backend: <状态后端类型,例如rocksdb、memory等>

state.backend.rocksdb.localdir: <RocksDB本地存储目录>

table.execution.arrow.enabled: false

table.execution.pandas.enabled: false

table.execution.blink.planner.enabled: true

table.catalog.name: <表目录名称>

table.catalog.type: hive

table.catalog.default-database: <默认数据库名称>

table.catalog.hive.metastore.uris: <Hive Metastore URI>

table.catalog.hive.metastore.schema.pattern: <模式模式>

table.catalog.hive.metastore.username: <用户名>

table.catalog.hive.metastore.password: <密码>

table.catalog.hive.metastore.kerberos.principal: <Kerberos主体>

table.catalog.hive.metastore.kerberos.keytab: <Kerberos keytab文件路径>

table.catalog.hive.metastore.kerberos.krb5conf: <Kerberos krb5配置文件路径>

table.catalog.hive.metastore.kerberos.jaasconf: <Kerberos JAAS配置文件路径>

table.catalog.hive.metastore.kerberos.useSubject: <是否使用主题>

table.catalog.hive.metastore.kerberos.hostnameOverride: <主机名覆盖>

table.catalog.hive.metastore.kerberos.serviceName: <服务名称>

table.catalog.hive.metastore.kerberos.renewWindow: <票据续订窗口>

table.catalog.hive.metastore.kerberos.retries: <重试次数>

table.catalog.hive.metastore.kerberos.debug: <调试模式>

table.catalog.hive.metastore.kerberos.allowSelfSigned: <是否允许自签名证书>

table.catalog.hive.metastore.kerberos.trustStorePath: <信任库路径>

table.catalog.hive.metastore.kerberos.trustStorePassword: <信任库密码>

table.catalog.hive.metastore.kerberos.keyStorePath: <密钥库路径>

table.catalog.hive.metastore.kerberos.keyStorePassword: <密钥库密码>

table.catalog.hive.metastore.kerberos.keyStoreType: <密钥库类型>

table.catalog.hive.metastore.kerberos.keyStoreProvider: <密钥库提供者>

table.catalog.hive.metastore.kerberos.clientKeyTab: <客户端密钥库文件路径>

table.catalog.hive.metastore.kerberos.clientKeyTabPassword: <客户端密钥库密码>

table.catalog.hive.metastore.kerberos.clientKeyTabType: <客户端密钥库类型>

table.catalog.hive.metastore.kerberos.clientKeyTabProvider: <客户端密钥库提供者>

请根据您的实际情况替换上述配置中的占位符。

现在,您应该可以在Flink中使用MySQL-CDC连接器连接到阿里云MySQL数据库了。

参考https://help.aliyun.com/zh/flink/developer-reference/apsaradb-rds-for-mysql-connector?spm=a2c4g.11186623.0.0.4afabc68s2G6FK 此回答整理自钉群“实时计算Flink产品交流群”

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。