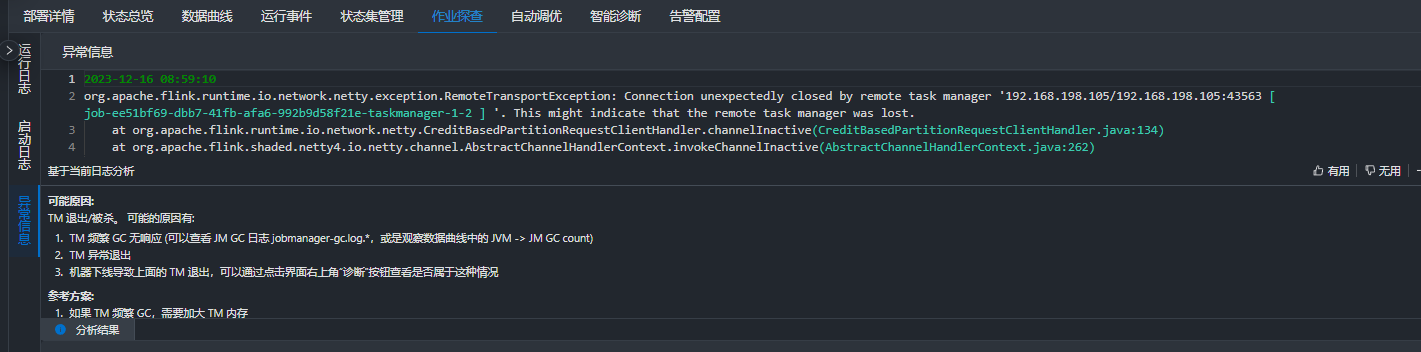

在Flink我这边已经给到很大内存,而且我看内存使用率都没到50%,

就会爆这个错,然后任务重启,怎么解决?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个问题可能是由于Flink的内存管理机制导致的。当Flink任务在运行过程中,如果发生GC(垃圾回收)操作,可能会导致任务暂停一段时间,从而影响任务的执行效率。

为了解决这个问题,你可以尝试以下方法:

调整JVM参数:可以通过调整JVM的参数来减少GC的频率和时间。例如,可以增加-XX:ParallelGCThreads参数的值来增加并行GC线程的数量,或者增加-XX:+UseG1GC参数来使用更高效的垃圾回收算法。

调整Flink配置参数:可以通过调整Flink的配置参数来优化内存管理和垃圾回收机制。例如,可以增加taskmanager.memory.off-heap参数的值来增加Off-Heap内存的使用量,或者增加taskmanager.network.memory.min和taskmanager.network.memory.max参数的值来增加网络内存的使用量。

检查代码逻辑:如果以上方法都无法解决问题,那么可能是代码逻辑存在问题。可以检查代码中是否存在内存泄漏或者不合理的内存使用方式,并进行相应的优化。

如果你的Flink任务在内存使用率未达到50%的情况下就出现错误并导致任务重启,以下是一些可能的排查和解决步骤:

检查错误日志:

首先,你需要查看具体的错误日志以确定错误的具体原因。错误日志中应该包含了关于错误的详细信息,这将帮助你了解问题所在。

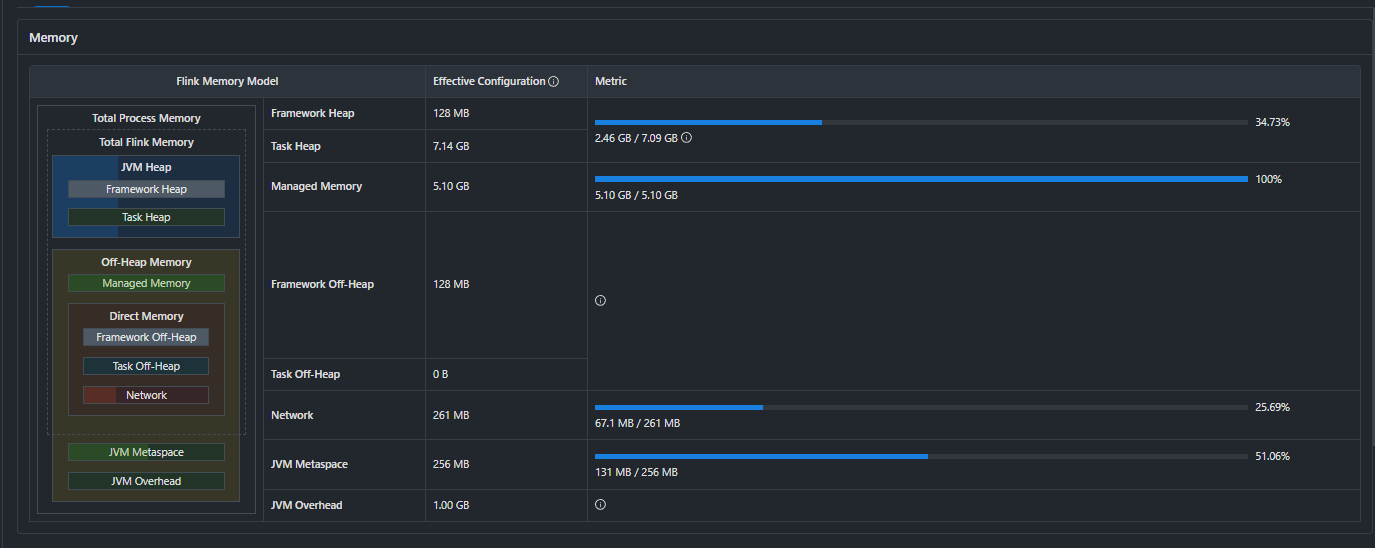

内存配置检查:

虽然你提到已经分配了很大的内存,但还是需要确认以下内存相关的配置是否合理:

taskmanager.memory.process.size:TaskManager的总内存大小。taskmanager.memory.flink.size:Flink框架使用的内存大小。taskmanager.memory.managed.size:托管内存大小,用于排序、哈希表等操作。taskmanager.memory.jvm-metaspace.size 和 taskmanager.memory.jvm-overhead.fraction:JVM元空间和JVM开销的内存配置。确保这些配置与你的实际资源相匹配,并且没有过度限制或过度分配。

直接内存问题:

Flink任务可能会使用直接内存(Direct Memory),而直接内存的大小是通过JVM参数 -XX:MaxDirectMemorySize 设置的。如果直接内存不足,即使堆内存还有很多,也可能导致问题。确保你已经为直接内存分配了足够的空间。

数据倾斜:

如果你的数据分布不均匀,可能会导致某些TaskManager节点的内存使用率快速上升,即使总体内存使用率不高。检查你的任务是否有数据倾斜的问题,并考虑使用Flink的重新分区或者自定义的负载均衡策略来改善数据分布。

状态后端问题:

如果你的任务使用了 RocksDB 或其他状态后端,可能存在状态大小超出预期或者状态访问效率低下的问题。检查状态后端的配置和使用情况。

网络流量和缓冲区:

网络流量过大或者网络缓冲区设置不当也可能导致问题。检查网络相关的配置,如套接字缓冲区大小等。

代码优化:

检查你的作业代码是否存在内存泄漏或者不必要的对象创建。优化代码可以减少内存使用。

监控和调试:

使用Flink的监控界面或者日志来观察任务的运行情况,包括CPU使用率、GC行为、网络IO等。这可以帮助你发现潜在的问题。

增加容错性:

考虑增加任务的容错性设置,比如增大检查点的间隔或者使用两阶段提交等策略,以减少由于短暂错误导致的任务重启。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。