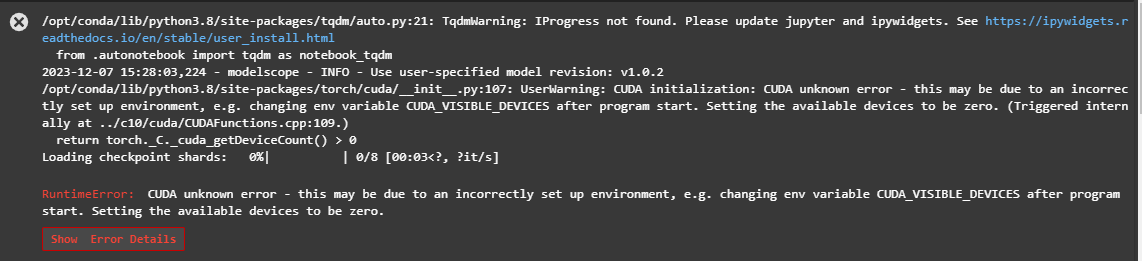

ModelScope这个镜像coda怎么没有运行起来呢,怎么检查cuda啊? 另外 >>> tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True, use_fast=False)

另外 >>> tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True, use_fast=False)

model = AutoModelForCausalLM.from_pretrained(model_dir, device_map="cuda:0", torch_dtype=torch.bfloat16, trust_remote_code=True)

model = model.eval(),这个怎么弄?

import torch 之后 torch.cuda.is_available() ,显卡型号是比较早的吗,是的话可能不支持bf16,脚本最前面加一下os.environ['CUDA_VISIBLE_DEVICES']='0'明星。此回答整理自钉群 “魔搭ModelScope开发者联盟群 ①”