GPU 跑一个文本分类训练的demo 需要这么久么

GPU 跑一个文本分类训练的demo 需要这么久么

运行时间的长度会受到许多因素的影响,包括你的电脑配置、数据集的大小以及模型的复杂性等。在ModelScope中,GPU运行一个文本分类训练的demo的时间并不固定。以中文情感分类模型为例,该模型可以在不到5分钟内获得出色的表现。然而,如果你的任务更为复杂,例如长文本分类或者需要下载大型模型文件,那么可能需要更长的时间。为了优化运行速度,你可以尝试使用更高效的模型,如PoNet,其GPU运行速度是Transformer的9倍。

在ModelScope中,GPU跑一个文本分类训练的demo的时间取决于多个因素,包括数据集的大小、模型的复杂性、训练迭代的次数等。通常情况下,使用GPU进行训练会比使用CPU更快,因为GPU具有更高的并行计算能力。

如果你的文本分类任务比较简单,并且使用了较小的数据集和较简单的模型,那么训练时间可能不会太长。然而,如果你的任务比较复杂,或者数据集很大,那么训练时间可能会相对较长。

此外,还需要考虑其他因素,如代码优化、数据预处理等。通过优化代码和使用适当的数据预处理技术,可以提高训练速度并减少训练时间。

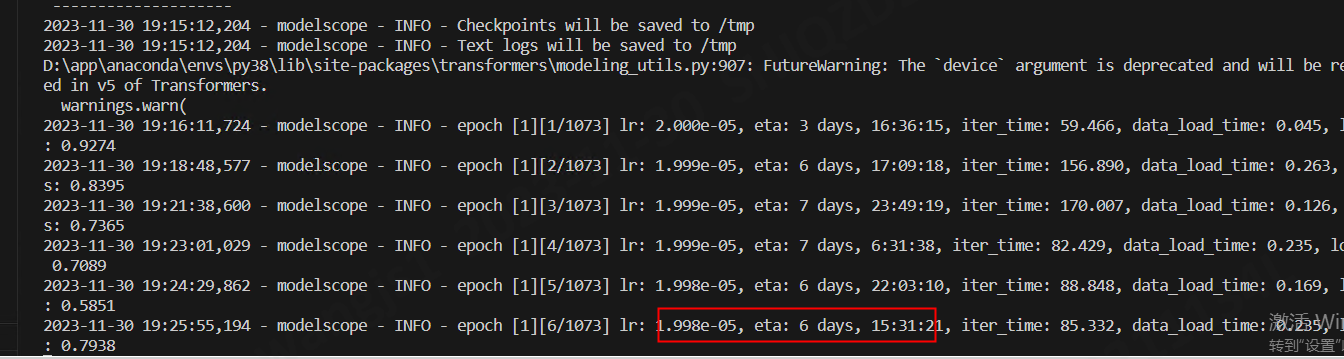

iter_time有点长,您调一下batch_size试试。调小一点 文本分类用这个example,比较方便。https://github.com/modelscope/modelscope/blob/master/examples/pytorch/text_classification/run_train.sh 。此回答整理自钉钉群:魔搭ModelScope开发者联盟群 ①