DataWorks中SET odps.session.networklink = Maxcomputer_boldvpc 如果 odps中spark请求一个内网地址 如何配置这个呢 在config中配置么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在dataworks上配置么 还是?这个set session级别在这里odps spark节点上好像不能配置 只能项目级别看是否能配置

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

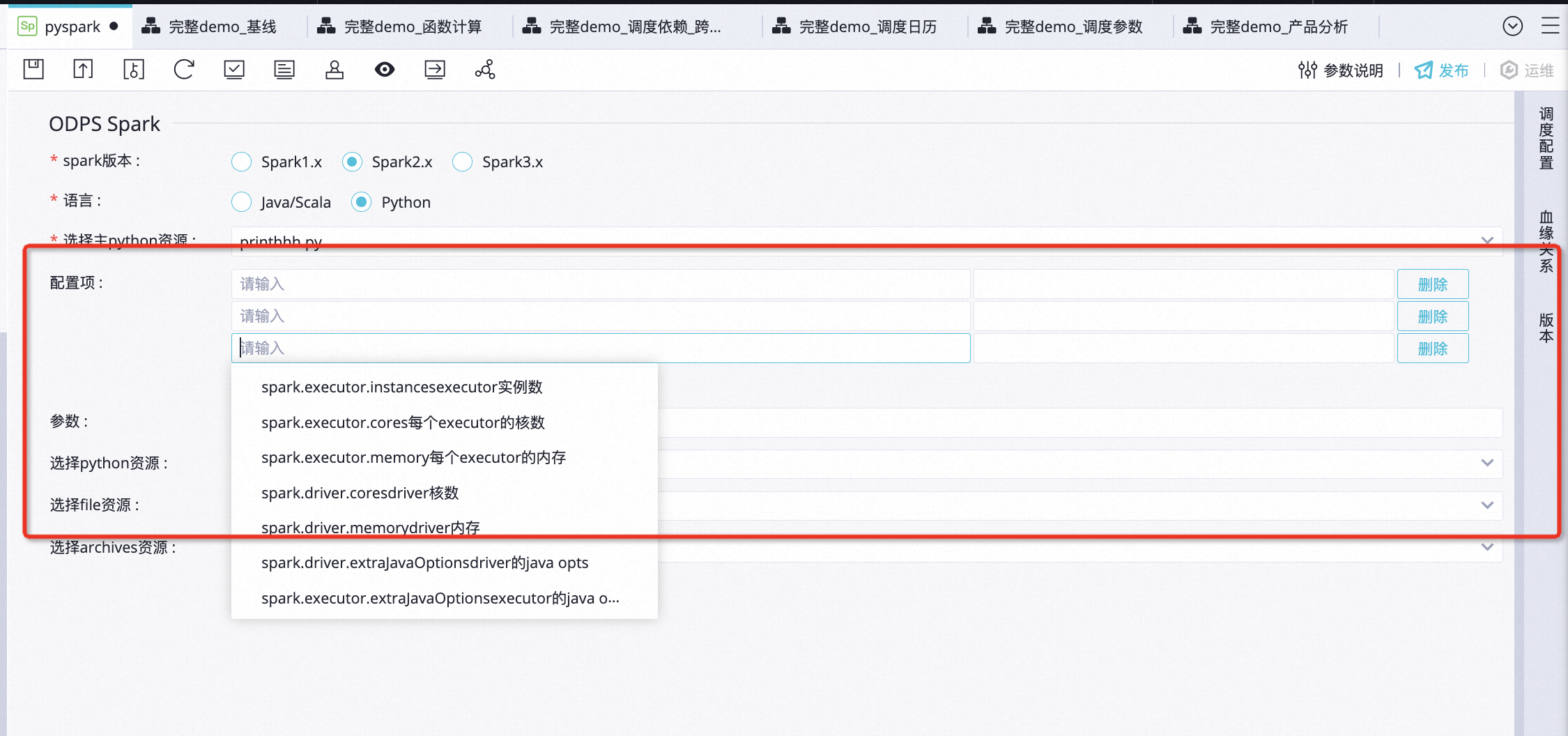

在DataWorks中,如果要配置ODPS中的Spark请求访问内网地址,可以通过在ODPS配置文件中进行相关设置。以下是具体的配置步骤:

odps.session.networklink,Value设置为Maxcomputer_boldvpc。通过以上配置,可以将ODPS中的Spark请求设置为访问内网地址。请确保您已经正确填写了配置项的Key和Value,并保存了配置项。配置生效后,ODPS中的Spark任务将使用BoldVPC进行网络连接,并可以访问内网地址。

在DataWorks中,可以通过配置odps.properties文件来设置odps.session.networklink参数。具体步骤如下:

odps.properties=odps.session.networklink=Maxcomputer_boldvpc

其中,Maxcomputer_boldvpc为需要访问的内网地址。

需要注意的是,该配置仅对当前节点有效,如果需要在多个节点上使用相同的配置,可以在每个节点上都进行相应的配置。

如果你需要在DataWorks中通过ODPS Spark请求内网地址,请按照以下步骤操作:

设置ODPS session network link

SET odps.session.networklink = maxcomputer.boldvpc;

启动ODPS Spark shell

在ODPS shell中,执行以下命令:

!sh bin/start-spark-shell.sh --master yarn --conf spark.yarn.jars=hdfs:///opt/modules/spark/lib/spark-network-linkage-2.4.6.jar

通过内网地址执行任务

在ODPS Spark shell中,可以通过网络链接执行任务,如:

java

sc.parallelize(Array("hdfs://test")).map(_ => sqlContext.read.format("jdbc").option("url", "jdbc:mysql://<内网地址>/test").load().show()

需要注意的是,需要正确配置ODPS session network link,并确保有足够的权限执行上述操作。如果需要使用ODPS命令来运行任务,请先登录ODPS控制台并设置相关配置。

让 DataWorks 中的 ODPS Spark 请求一个内网地址,则需要进行以下操作:

tunnel start --endpoint=https://endpoint --access-id=access_id --access-key=access_key --name=tunnel_name

在这里,需要将 endpoint 替换为要访问的内网地址,并且提供相应的 access_id 和 access_key。

export TUNNEL_ENDPOINT=your_tunnel_endpoint

export TUNNEL_ACCESS_ID=your_access_id

export TUNNEL_ACCESS_KEY=your_access_key

export TUNNEL_NAME=your_tunnel_name

可以在 Spark 任务的 code 中使用内网地址.不同的环境可能有不同的配置方式,因此建议您参考官方文档来了解具体步骤。

MaxCompute(原ODPS)是一项面向分析的大数据计算服务,它以Serverless架构提供快速、全托管的在线数据仓库服务,消除传统数据平台在资源扩展性和弹性方面的限制,最小化用户运维投入,使您经济并高效的分析处理海量数据。