DataWorks调用数据源服务失败:获取API关联数据源信息失败:Communications link failure The last packet sent successfully to the server was 0 milliseconds ago. The driver has not received any packets from the server.

详情一键复制

ErrorCode :

1108110441

RequestId :

0bc3b2d716995870512057425e85a4?{"code":1108110441,"requestId":"0bc3b2d716995870512057425e85a4"}没有绑定数据服务资源组 默认就是使用的公共资源组是么?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这个问题可能是由于网络连接问题或者是数据源服务器的问题引起的。以下是一些可能的解决办法:

在调用 DataWorks 数据源服务时出现错误 1108110441 表明通信链接失败,无法连接到服务器。这可能是由于以下几个原因造成的:

看报错是数据服务资源组网络不通 可以参考这里的配置

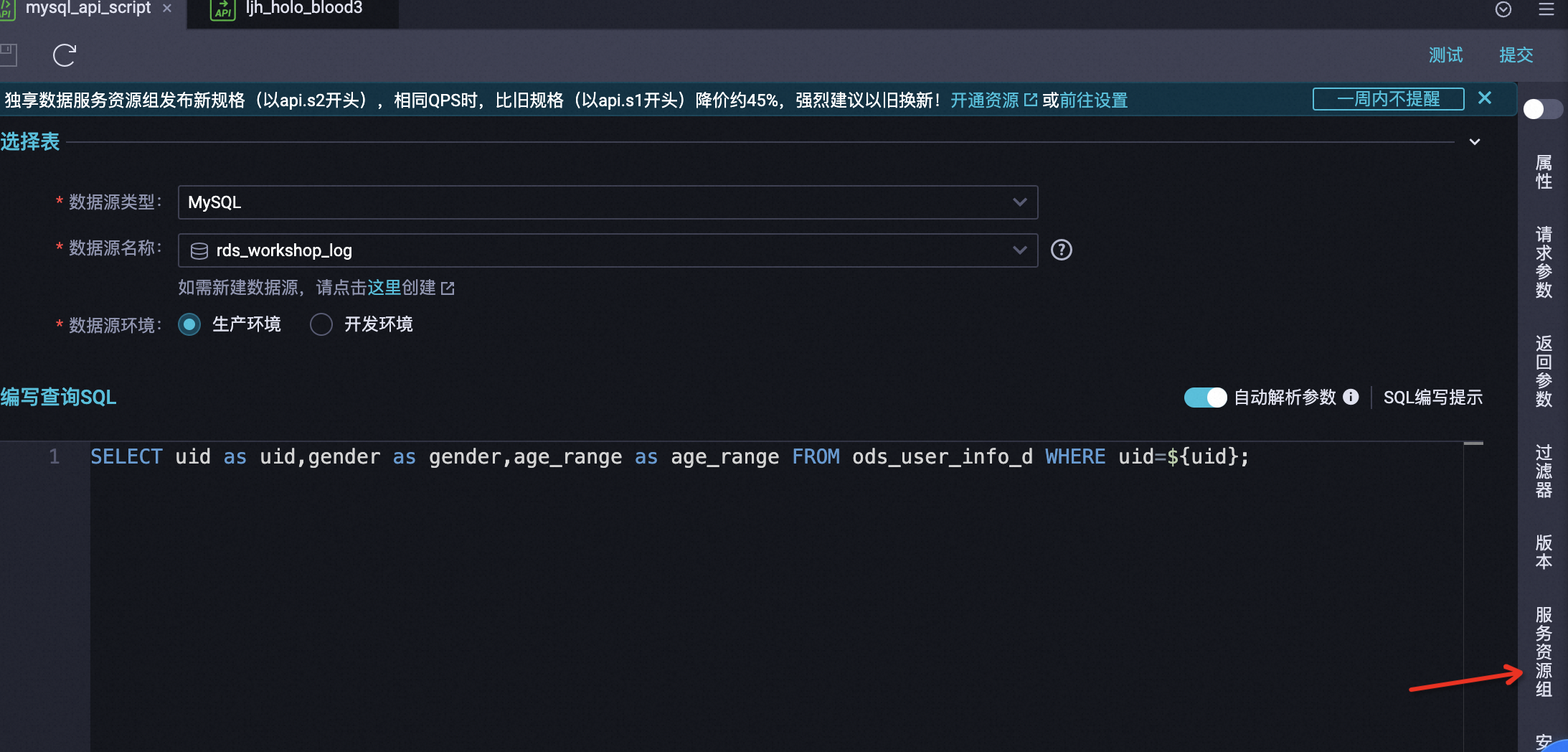

在这边可以查看使用的资源组

,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

看起来您遇到了连接数据库时通信链接失败的问题。这可能是由于以下原因:

DataWorks在调用数据源服务失败时,返回的错误信息提示可能是由于没有绑定数据服务资源组。DataWorks在默认情况下使用的是公共资源组,但为了确保数据源的稳定性和性能,建议您为其配置独享资源组。此外,当Redis添加数据源时如果没有公网IP,需要保证数据源和DataWorks工作空间地域一致,通过新增调度资源完成数据源的打通。同时,DataWorks数据服务接收到调用API的请求后,会将请求结果信息返回给请求端,其中包含各类错误码。这些错误码可以帮助您快速定位问题并进行自助排错。

离线同步报错:Communications link failure

读取报错

问题现象:

读取数据时,报错如下:Communications link failure The last packet successfully received from the server was 7,200,100 milliseconds ago. The last packet sent successfully to the server was 7,200,100 milliseconds ago. - com.mysql.jdbc.exceptions.jdbc4.CommunicationsException: Communications link failure

可能原因:

数据库执行SQL查询速度慢,导致MySQL读超时。

解决方法:

排查是否设置了where过滤条件,以确保筛选字段已添加索引。

排查源数据表的数据是否太多。如果数据太多,建议拆分为多个任务。

查询日志找到执行阻塞的SQL,咨询数据库管理员解决。

写入报错

问题现象:

写入数据时,报错如下:Caused by: java.util.concurrent.ExecutionException: ERR-CODE: [TDDL-4614][ERR_EXECUTE_ON_MYSQL] Error occurs when execute on GROUP 'xxx' ATOM 'dockerxxxxx_xxxx_trace_shard_xxxx': Communications link failure The last packet successfully received from the server was 12,672 milliseconds ago. The last packet sent successfully to the server was 12,013 milliseconds ago. More...

可能原因:

慢查询导致SocketTimeout。TDDL默认连接数据的SocketTimeout是12秒,如果一个SQL在MySQL端执行超过12秒仍未返回,会报4614的错误。当数据量较大或服务端繁忙时,会偶尔出现该错误。

解决方法:

建议数据库稳定后,重新运行同步任务。

联系数据库管理员调整该超时时间。.

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。