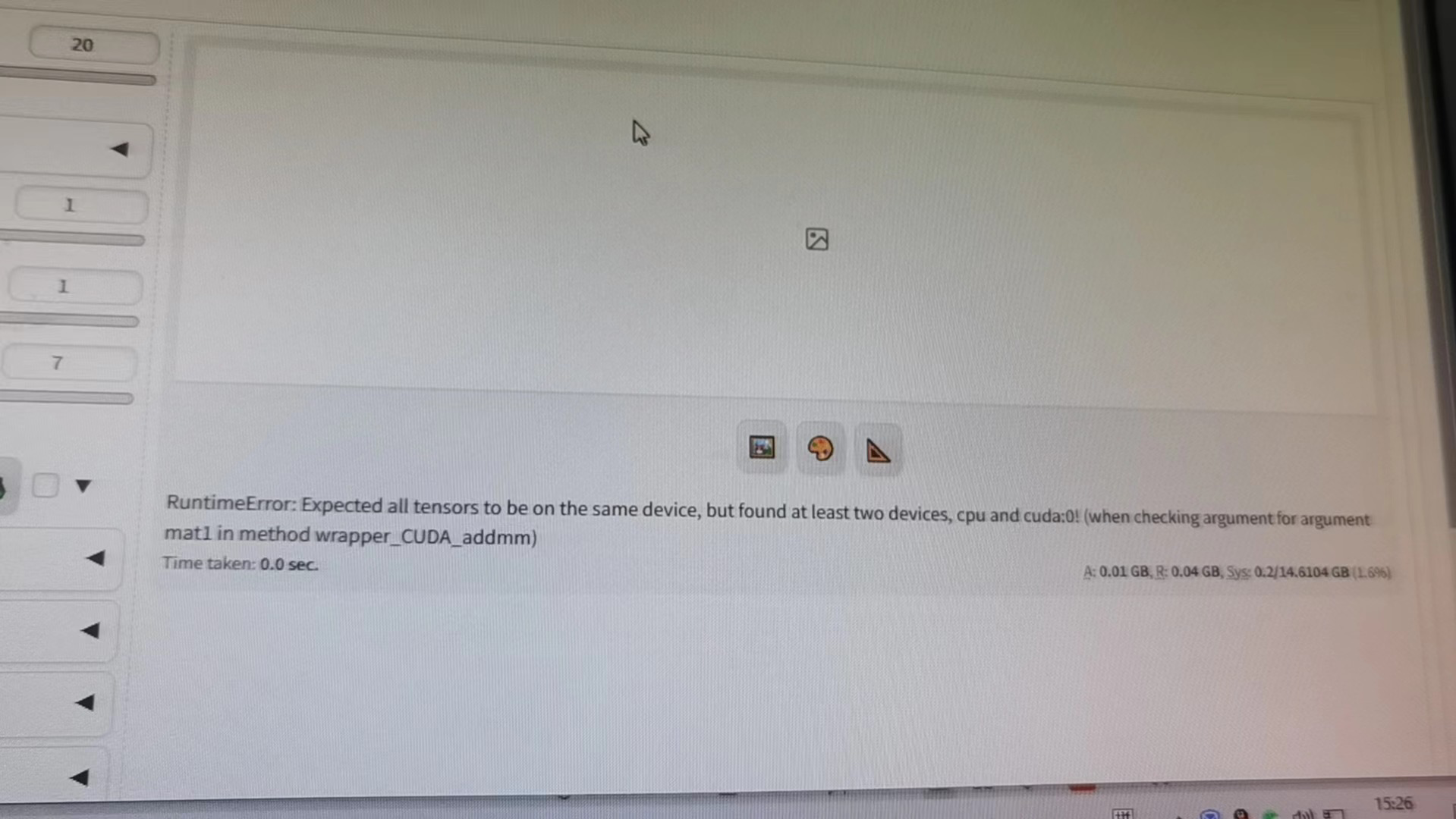

函数计算FC7的SD生成图的时候,突然报错,怎么解决?RuntimeError: Expected all tensors to be on the same device, but found at least two devices, cpu and cuda:0! (when checking argument for argument mat1 in method wrapper_CUDA_addmm)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

当运行深度学习程序时,可能会遇到 RuntimeError: Expected all tensors to be on the same device, but found at least two devices, cpu and cuda:0! 这样的错误提示,表示出现了两个设备,分别是 CPU 和 CUDA:0,而在运算过程中要求所有的张量都在同一个设备上。

出现这种错误的原因可能是:在程序中同时使用了 CPU 和 GPU 上的数据,但是没有正确地将数据移动到相应的设备上。例如,如果您希望使用 GPU 进行加速,但又没有将数据移动到 GPU 设备上,就会导致这种错误的发生。

为了解决这个问题,需要确保所有参与运算的张量都被正确地放在同一个设备上。可以考虑以下几种方法:

例如:

x = torch.tensor([1., 2., 3.], device='cuda:0')

y = torch.tensor([4., 5., 6.], device='cuda:0')

z = x + y

在这个例子中,我们已经明确指定了张量 x 和 y 都位于 CUDA 设备上,因此后续的加法运算也将在 GPU 上执行。

.to() 方法移动张量如果您已经创建了一个张量,但忘记了指定它的位置,可以使用 .to() 方法将其移动到特定的设备上:

x = torch.tensor([1., 2., 3.])

x = x.to('cuda:0')

在这里,我们将原本位于 CPU 上的张量 x 移动到了 CUDA 设备上。

另外,还可以使用 .cuda() 方法来将张量移动到第一个可用的 CUDA 设备上:

x = torch.tensor([1., 2., 3.]).cuda()

如果要在运行时动态切换张量所在的设备,可以使用 .to() 或 .cuda() 方法并传递相应的参数,如下所示:

# 将张量移动到指定的设备上

x.to(device)

# 或者将张量移动到当前活跃的设备上

x.cuda()

# 如果需要指定特定的 CUDA 设备编号

x.cuda(0)

需要注意的是,虽然可以手动移动张量的位置,但在大型程序中,这样做可能会变得很麻烦。因此,在编写代码时,最好始终确保所有张量都被正确地标记在它们所属的设备上。

这个错误是因为在计算过程中,有至少两个张量在不同的设备上(CPU和CUDA:0)。为了解决这个问题,您需要确保所有张量都在同一个设备上。您可以使用.to()方法将张量移动到相同的设备上。例如:

tensor1 = tensor1.to('cuda:0')

tensor2 = tensor2.to('cuda:0')

如果您使用的是PyTorch,可以使用torch.device来指定设备:

device = torch.device('cuda:0' if torch.cuda.is_available() else 'cpu')

tensor1 = tensor1.to(device)

tensor2 = tensor2.to(device)

在进行这些操作后,您的代码应该可以正常运行。