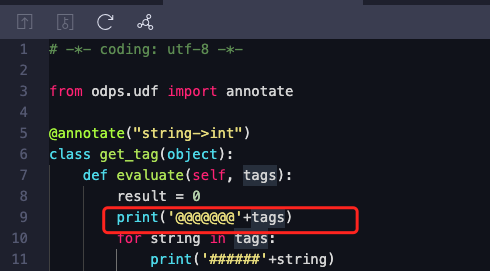

DataWorks资源里python运行时候,中途打印日志怎么看?或者怎么调试?

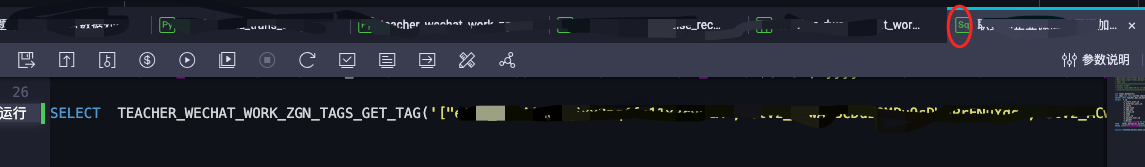

在sql文件通过函数调用

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

是shell 调用的 还是用来开发udf之类的,函数是执行在计算的机器上的 这里的日志主要返回的是调度机器上执行 所以看不到 建议在本地开发调试的时候看下 具体可能需要咨询下mc同学看下,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

您可以在 DataWorks 的 PySpark 脚本中使用 logging 模块来实现日志打印和调试,以便于查看脚本执行情况。以下是简单的示例:

import logging

logging.basicConfig(level=logging.INFO)

logging.info('Debugging message')

您还可以使用 IDE 进行调试,通过单步执行、断点等方式查看日志输出。

在DataWorks中,Python运行资源可以方便地打印日志,以便查看运行过程中的状态和结果。以下是一些调试Python运行资源的建议:

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。