DataWorks中mysql怎么配置分库分表同步?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

在DataWorks中,配置MySQL分库分表同步的步骤如下:

首先,您需要准备好源端和目标端的MySQL数据库。确保这些数据库已经创建并配置好相应的分库分表规则。

接下来,您可以在DataWorks控制台中创建数据集成任务。在任务配置页面中,选择源端和目标端的MySQL数据库作为数据源。

在任务类型中,选择"全量+增量"的数据同步方式。这种方式可以保证源端和目标端数据的一致性,同时支持实时同步增量数据。

在任务配置页面中,您需要设置源端和目标端的分库分表规则。具体来说,您需要指定每个库、每个表的名称以及对应的字段信息。此外,还需要设置同步模式(全量或增量)以及同步方向(从源到目标或从目标到源)。

完成上述配置后,您可以启动数据同步任务。在任务执行过程中,DataWorks会根据您设置的分库分表规则将源端数据同步至目标端。

最后,您可以在DataWorks控制台中查看和管理已创建的数据同步任务。例如,可以查看已同步的数据量和记录数,以及对任务进行暂停、恢复等操作。

在DataWorks中,配置MySQL分库分表同步可以通过向导模式或脚本模式来完成。您可以将分库分表数据同步至目标单表。

首先,您需要完成MySQL和DataWorks的数据源配置。在MySQL Reader端可以选择多个MySQL数据表,这些表的结构需要保持一致。然后,在DataWorks上建立同步任务,选择数据源名称来控制同步读取和写入。

除了同步至MaxCompute,DataWorks还支持将分库分表数据实时写入Hologres。如果需要进行全增量实时同步,DataWorks同样提供了一键实时同步的能力。

此处的“分库分表”通常是指多个MySQL写入同一个目标表,而不是每个数据库写入不同的目标表。如果您想要支持整库级别的分库分表,需要在数据集成站点建立任务并选择整库分库分表能力。

在 DataWorks 中,可以从 MySQL 数据库中进行分库分表同步。要实现此功能,可以采取以下步骤:

如何一次性同步多个MySQL(RDS)表?

在数据集成的向导模式下,配置好MySQL的数据源后,在选择表的输入框里,可以不停的输入表名称的,凡是选中的表,都会被这个任务一次性的同步到目的端去。

【注意事项】

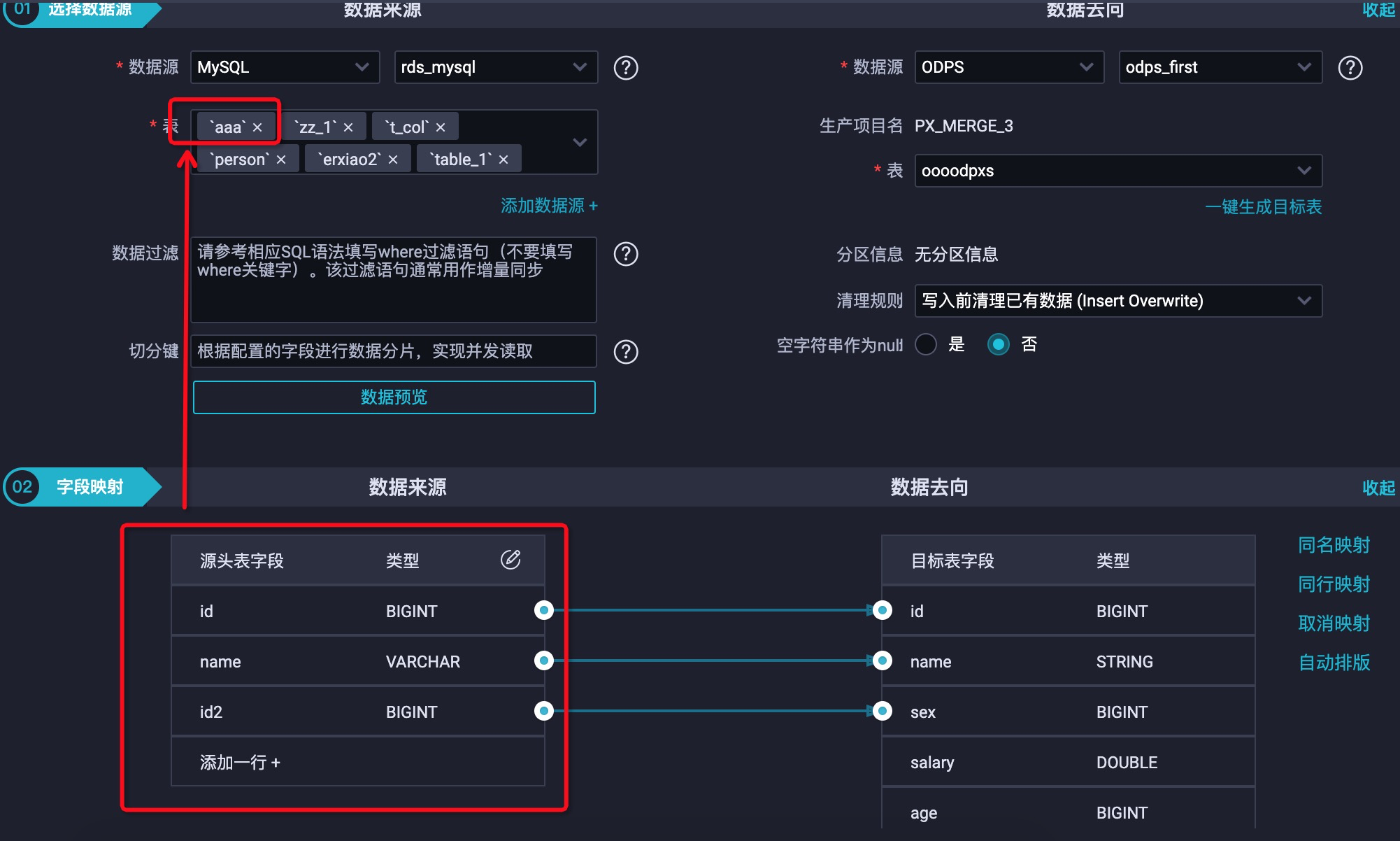

这里面选择的多个表的schema需要保持一致,否则执行时会报错。

如下图虽然是选择了多个表,但是配置字段映射时,其实只会调取第一个表的schema,并不会报错,但任务执行时就会报错了。

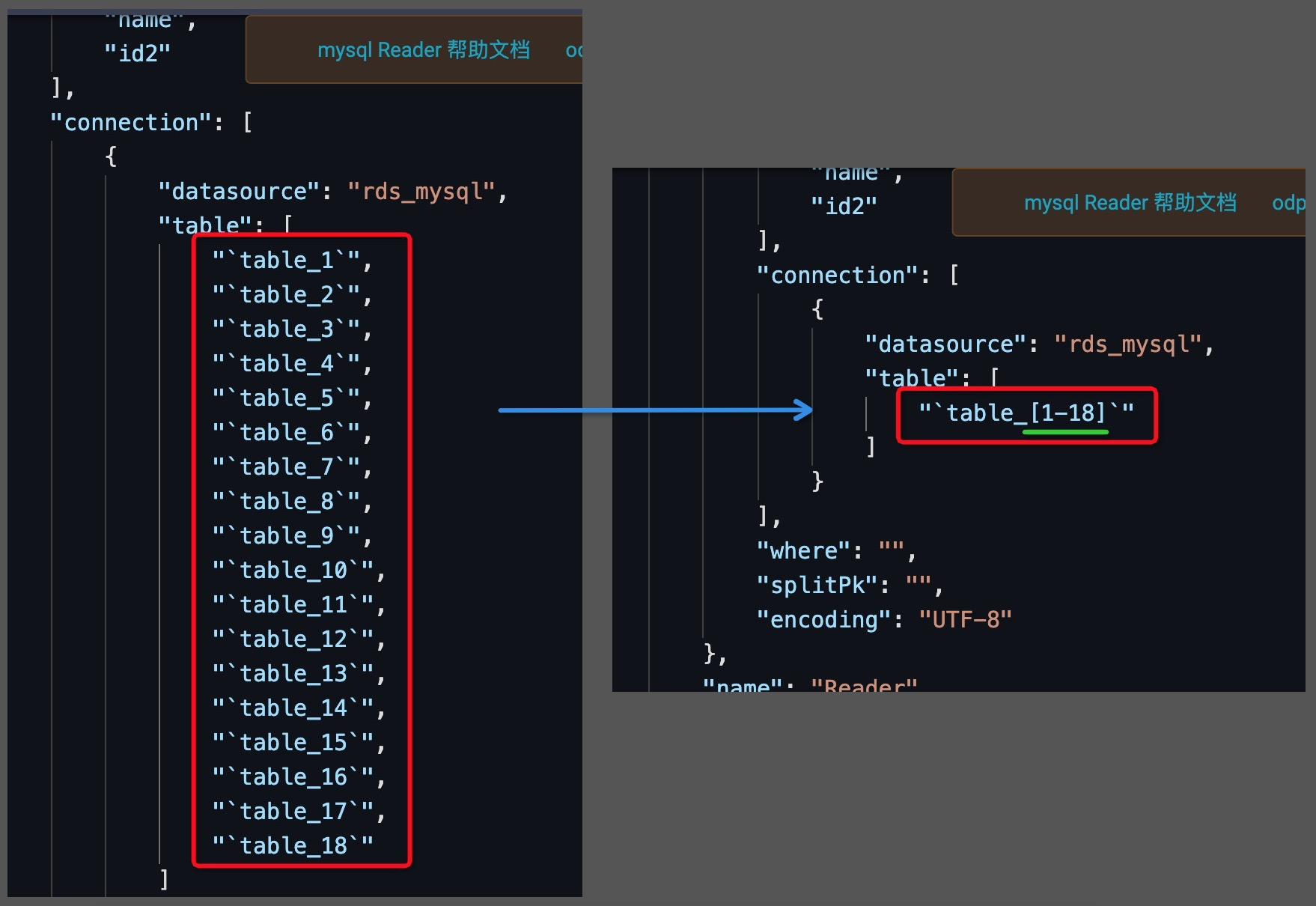

同步表名有规律的高级技巧

上面的模式对于一般情况下可能最够使用了,但是还有些用户的表非常多,比如几百个,即便是一个个去选择,也是个非常累的事情,但是这些表的命名都很有规律,比如table_001, table_002, table_003,.... table_xxx,此时切换到脚本模式后,使用特殊命名的方法就可以一次性设置所有表了,如下图:

具体参数的使用请参考MySQL Reader。

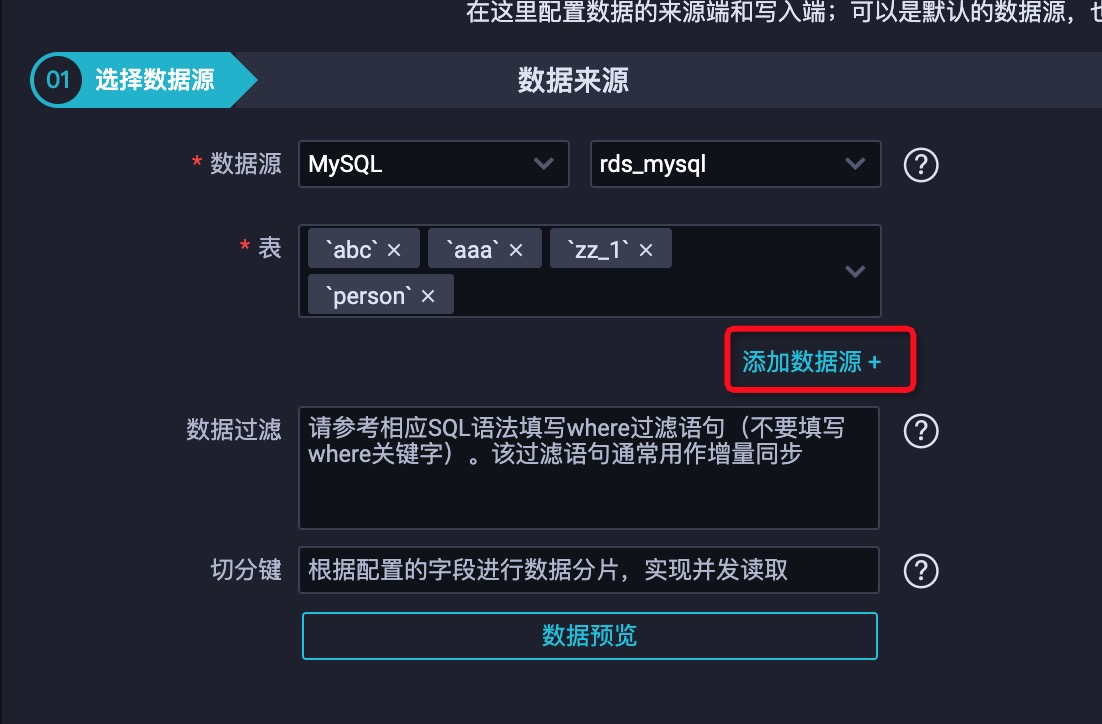

同步多个库下多个表

如果要一次性同步多个库下多个表,也是可以在向导模式下配置的,只需要点击“添加数据源+”就可以增加一个数据源了,而一个数据源对应一个库,由此也就实现了同步多库多表

设置多库之后的效果:

如果每个库下还有多个表命名有规律,此时依旧可以切换到脚本模式,然后使用特殊表名命名规则来支持。

注意:

1、目前只支持mysql数据源;

2、源端的表结构要相同,不同的数据库密码要相同;

3、多个库要添加多个数据源;

可以用同步解决方案里整库离线同步;,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。