dataworks突然无法访问hive怎么办?

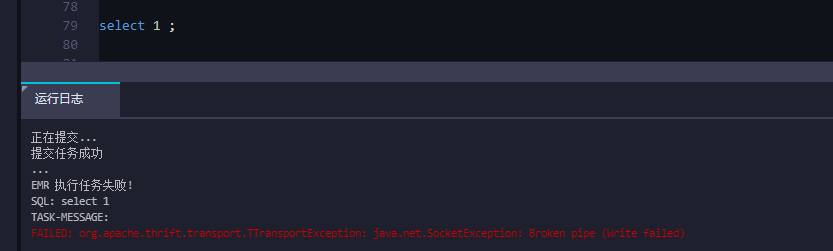

failed: org.apache.thrift.transport.TTransportException: java.net.SocketException: Broken pipe (Write failed)

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

1)右上角 绑定引擎重新初始化下资源组 还能成功吗

2)“DATAWORKS_SESSION_DISABLE”:false 任务右侧 高级设置关闭下session复用 再看下完整的报错日志,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks无法访问Hive时,出现的错误提示为:failed: org.apache.thrift.transport.TTransportException: java.net.SocketException: Broken pipe (Write failed)。这个错误通常是由于网络连接问题或数据传输过程中出现了问题导致的。

以下是一些可能的解决方案:

检查网络连接:确保DataWorks与Hive服务器之间的网络连接正常,并且可以互相通信。可以尝试使用ping命令测试网络连通性。

检查Hive服务是否正常运行:如果Hive服务未启动或崩溃,DataWorks将无法访问它。请确保Hive服务正在运行并且没有问题。

检查权限设置:如果您使用的是Kerberos认证,需要确保HiveServer2与metastore的principal一致。同时,也需要验证DataWorks是否有权访问Hive服务器和相关数据库。

检查Hive元数据:目前HDFS Reader不支持对Hive元数据的数据库进行访问查询,所以如果Hive元数据存储存在问题,也有可能导致DataWorks无法正常访问。

如果问题依旧存在,您可以尝试在DataWorks控制台重新创建一个数据集,选择Hive数据源,并选择需要同步的Hive表。

这个错误通常是由于Hive服务器与DataWorks之间的网络连接出现问题导致的。以下是一些可能的解决方法:

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。