热词版能否支持onnx?

ONNX(Open Neural Network Exchange)格式。热词版是针对语音唤醒或语音指令识别等特定任务的模型,通常采用定制的、轻量级的深度学习架构。

ONNX是一种用于表示深度学习模型的开放标准,它允许不同深度学习框架之间的模型互操作性。然而,对于特定的应用和模型,是否支持ONNX格式取决于具体的软件、库或服务提供商。

如果你希望在热词版中使用ONNX格式的模型,你可能需要将模型转换为热词版所支持的格式,或者与热词版的开发者或技术支持团队联系,以了解是否有其他适配或集成的方法可用。

ONNX是一种开放式的文件格式,用于存储训练好的模型。通过ONNX可以将不同框架的模型数据存储成统一的格式,便于在同一环境下测试不同框架的模型。

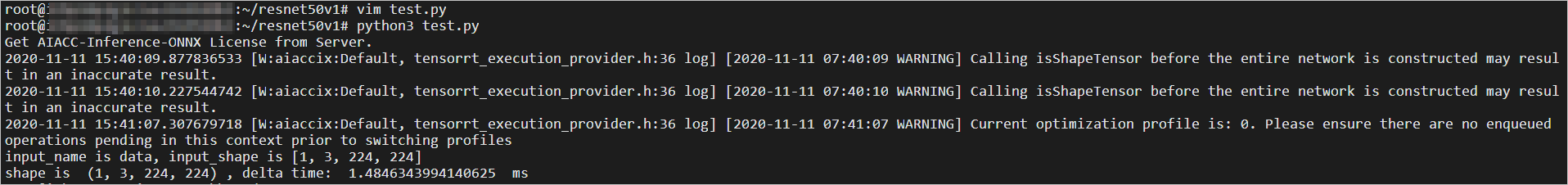

AIACC-Inference(AIACC推理加速) ONNX版通过对模型计算图进行切割、执行层间融合,以及高性能OP实现,大幅提升推理性能。通过AIACC-Inference(AIACC推理加速) ONNX版提供的ONNX模型优化软件接口,您可以对基于PyTorch、MXNet及其它支持导出ONNX模型框架开发的深度学习模型进行推理优化。

AIACC-Inference(AIACC推理加速) ONNX版提供了FP32和FP16两种精度的模型优化选项,其中FP16精度的模型可以利用NVIDIA Volta和Turing架构下的Tensor Core硬件,进一步提升在V100、T4 GPU上的推理性能。