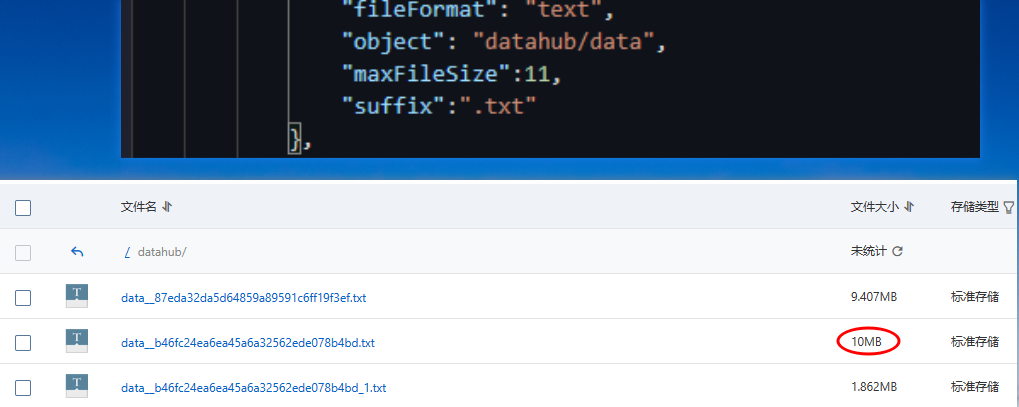

DataWorks中oss数据源脚本中设置了maxFileSize为11MB,但最后还是按照10M去切分?

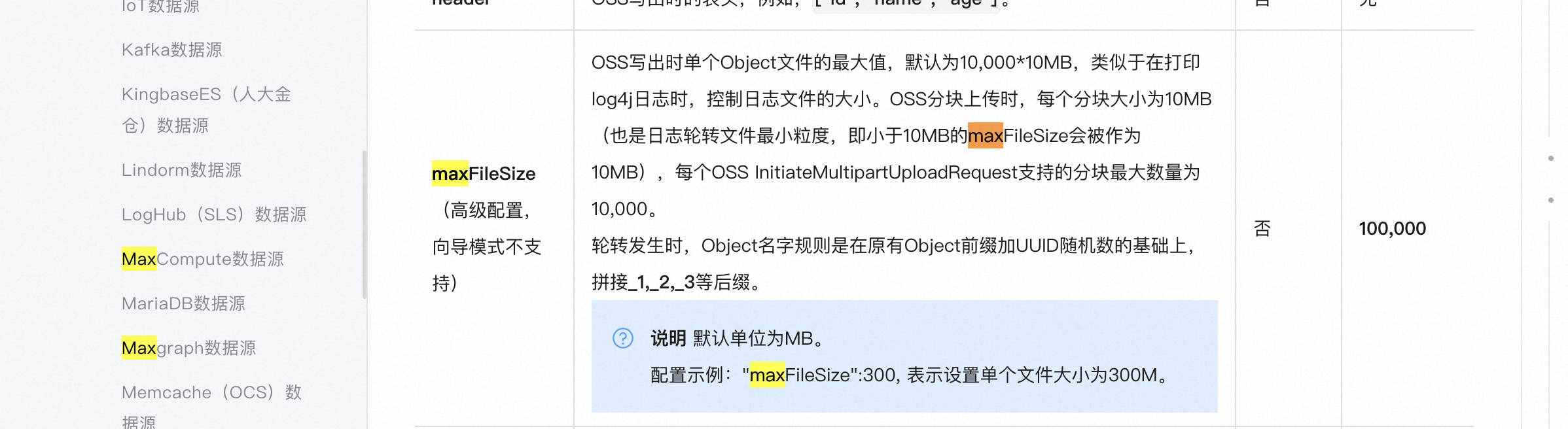

不对吧,上面说最大可配置10,000*10MB,是不是只能配置10的整数倍才行

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

这可能是由以下原因导致的:

DataWorks OSS Reader/Writer 的maxFileSize限制是10MB。

DataWorks本身对OSS数据源设置的maxFileSize限制是10MB。即使在OSS数据源的配置中设置了11MB,但在实际使用OSS Reader 或Writer时,仍然会使用10MB。

OSS存储桶本身对单文件大小有限制。

阿里云OSS存储桶单文件默认最大只能到5GB。如果您上传的文件超过了这个限制,OSS存储桶可能会自动分块。

推荐的解决方法是:

对OSS存储桶和DataWorks OSS数据源,都设置相同的maxFileSize。

不要超过OSS存储桶对单个文件的限制(5GB)。尽量保持在10MB以下。

如果确实需要上传超过10MB的文件,可以考虑分块上传。

您也可以提交工单,要求DataWorks扩大OSS Reader/Writer的maxFileSize限制。不过不建议超过OSS单文件大小限制。

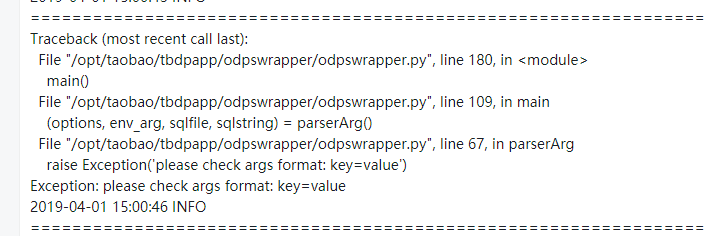

key=value,Q:Exception: please check args format: key=value

A:一般报上面的问题是因为您的参数里有空格:40day =201902 day=20190301,在参数名和等号之间有一个空格。这个方便提供下截图 以及detail log链接吗

配置参考这个哈 默认是10m 看截图最大也是10m https://help.aliyun.com/zh/dataworks/user-guide/oss-data-source?spm=a2c4g.11186623.0.0.633a48da8R1CUQ#task-2311246

辛苦发一下detail log链接,此回答整理自钉群“DataWorks交流群(答疑@机器人)”

DataWorks基于MaxCompute/Hologres/EMR/CDP等大数据引擎,为数据仓库/数据湖/湖仓一体等解决方案提供统一的全链路大数据开发治理平台。