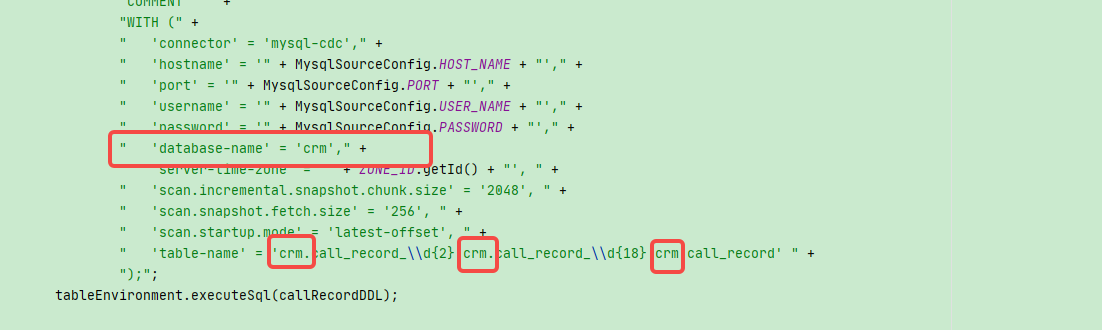

Flink CDC中这种情况怎么解决?多表名的时候得带库名称。

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

数据类型不匹配:如果在 Flink CDC 中遇到字段类型不匹配的问题,可以考虑使用类型转换函数(如 CAST)将字段类型进行转换,以使其匹配。这样可以避免隐式类型转换引发的错误。

数据丢失或延迟:如果在 Flink CDC 中遇到数据丢失或延迟的问题,可能需要检查配置、并行度设置、资源利用率等因素,并确保 Flink 作业的状态和 checkpoint 配置正确。

唯一键冲突:如果在 Flink CDC 中进行写入操作时遇到唯一键冲突的问题,可以考虑使用 Upsert 或幂等性写入来解决该问题。另外,也可以调整 Flink CDC 的重启策略或增加处理异常情况的逻辑。

并发性问题:Flink CDC 中的并发性问题可能涉及同步、锁定、分区和任务调度等方面。在解决并发性问题时,需要仔细检查代码逻辑、并行度设置、数据分区策略和资源调度等因素。

包括库名和表名。例如,如果您需要读取db1数据库中的table1表和table2表,您可以使用以下SQL语句:

sql

Copy

SELECT FROM db1.table1

UNION ALL

SELECT FROM db1.table2

在上述SQL语句中,使用了db1.table1和db1.table2来指定表的全名,其中db1是库名,table1和table2是表名。

如果您使用Flink的Table API来编写代码,也可以使用Catalog和Database来指定库和表。例如,您可以使用以下代码来指定库和表:

scala

Copy

val tableEnv = StreamTableEnvironment.create(env)

// 创建Catalog和Database

val catalog = new GenericInMemoryCatalog("my_catalog")

val db = new GenericInMemoryCatalog("my_database", catalog)

// 将Catalog和Database注册到TableEnvironment中

tableEnv.registerCatalog("my_catalog", catalog)

tableEnv.registerDatabase("my_database", db)

// 使用Table API查询表

val table1 = tableEnv.sqlQuery("SELECT FROM my_catalog.my_database.table1")

val table2 = tableEnv.sqlQuery("SELECT FROM my_catalog.my_database.table2")

在上述示例中,使用了my_catalog.my_database.table1和my_catalog.my_database.table2来指定表的全名,其中my_catalog是Catalog名,my_database是Database名,table1和table2是表名。

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。