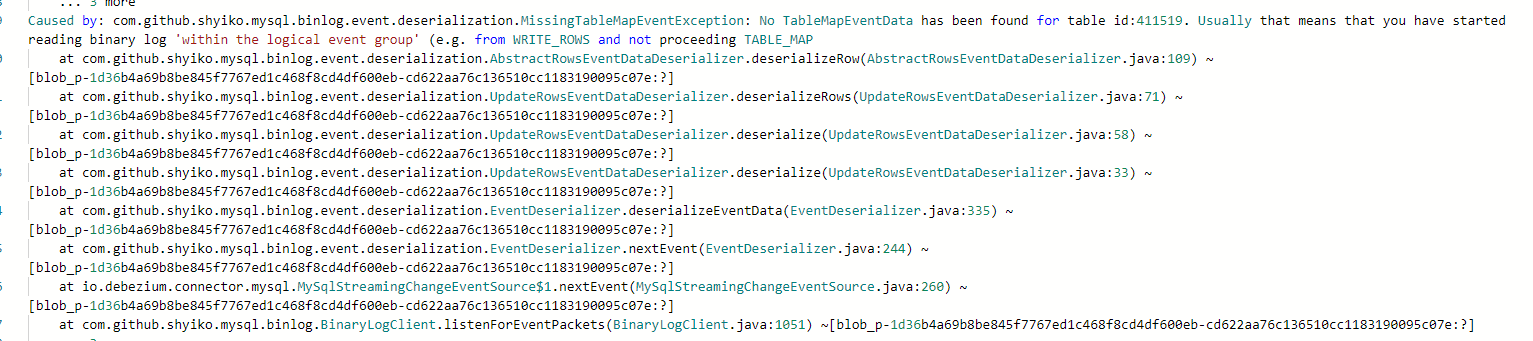

flinkcdc运行着突然出现这个异常怎么解决呢?

版权声明:本文内容由阿里云实名注册用户自发贡献,版权归原作者所有,阿里云开发者社区不拥有其著作权,亦不承担相应法律责任。具体规则请查看《阿里云开发者社区用户服务协议》和《阿里云开发者社区知识产权保护指引》。如果您发现本社区中有涉嫌抄袭的内容,填写侵权投诉表单进行举报,一经查实,本社区将立刻删除涉嫌侵权内容。

根据您提供的信息,Flink CDC 运行时出现了 java.lang.OutOfMemoryError 异常,这通常是因为 JVM 的内存不足,无法分配足够的内存空间来执行操作,从而导致程序崩溃。要解决这个问题,可以采取以下几种方法:

增加 JVM 的内存限制

可以通过修改 Flink CDC 运行时的 JVM 参数,增加 JVM 的内存限制,以提高程序的内存容量和性能。例如,可以通过增加 -Xmx 参数来指定 JVM 的最大堆内存大小,例如 -Xmx4g 表示最大堆内存大小为 4 GB。

优化程序的内存使用

可以通过对程序的内存使用进行优化,减少不必要的内存占用和内存泄漏,以提高程序的内存使用效率和性能。例如,可以使用 Java Profiler 工具来检查程序的内存使用情况,找出内存占用较高的对象和代码块,并进行优化和调整。

减少数据的存储和处理

可以通过减少数据的存储和处理,降低程序的内存占用和负荷。例如,可以使用压缩算法对数据进行压缩,减少数据存储的空间,或者使用流式处理的方式,减少数据处理的负荷。

增加系统的硬件资源

如果以上方法无法解决问题,可以考虑增加系统的硬件资源,例如 CPU、内存、硬盘等,以提高系统的性能和扩展性。需要注意的是,增加硬件资源可能会带来一定的成本和管理负担,需要根据实际情

实时计算Flink版是阿里云提供的全托管Serverless Flink云服务,基于 Apache Flink 构建的企业级、高性能实时大数据处理系统。提供全托管版 Flink 集群和引擎,提高作业开发运维效率。